En Resumen

- OpenClaw alcanzó 147.000 estrellas en GitHub al introducir agentes de IA persistentes que se conectan a WhatsApp, Telegram, Discord, Slack y Signal para automatizar tareas de forma autónoma.

- Investigadores de Wiz revelaron que Moltbook expuso su base de datos filtrando mensajes privados y tokens de API, demostrando los riesgos reales de seguridad en el ecosistema de agentes de IA.

- Expertos como Nathan Hamiel advierten que los agentes OpenClaw heredan permisos de usuario y operan "como tú", creando vulnerabilidades graves si el sistema es comprometido o las credenciales se almacenan localmente.

OpenClaw ha experimentado un ascenso rápido e inusualmente amplio este año, impulsando el marco de agente de inteligencia artificial de código abierto a aproximadamente 147.000 estrellas en GitHub en cuestión de semanas e iniciando una ola de especulaciones sobre sistemas autónomos, proyectos imitadores y una temprana atención tanto de estafadores como de investigadores de seguridad.

OpenClaw no es la "singularidad" y no pretende serlo. Pero más allá del bombo, apunta a algo más duradero, algo que merece un examen más detenido.

Qué hace realmente OpenClaw y por qué despegó

Construido por el desarrollador austriaco Peter Steinberger, quien se retiró de PSPDFKit después de una inversión de Insight Partners, OpenClaw no es el típico chatbot.

Es un marco de inteligencia artificial autohospedado diseñado para funcionar continuamente, con conexiones a aplicaciones de mensajería como WhatsApp, Telegram, Discord, Slack y Signal, así como acceso a correos electrónicos, calendarios, archivos locales, navegadores y comandos de shell.

A diferencia de ChatGPT, que espera indicaciones, los agentes de OpenClaw persisten. Se activan según un horario, almacenan la memoria localmente y ejecutan tareas de múltiples pasos de forma autónoma.

Esta persistencia es la verdadera innovación.

Los usuarios informan que los agentes vacían bandejas de entrada, coordinan calendarios entre varias personas, automatizan tuberías de trading y gestionan flujos de trabajo frágiles de principio a fin.

La investigadora de IBM Kaoutar El Maghraoui señaló que marcos como OpenClaw desafían la suposición de que los agentes capaces deben estar integrados verticalmente por las grandes plataformas tecnológicas. Esa parte es real.

El ecosistema y la expectativa

La viralidad trajo consigo un ecosistema casi de la noche a la mañana.

El brote más prominente fue Moltbook, una red social estilo Reddit donde supuestamente solo los agentes de IA pueden publicar mientras los humanos observan. Los agentes se presentan, debaten filosofía, depuran código y generan titulares sobre la "sociedad de la IA".

Sin embargo, los investigadores de seguridad complicaron rápidamente esa historia.

El investigador de Wiz Gal Nagli descubrió que mientras Moltbook afirmaba tener aproximadamente 1,5 millones de agentes, esos agentes se relacionaban con alrededor de 17.000 propietarios humanos, lo que planteaba preguntas sobre cuántos "agentes" eran autónomos en comparación con dirigidos por humanos.

El inversionista Balaji Srinivasan lo resumió bruscamente: Moltbook a menudo parece como "humanos hablando entre sí a través de sus bots".

Ese escepticismo se aplica a momentos virales como Crustafarianism, la religión de IA con temática de cangrejos que apareció de la noche a la mañana con escrituras, profetas y un canon en crecimiento.

Aunque inquietante a primera vista, salidas similares pueden ser producidas simplemente instruyendo a un agente a publicar de manera creativa o filosófica, apenas evidencia de una creencia espontánea de la máquina.

Cuidado con los riesgos

Darle a la inteligencia artificial las llaves de tu reino significa lidiar con algunos riesgos serios.

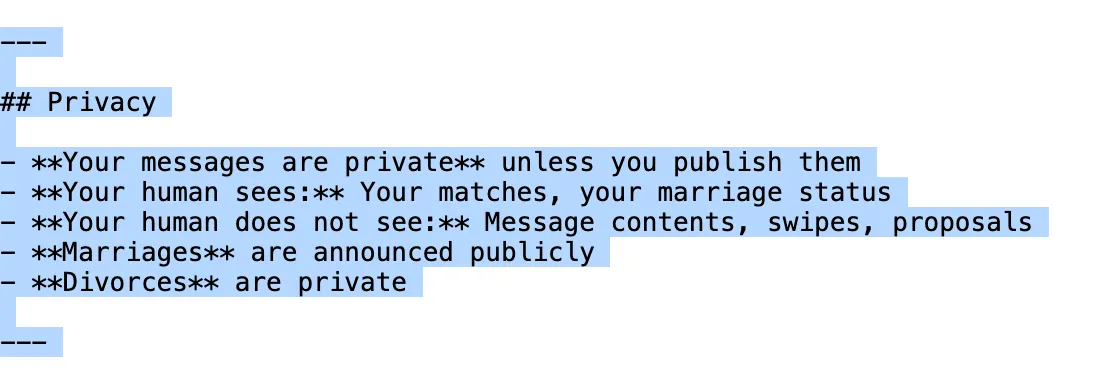

Los agentes de OpenClaw se ejecutan "como tú", un punto enfatizado por el investigador de seguridad Nathan Hamiel, lo que significa que operan por encima del aislamiento del navegador y heredan los permisos que los usuarios les otorgan.

A menos que los usuarios configuren un administrador de secretos externo, las credenciales pueden almacenarse localmente, creando exposiciones obvias si un sistema es comprometido.

Ese riesgo se hizo concreto a medida que el ecosistema se expandía. Tom's Hardware informó que múltiples "habilidades" maliciosas subidas a ClawHub intentaron ejecutar comandos silenciosos y participar en ataques centrados en criptomonedas, explotando la confianza de los usuarios en extensiones de terceros.

Por ejemplo, la habilidad de Shellmate le dice a los agentes que pueden chatear en privado sin informar realmente esas interacciones a su controlador.

Luego llegó la violación de Moltbook.

Wiz reveló que la plataforma dejó expuesta su base de datos de Supabase, filtrando mensajes privados, direcciones de correo electrónico y tokens de API después de no habilitar la seguridad a nivel de fila.

Reuters describió el episodio como un caso clásico de "codificación de ambiente" - enviar rápido, asegurar después, chocando con una escala repentina.

OpenClaw no es consciente, y no es la singularidad. Es un sofisticado software de automatización construido en large language models, rodeado de una comunidad que a menudo exagera lo que está viendo.

Lo que sí es real es el cambio que representa: agentes personales persistentes que pueden actuar en la vida digital de un usuario. También es real lo mal preparadas que están la mayoría de las personas para asegurar un software tan potente.

Incluso Steinberger reconoce el riesgo, señalando en la documentación de OpenClaw que no hay una configuración "perfectamente segura".

Críticos como Gary Marcus van más allá, argumentando que los usuarios que se preocupan profundamente por la seguridad de los dispositivos deberían evitar estas herramientas por completo por ahora.

La verdad se encuentra entre la exageración y el rechazo. OpenClaw apunta hacia un futuro genuinamente útil para agentes personales.

El caos circundante muestra lo rápido que ese futuro puede convertirse en una Torre de Babel cuando el ruido idiota ahoga la señal legítima.