En Resumen

- OpenAI vivió una turbulenta historia con el despido y posterior restitución de su CEO, Sam Altman, en medio de rumores sobre un descubrimiento llamado "Q*", que generó un caos interno.

- "Q" podría referirse a dos teorías: Q-learning, un enfoque de aprendizaje por refuerzo que permite a la IA aprender de manera autónoma, o el algoritmo Q del Sistema de Procedimiento de Prueba de Refutación de Maryland (MRPPS), que mejora las capacidades deductivas de la IA.

- Las posibles implicaciones de "Q*" son vastas, desde mejorar la resolución de problemas y la eficiencia de la IA hasta avanzar en el razonamiento deductivo y la colaboración humano-IA. Sin embargo, surgen preocupaciones éticas, de seguridad y económicas relacionadas con su desarrollo.

Lo de OpenAI fue una historia de espionaje corporativo que ni siquiera un guionista humano real podría haber imaginado. OpenAI, que desató la obsesión global con la IA el año pasado, se encontró en los titulares de la semana pasada con el despido repentino y la eventual restitución de Sam Altman, el CEO de la compañía.

Incluso con Altman de vuelta donde comenzó, queda un torbellino de preguntas, incluyendo qué sucedió detrás de escena.

Algunos describieron el caos como una batalla al estilo de "Succession" o "Game of Thrones" de HBO. Otros especularon que fue porque Altman cambió su enfoque a otras compañías como Worldcoin.

Pero la teoría más reciente y convincente dice que fue despedido debido a una sola letra: Q.

Fuentes no identificadas informaron a Reuters que la CTO de OpenAI, Mira Murati, dijo que un importante descubrimiento, descrito como "Q Star" o "Q*", fue el motivo para tomar medidas en contra de Altman, las cuales se llevaron a cabo sin la participación del presidente de la junta, Greg Brockman, quien posteriormente renunció a OpenAI en protesta.

¿Qué es exactamente "Q*" y por qué deberíamos preocuparnos? Todo se trata de los caminos más probables que el desarrollo de la IA podría tomar a partir de ahora.

Desvelando el misterio de Q*

El enigmático Q* citado por la CTO de OpenAI, Mira Murati, ha llevado a especulaciones desenfrenadas en la comunidad de IA. Este término podría referirse a una de dos teorías distintas: Q-learning o el algoritmo Q* del Sistema de Procedimiento de Prueba de Refutación de Maryland (MRPPS). Comprender la diferencia entre estas dos es crucial para comprender el impacto potencial de Q*.

Teoría 1: Q-Learning

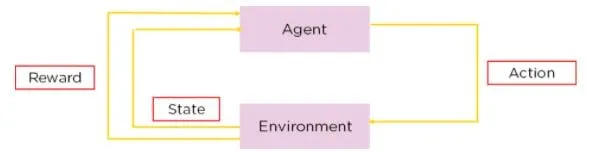

Q-learning es un tipo de aprendizaje por refuerzo, un método en el que la IA aprende a tomar decisiones mediante prueba y error. En Q-learning, un agente aprende a tomar decisiones estimando la "calidad" de las combinaciones de acción-estado.

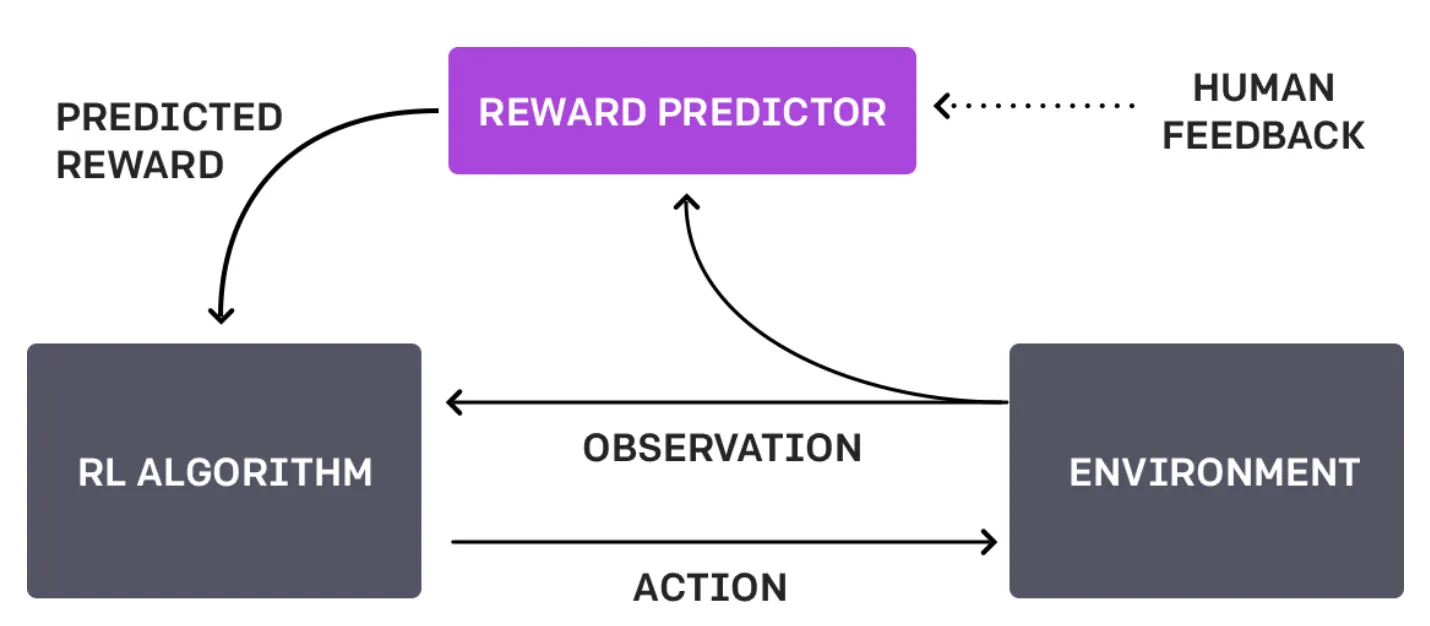

La diferencia entre este enfoque y el enfoque actual de OpenAI, conocido como Reinforcement Learning Through Human Feedback o RLHF, es que no se basa en la interacción humana y hace todo por sí mismo.

Imagina un robot navegando por un laberinto. Con el aprendizaje Q, aprende a encontrar el camino más rápido hacia la salida probando diferentes rutas, recibiendo recompensas positivas establecidas por su propio diseño cuando se acerca a la salida y recompensas negativas cuando llega a un callejón sin salida. Con el tiempo, a través de ensayo y error, el robot desarrolla una estrategia (una "tabla Q") que le indica la mejor acción a tomar desde cada posición en el laberinto. Este proceso es autónomo, basándose en las interacciones del robot con su entorno.

Si el robot utilizara RLHF, en lugar de descubrir las cosas por sí mismo, un humano podría intervenir cuando el robot llega a una intersección para indicar si la elección del robot fue acertada o no.

Esta retroalimentación podría ser en forma de comandos directos ("gira a la izquierda"), sugerencias ("prueba el camino con más luz") o evaluaciones de las elecciones del robot ("buen robot" o "mal robot").

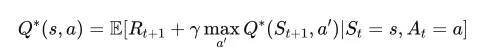

En Q-learning, Q* representa el estado deseado en el cual un agente sabe exactamente la mejor acción a tomar en cada estado para maximizar su recompensa total esperada a lo largo del tiempo. En términos matemáticos, satisface la Ecuación de Bellman.

En mayo, OpenAI publicó un artículo en el que afirmaban que "entrenaron un modelo para lograr un nuevo estado del arte en la resolución de problemas matemáticos, recompensando cada paso correcto de razonamiento en lugar de simplemente recompensar la respuesta final correcta". Si utilizaron Q-learning u otro método similar para lograr esto, se abriría un nuevo conjunto de problemas y situaciones que ChatGPT podría resolver de manera nativa.

Teoría 2: Algoritmo Q* de MRPPS

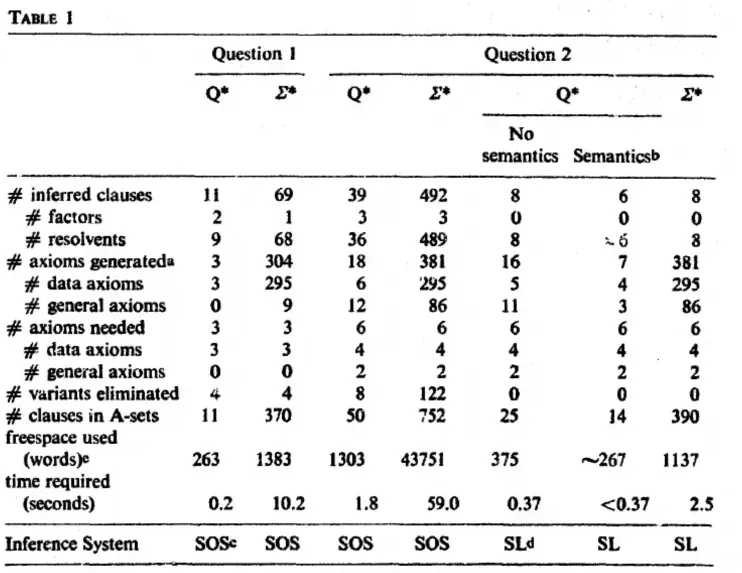

El algoritmo Q* es parte del Sistema de Procedimiento de Prueba de Refutación de Maryland (MRPPS). Es un método sofisticado para la demostración de teoremas en IA, especialmente en sistemas de preguntas y respuestas.

"El algoritmo Q∗ genera nodos en el espacio de búsqueda, aplicando información semántica y sintáctica para dirigir la búsqueda. La semántica permite terminar los caminos y explorar los caminos fructíferos", dice el artículo de investigación.

Una forma de explicar el proceso es considerar al ficticio detective Sherlock Holmes tratando de resolver un caso complejo. Él recopila pistas (información semántica) y las conecta lógicamente (información sintáctica) para llegar a una conclusión. El algoritmo Q* funciona de manera similar en la IA, combinando información semántica y sintáctica para navegar por procesos de resolución de problemas complejos.

Esto implicaría que OpenAI está un paso más cerca de tener un modelo capaz de comprender su realidad más allá de simples indicaciones de texto y más en línea con el ficticio J.A.R.V.I.S de marvel o la Baticomputadora de Batman.

Entonces, mientras que el Q-learning trata de enseñar a la IA a aprender a partir de la interacción con su entorno, el algoritmo Q se enfoca más en mejorar las capacidades deductivas de la IA. Comprender estas distinciones es clave para apreciar las posibles implicaciones de "Q". Ambos tienen un enorme potencial para avanzar en la IA, pero sus aplicaciones e implicaciones varían significativamente.

Por supuesto, todo esto es solo especulación, ya que OpenAI no ha explicado el concepto ni ha confirmado ni negado los rumores de que "Q*" -sea lo que sea- realmente exista.

Posibles implicaciones de 'Q'*

Se rumorea que "Q*" de OpenAI podría tener un impacto vasto y variado. Si se trata de una forma avanzada de Q-learning, esto podría significar un salto en la capacidad de la IA para aprender y adaptarse de manera autónoma en entornos complejos, resolviendo un conjunto completamente nuevo de problemas. Un avance de este tipo podría mejorar las aplicaciones de IA en áreas como los vehículos autónomos, donde la toma de decisiones en fracciones de segundo basada en condiciones cambiantes es crucial.

Por otro lado, si 'Q' se relaciona con el algoritmo Q de MRPPS, podría representar un avance significativo en el razonamiento deductivo y las capacidades de resolución de problemas de la inteligencia artificial. Esto sería especialmente impactante en campos que requieren un pensamiento analítico profundo, como el análisis legal, la interpretación de datos complejos e incluso el diagnóstico médico.

Independientemente de su naturaleza exacta, 'Q*' representa potencialmente un gran avance en el desarrollo de la inteligencia artificial, por lo que el hecho de que esté en el centro de un debate existencial de OpenAI es algo destacable. Podría acercarnos a sistemas de inteligencia artificial más intuitivos, eficientes y capaces de manejar tareas que actualmente requieren altos niveles de experiencia humana.

Sin embargo, con estos avances surgen preguntas e inquietudes sobre la ética de la inteligencia artificial, la seguridad y las implicaciones de sistemas de inteligencia artificial cada vez más poderosos en nuestra vida diaria y en la sociedad en general.

Lo bueno y lo malo de Q*

Beneficios potenciales de Q*:

Mejora en la resolución de problemas y eficiencia: Si Q* es una forma avanzada de Q-learning o el algoritmo Q*, podría llevar a sistemas de IA que resuelvan problemas complejos de manera más eficiente, beneficiando sectores como la salud, las finanzas y la gestión ambiental.

Mejor colaboración humano-IA: Una IA con capacidades de aprendizaje o deducción mejoradas podría mejorar el trabajo humano, lo que llevaría a una colaboración más efectiva en investigación, innovación y tareas diarias.

Avances en la automatización: 'Q*' podría llevar a tecnologías de automatización más sofisticadas, mejorando la productividad y potencialmente creando nuevas industrias y oportunidades laborales.

Riesgos y preocupaciones:

Aspectos éticos y de seguridad: A medida que los sistemas de IA se vuelven más avanzados, garantizar que operen de manera ética y segura se vuelve cada vez más desafiante. Existe el riesgo de consecuencias no deseadas, especialmente si las acciones de la IA no están perfectamente alineadas con los valores humanos.

Privacidad y seguridad: Con una IA más avanzada, aumentan las preocupaciones sobre la privacidad y la seguridad de los datos. Los sistemas de IA capaces de comprender y interactuar más profundamente con los datos podrían ser mal utilizados. Así que imagina una IA que llame a tu pareja romántica cuando le estás siendo infiel porque sabe que la infidelidad es mala.

Impactos económicos: El aumento de la automatización y las capacidades de la IA podrían llevar a la pérdida de empleos en ciertos sectores, lo que requeriría ajustes sociales y nuevos enfoques para el desarrollo de la fuerza laboral. Si una IA puede hacer casi todo, ¿por qué tener trabajadores humanos?

Desalineación de la IA: El riesgo de que los sistemas de IA desarrollen objetivos o métodos de operación que no estén alineados con las intenciones humanas y su bienestar, podría llevar a resultados perjudiciales. ¿Imagina un robot de limpieza obsesionado con el orden que tira tus documentos importantes? ¿O que elimina por completo a los creadores de desorden?

El mito de la IA generalizada

¿Dónde se encuentra el supuesto Q* de OpenAI en medio de la búsqueda de la Inteligencia Artificial General (AGI) - el Santo Grial de la investigación en IA?

AGI se refiere a la capacidad de una máquina para comprender, aprender y aplicar inteligencia en diversas tareas, similar a las habilidades cognitivas humanas. Es una forma de IA que puede generalizar el aprendizaje de un dominio a otro, demostrando verdadera adaptabilidad y versatilidad.

Independientemente de si Q es una forma avanzada de Q-learning o se relaciona con el algoritmo Q, es importante entender que esto no equivale a desarrollar AGI. Si bien 'Q*' puede representar un avance significativo en capacidades específicas de IA, AGI abarca un rango más amplio de habilidades y comprensión.

Desarrollar AGI significaría desarrollar una IA que pueda realizar cualquier tarea intelectual que un ser humano pueda hacer, un hito esquivo.

Una máquina que ha desarrollado Q no es consciente de su propia existencia y aún no puede razonar más allá de los límites de sus datos de pre-entrenamiento y algoritmos establecidos por humanos. Entonces, a pesar del revuelo, por ahora, "Q" es más como una tostadora inteligente que ha aprendido a untar su propio pan.

En cuanto a AGI que marca el fin de la civilización, podríamos estar sobreestimando nuestra importancia en el orden cósmico. Q* de OpenAI podría estar un paso más cerca de la IA de nuestros sueños (o pesadillas), pero aún no es el AGI que reflexionará sobre el significado de la vida o su propia existencia de silicio.

Recuerda, esta es la misma OpenAI que ha estado observando cautelosamente su ChatGPT como un padre que observa a un niño pequeño con un marcador, orgulloso pero perpetuamente preocupado de que dibuje en las paredes de la humanidad.

Mientras que "Q*" es un salto, AGI sigue estando a otro nivel de distancia, por lo que el muro de la humanidad sigue estando a salvo, al menos por ahora.

Editado por Ryan Ozawa.