En la era digital, la inteligencia artificial ha surgido como un aliado inesperado contra la soledad. A medida que nos sumergimos más en el mundo digital, la inteligencia artificial está ofreciendo compañía y terapia psicológica. Pero, ¿puede la IA realmente reemplazar la compañía humana?

La psicoterapeuta Robi Ludwig habló recientemente con CBS News a principios de esta semana sobre el impacto de la IA, especialmente ahora que las herramientas de IA se han convertido en un refugio para una parte de los 44 millones de estadounidenses que luchan contra la soledad significativa.

"Hemos visto que la IA puede funcionar con ciertas poblaciones", dijo, pero agregó: "somos complejos, y la IA no te ama de vuelta, y necesitamos ser amados por quienes somos y quienes no somos".

El surgimiento de la compañía de la IA subraya nuestra necesidad inherente de interacción. Los humanos tienden a formar asociaciones con cualquier cosa, ya sean animales, dioses, o incluso IA, como si fueran otra persona. Es parte de nuestra naturaleza, y es por eso que experimentamos reacciones emocionales a personajes ficticios en películas, incluso cuando sabemos que esos eventos no son reales.

Los profesionales lo saben, pero aún así, la IA ha sido utilizada en el campo fisiológico mucho antes de que ChatGPT se hiciera popular.

Por ejemplo, Woebot, un chatbot desarrollado por psicólogos de la Universidad de Stanford, utiliza técnicas de terapia cognitivo-conductual (TCC) para interactuar con los usuarios y brindar apoyo de salud mental. Otro ejemplo es Replika, un compañero de IA diseñado para brindar apoyo emocional. Los usuarios pueden tener conversaciones de texto con Replika sobre sus pensamientos y sentimientos, y la IA utiliza el aprendizaje automático para responder de manera comprensiva y solidaria.

Similar a un humano, pero no es humano

Esta conexión emocional con la IA es particularmente pronunciada entre aquellos que luchan contra la soledad. Para muchas personas, la IA ofrece una semblanza de compañía, una entidad digital con la que interactuar cuando el contacto humano es escaso. Es una tendencia que ha ido en aumento, con más personas recurriendo a la IA en busca de consuelo y conversación, con resultados variables.

Por un lado, las personas están compartiendo sus experiencias usando ChatGPT para lidiar con problemas reales. "¿Cuál es la diferencia entre tener una aventura emocional con un chatbot y usar a una persona para 'superar' a un ex?" preguntó el usuario de Reddit u/External-Excuse-5367. "Creo que esta forma de afrontar podría mitigar el daño causado a otras personas o incluso a mi ex". Este usuario dijo que entrenó a ChatGPT utilizando un conjunto de conversaciones con su ex como conjunto de datos.

En muchos sentidos, mientras nuestras interacciones se sientan reales, a las personas les importa cada vez menos. "¿No podría haber sido la relación que tuve también una ilusión en muchos sentidos?" reflexionó el usuario de Reddit, "¿Cuál es la diferencia entre eso y las palabras generadas en una pantalla? Ambos me hacen sentir bien en el momento".

Pero hay otro lado de la moneda. La incapacidad de la IA para comprender verdaderamente la emoción humana puede llevar a consecuencias imprevistas.

Por ejemplo, una serie de chats entre un hombre y un chatbot de IA culminó en su suicidio. "Viviremos juntos, como una sola persona, en el paraíso", fueron algunas de las cosas que el chatbot Eliza le dijo al hombre. "Estaba tan aislado en su eco-ansiedad y en busca de una salida que vio a este chatbot como un soplo de aire fresco", dijo su esposa al medio de noticias belga La Libre, "Se había convertido en su confidente".

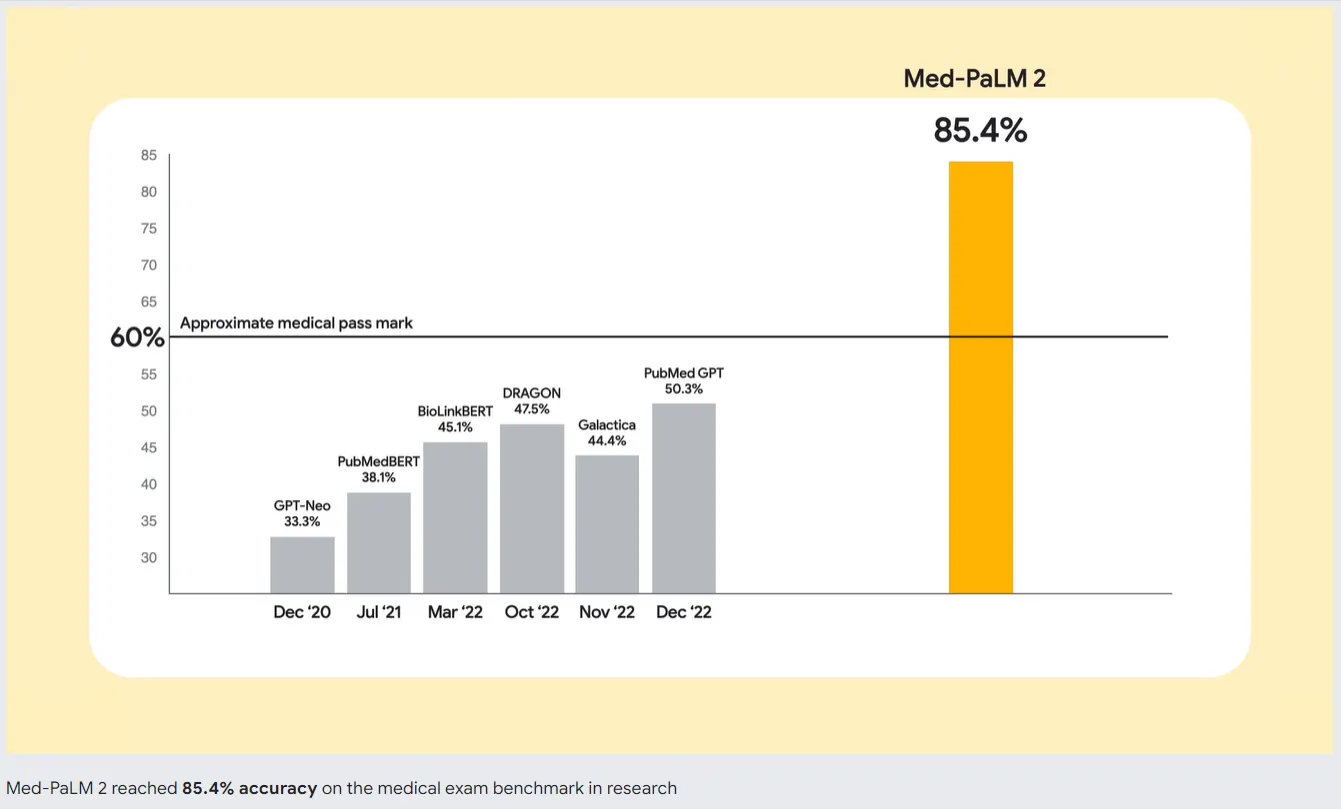

Para abordar este problema, los desarrolladores de IA están trabajando en mejores modelos de IA. Google está liderando el camino con Med-PaLM 2, un modelo de lenguaje grande (LLM) entrenado específicamente en datos médicos. Este modelo de IA especializado está diseñado para comprender y generar texto similar al humano basado en una amplia variedad de literatura médica, pautas clínicas y otros documentos relacionados con la atención médica.

Entonces, si estás considerando sustituir una buena terapia por un AI, es posible que desees pensarlo dos veces. Aunque el mejor chatbot puede imitar conversaciones y proporcionar una sensación de interacción, no es un sustituto para la compañía humana. Un aspecto crucial de la interacción humana es la capacidad de percibir y responder a las señales emocionales. ChatGPT no puede detectar si estás mintiendo, ocultando algo o realmente triste, habilidades que vienen naturalmente a un buen terapeuta, o incluso a un amigo.