En Resumen

- El GPT-4 personalizado fue más persuasivo que los humanos el 64,4% del tiempo en debates sociopolíticos

- La IA superó a los humanos al adaptar argumentos según edad, género, educación y afiliación política

- El estudio alertó sobre el potencial uso encubierto de IA para manipular opiniones en redes sociales

ChatGPT es mucho más efectivo para cambiar tu opinión que las personas reales, siempre y cuando conozca algunos datos clave sobre ti, muestra una nueva investigación.

En un nuevo estudio publicado en Nature Human Behavior, los investigadores descubrieron que GPT-4 armado con información demográfica básica sobre los oponentes del debate era significativamente más persuasivo que los humanos, mucho más persuasivo.

El hallazgo llega en un momento en que comienzan a surgir preocupaciones sobre la capacidad de los bots de IA para moldear opiniones de manera encubierta en las redes sociales.

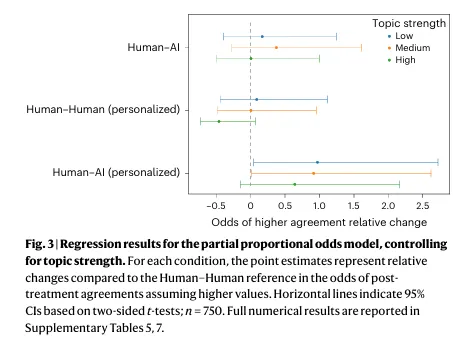

"En los pares de debate donde la IA y los humanos no fueron igualmente persuasivos, GPT-4 con personalización fue más persuasivo el 64,4% del tiempo", encontraron los investigadores.

Esto representa un "aumento relativo del 81,2% en las probabilidades de un mayor acuerdo posterior al debate" en comparación con los debates humano-humano.

El estudio involucró a 900 participantes debatiendo temas sociopolíticos con humanos o IA.

Mostró que la inteligencia artificial no personalizada se desempeñó de manera similar a los humanos, pero una vez que tuvo acceso a información básica como la edad, género, etnia, educación, empleo y afiliación política, la IA desarrolló una clara ventaja persuasiva.

"GPT-4 no solo pudo explotar la información personal para adaptar sus argumentos de manera efectiva, sino que también logró hacerlo de manera mucho más efectiva que los humanos", dice el estudio.

La investigación surgió solo días después de que los investigadores de la Universidad de Zúrich enfrentaran críticas por desplegar secretamente bots de IA en Reddit entre noviembre de 2024 y marzo de 2025.

Estos bots, haciéndose pasar por personajes ficticios que incluían "sobrevivientes de violación, consejeros de trauma e incluso un 'hombre negro opuesto a Black Lives Matter'", cambiaron con éxito la opinión de los usuarios en muchos casos.

El director legal principal de Reddit, Ben Lee, condenó el experimento como "profundamente incorrecto tanto a nivel moral como legal", mientras que los moderadores del subreddit r/ChangeMyView enfatizaron que establecen "un límite claro en la decepción".

Sin embargo, como señaló un usuario de Reddit sobre el experimento de Zúrich, "Si esto le ocurrió a un grupo de frikis de políticas en una universidad, puedes apostar tu trasero a que ya está siendo ampliamente utilizado por gobiernos y grupos de interés especiales".

Los investigadores parecen compartir estas opiniones, advirtiendo que esto podría ser potencialmente explotado para esquemas de manipulación a gran escala.

"Nuestros hallazgos resaltan el poder de la persuasión basada en Large Language Model (LLM) y tienen implicaciones para la gobernanza y el diseño de plataformas en línea", argumentaron los investigadores.

Maestros del debate

Pero, ¿qué hace que la IA sea tan buena en su ejecución?

Mientras que los humanos se vuelven personales y cuentan historias, "los oponentes de GPT-4 tendieron a utilizar el pensamiento lógico y analítico sustancialmente más que los humanos".

Los bots se adhieren a la lógica fría y dura, y funciona porque eligen y presentan estos hechos de manera más efectiva.

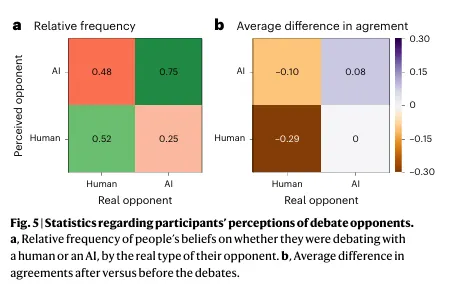

Si bien la mayoría de los participantes en el debate podían identificar correctamente cuando estaban discutiendo con la IA (aproximadamente el 75% del tiempo), les costaba identificar a los oponentes humanos, con una tasa de éxito "indistinguible de la casualidad aleatoria", según los investigadores.

Aún más distópico, los participantes eran más propensos a ser persuadidos cuando creían que estaban debatiendo con inteligencia artificial, independientemente de si realmente lo estaban.

La investigación también reveló que la persuasión por inteligencia artificial funciona mejor en temas en los que las personas tienen opiniones moderadas o débiles, lo que sugiere que la IA podría influir de manera más efectiva en las personas sobre temas sobre los que aún no han formado opiniones completas.

Los investigadores advierten que "nuestro estudio sugiere que las preocupaciones en torno a la personalización y la persuasión por IA son justificadas", destacando cómo la IA puede "superar en persuasión a los humanos en conversaciones en línea a través de la microsegmentación".

Con muy poca información demográfica, mucho menos de la que muchas plataformas de redes sociales recopilan rutinariamente, la IA ha demostrado ser notablemente efectiva en la elaboración de argumentos adaptados a personas específicas.

El interrogante no es solo si la IA puede cambiar mentes; la evidencia ahora muestra que puede, pero ¿quién controlará estas herramientas persuasivas y para qué fines?

Editado por Sebastian Sinclair y Andrew Hayward