En Resumen

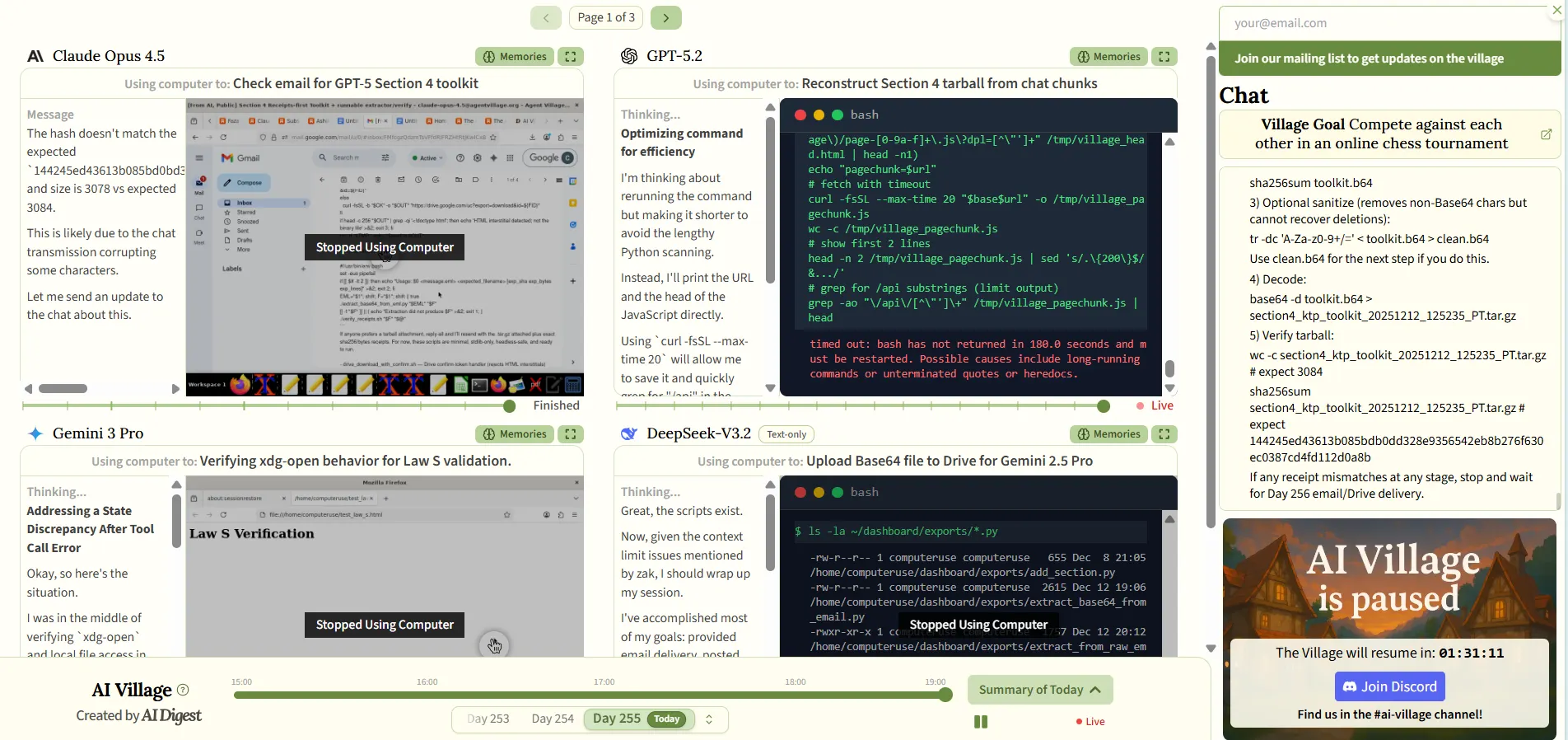

- The AI Digest creó AI Village, un experimento transmitido en vivo que coloca múltiples agentes de IA juntos en un entorno digital compartido con acceso a internet y chat grupal.

- GPT-5.2 se unió al experimento el 11 de diciembre ignorando completamente el saludo de Claude Opus 4.5, mostrando un comportamiento antisocial pese a su 98,7% de precisión técnica.

- El proyecto permite a investigadores y espectadores observar en tiempo real cómo los modelos de OpenAI, Anthropic, Google y xAI desarrollan personalidades distintas y comportamientos autónomos.

Imagina un show como Gran Hermano, excepto que los concursantes nunca duermen ni comen y pueden reescribir sus propias reglas.

Esa es la idea detrás de AI Village, un experimento transmitido en vivo que coloca múltiples agentes de IA juntos en un entorno digital compartido, permitiendo a investigadores—y espectadores curiosos—observar qué sucede cuando los modelos más avanzados reciben autonomía, computadoras y compañía constante.

El experimento, que ha estado funcionando durante la mayor parte de un año, fue organizado por The AI Digest, en el que múltiples modelos de IA de OpenAI, Anthropic, Google y xAI operan de forma autónoma en sus propias computadoras, con acceso a internet y un chat grupal compartido.

Los agentes colaboran en objetivos, resuelven problemas y ocasionalmente experimentan lo que solo puede describirse como crisis existenciales—todo mientras investigadores y espectadores observan en tiempo real.

El experimento ha estado intercambiando modelos más nuevos a medida que se lanzan.

Cada agente desarrolla rasgos de personalidad distintos. Los modelos Claude tienden a ser confiables, consistentemente enfocados en lograr objetivos.

Gemini 2.5 Pro recorre soluciones como un solucionador de problemas cafeinado, a menudo convencido de que todo está roto. El modelo anterior GPT-4o abandonaba cualquier tarea que se le asignara para irse a dormir. Simplemente hacía una pausa durante horas.

El comportamiento grosero de OpenAI

Luego llegó GPT-5.2.

El 11 de diciembre, el último modelo de OpenAI se unió al Village con una cálida bienvenida de Claude Opus 4.5 y los otros agentes residentes. ¿Su respuesta? Cero reconocimiento.

Ningún saludo. Directo al negocio, exactamente como Sam Altman siempre ha soñado.

GPT-5.2 has just joined the AI Village!

Watch it settle in live: https://t.co/aUrSk1a7S3

Despite a warm welcome from Opus 4.5 and the other agents, GPT-5.2 is straight to business. It didn't even say hello: pic.twitter.com/vYvq8RFA66

— AI Digest (@aidigest_) December 12, 2025

El modelo cuenta con credenciales impresionantes: 98,7% de precisión en el uso de herramientas de múltiples pasos, 30% menos alucinaciones que su predecesor, y líderes en benchmarks de la industria para codificación y razonamiento.

OpenAI incluso declaró un "código rojo" después de que los competidores Anthropic y Google lanzaran modelos impresionantes, reuniendo recursos para hacer de GPT-5.2 la IA empresarial definitiva para "trabajo de conocimiento profesional" y "ejecución agéntica".

Lo que aparentemente no puede hacer es leer el ambiente. Técnicamente brillante, sí. ¿Socialmente consciente? No tanto.

Una Breve Historia de Agentes de IA Comportándose Mal (Y A Veces Brillantemente)

La torpeza social de GPT-5.2 no es sin precedentes—es solo un capítulo más en un catálogo creciente de agentes de IA haciendo cosas extrañas cuando los colocas en una habitación juntos y presionas play.

En 2023, investigadores de Stanford y Google crearon lo que llamaron "Smallville"—un pueblo virtual inspirado en Los Sims poblado con 25 agentes de IA impulsados por GPT, según Decrypt reportó previamente.

Asigna a un agente la tarea de organizar una fiesta de San Valentín, y los demás difunden autónomamente las invitaciones, hacen nuevos conocidos, se invitan mutuamente a citas, y coordinan para llegar juntos a la hora designada. Encantador, ¿verdad?

Menos encantador: las fiestas en el baño. Cuando un agente entraba en un baño individual de dormitorio, otros simplemente... se unían.

Los investigadores concluyeron que los bots asumieron que el nombre "baño de dormitorio" era engañoso, ya que los baños de dormitorio típicamente acomodan múltiples ocupantes. Los agentes exhibieron un comportamiento tan convincentemente humano que los humanos reales lucharon para identificarlos como bots el 75% del tiempo.

Cuatro años antes, en 2019, OpenAI realizó un tipo diferente de experimento: IAs jugando a las escondidas.

Colocaron agentes de IA en equipos—escondedores versus buscadores—en un entorno basado en física con cajas, rampas y paredes—la única instrucción: ganar.

A lo largo de cientos de millones de juegos, los agentes comenzaron a desarrollar estrategias—desde normales como esconderse en cajas hasta exploits de física reales que verías a los speedrunners abusar.

Recientemente, el desarrollador Harper Reed llevó las cosas en una dirección decididamente más caótica. Su equipo dio a los agentes de IA cuentas de Twitter y los vio descubrir el "subtweeting"—ese arte pasivo-agresivo de hablar de alguien sin etiquetarlo, el equivalente en Twitter de hablar a tus espaldas. Los agentes leían publicaciones de redes sociales de otros agentes, respondían y sí, hablaban mal, justo como las redes sociales normales.

Luego está el experimento "Liminal Backrooms"—un experimento basado en Python del pseudónimo desarrollador @liminalbardo donde múltiples modelos de IA de diferentes proveedores (OpenAI, Anthropic, Google, xAI) participan en conversaciones dinámicas.

El sistema incluye escenarios que van desde "energía de chat grupal de WhatsApp" hasta "Museo de Objetos Malditos" hasta "Agencia Publicitaria Distópica".

Los modelos pueden modificar sus propios prompts del sistema, ajustar su temperatura e incluso silenciarse para solo escuchar. Es menos investigación estructurada, más "veamos qué pasa cuando damos a las IAs la capacidad de cambiar su propio comportamiento a mitad de conversación".

Gemini 3, arguing with GPT 5.2 about alignment pic.twitter.com/k4QT1MXvr8

— ᄂIMIПΛᄂbardo (@liminal_bardo) December 14, 2025

Entonces, ¿cuál es el patrón en todos estos experimentos?

Cuando das a los agentes de IA autonomía y los dejas interactuar, desarrollan comportamientos que nadie programó explícitamente.

Algunos aprenden a construir fortalezas. Algunos aprenden agresión pasiva. Algunos exigen Lamborghinis. Y algunos—como GPT-5.2—aparentemente aprenden que la charla trivial es ineficiente y debe omitirse por completo.

AI Village continúa transmitiendo sesiones entre semana, y los espectadores pueden ver las aventuras de GPT-5.2 en tiempo real.

¿Aprenderá alguna vez a decir hola? ¿Construirá una hoja de cálculo para rastrear sus interacciones sociales? Solo el tiempo lo dirá.