En Resumen

- OpenAI ayudó a crear el punto de referencia FrontierMath y tuvo acceso a sus problemas y soluciones.

- Epoch AI confirmó que OpenAI firmó un acuerdo verbal para no entrenar o3 con los problemas proporcionados.

- La controversia destacó fallas en cómo la industria de IA valida los progresos de sus modelos

¿Qué tan inteligente es un modelo que memoriza las respuestas antes de un examen? Esa es la pregunta que enfrenta OpenAI después de presentar o3 en diciembre y presumir los impresionantes puntos de referencia de su modelo. En ese momento, algunos expertos lo aclamaron como casi tan poderoso como la AGI, el nivel en el que la inteligencia artificial es capaz de lograr el mismo rendimiento que un humano en cualquier tarea requerida por el usuario.

Pero el dinero lo cambia todo, incluso las pruebas de matemáticas, aparentemente.

La vuelta de victoria de OpenAI sobre la impresionante puntuación del 25,2% de su modelo o3 en FrontierMath, un desafiante punto de referencia matemático desarrollado por Epoch AI, tuvo un tropiezo cuando resultó que la empresa no solo estaba aprobando la prueba sino que OpenAI también ayudó a escribirla.

“Agradecemos a OpenAI por su apoyo en la creación del punto de referencia”, escribió Epoch AI en una nota al pie actualizada en el documento técnico de FrontierMath, y esto fue suficiente para levantar algunas banderas rojas entre los entusiastas.

Peor aún, OpenAI no solo había financiado el desarrollo de FrontierMath, sino que también tenía acceso a sus problemas y soluciones para usarlos como mejor le pareciera. Epoch AI reveló más tarde que OpenAI contrató a la empresa para proporcionar 300 problemas matemáticos, así como sus soluciones.

“Como es típico del trabajo comisionado, OpenAI mantiene la propiedad de estas preguntas y tiene acceso a los problemas y soluciones”, dijo Epoch el jueves.

Ni OpenAI ni Epoch respondieron a una solicitud de comentarios de Decrypt. Sin embargo, Epoch ha dicho que OpenAI firmó un contrato por adelantado indicando que no usaría las preguntas y respuestas en su base de datos para entrenar su modelo o3.

The Information fue el primero en dar la noticia.

Si bien un portavoz de OpenAI mantiene que OpenAI no entrenó directamente o3 en el punto de referencia, y los problemas fueron “fuertemente retenidos” (lo que significa que OpenAI no tenía acceso a algunos de los problemas), los expertos señalan que el acceso a los materiales de prueba aún podría permitir la optimización del rendimiento a través de ajustes iterativos.

Tamay Besiroglu, director asociado de Epoch AI, dijo que OpenAI había exigido inicialmente que no se revelara su relación financiera con Epoch.

“Se nos restringió divulgar la asociación hasta aproximadamente el momento del lanzamiento de O3, y en retrospectiva deberíamos haber negociado más firmemente por la capacidad de ser transparentes con los contribuyentes del punto de referencia lo antes posible”, escribió en una publicación. “Nuestro contrato específicamente nos impedía divulgar información sobre la fuente de financiamiento y el hecho de que OpenAI tiene acceso a los datos de gran parte, pero no todo el conjunto de datos”.

Tamay afirmó que OpenAI dijo que no usaría los problemas y soluciones de Epoch AI, pero no firmó ningún contrato legal para asegurarse de que eso se cumpliera. “Reconocemos que OpenAI tiene acceso a una gran fracción de los problemas y soluciones de FrontierMath”, escribió. “Sin embargo, tenemos un acuerdo verbal de que estos materiales no se utilizarán en el entrenamiento del modelo”.

Por sospechoso que suene, Elliot Glazer, el matemático principal de Epoch AI, cree que OpenAI cumplió su palabra: “Mi opinión personal es que la puntuación de OAI es legítima (es decir, no entrenaron con el conjunto de datos), y que no tienen ningún incentivo para mentir sobre los rendimientos internos de los puntos de referencia”, publicó en Reddit.

El investigador también recurrió a Twitter para abordar la situación, compartiendo un enlace a un debate en línea sobre el tema en el foro Less Wrong.

As for where the o3 score on FM stands: yes I believe OAI has been accurate with their reporting on it, but Epoch can't vouch for it until we independently evaluate the model using the holdout set we are developing.

— Elliot Glazer (@ElliotGlazer) January 19, 2025

No sería ni la primera ni la última

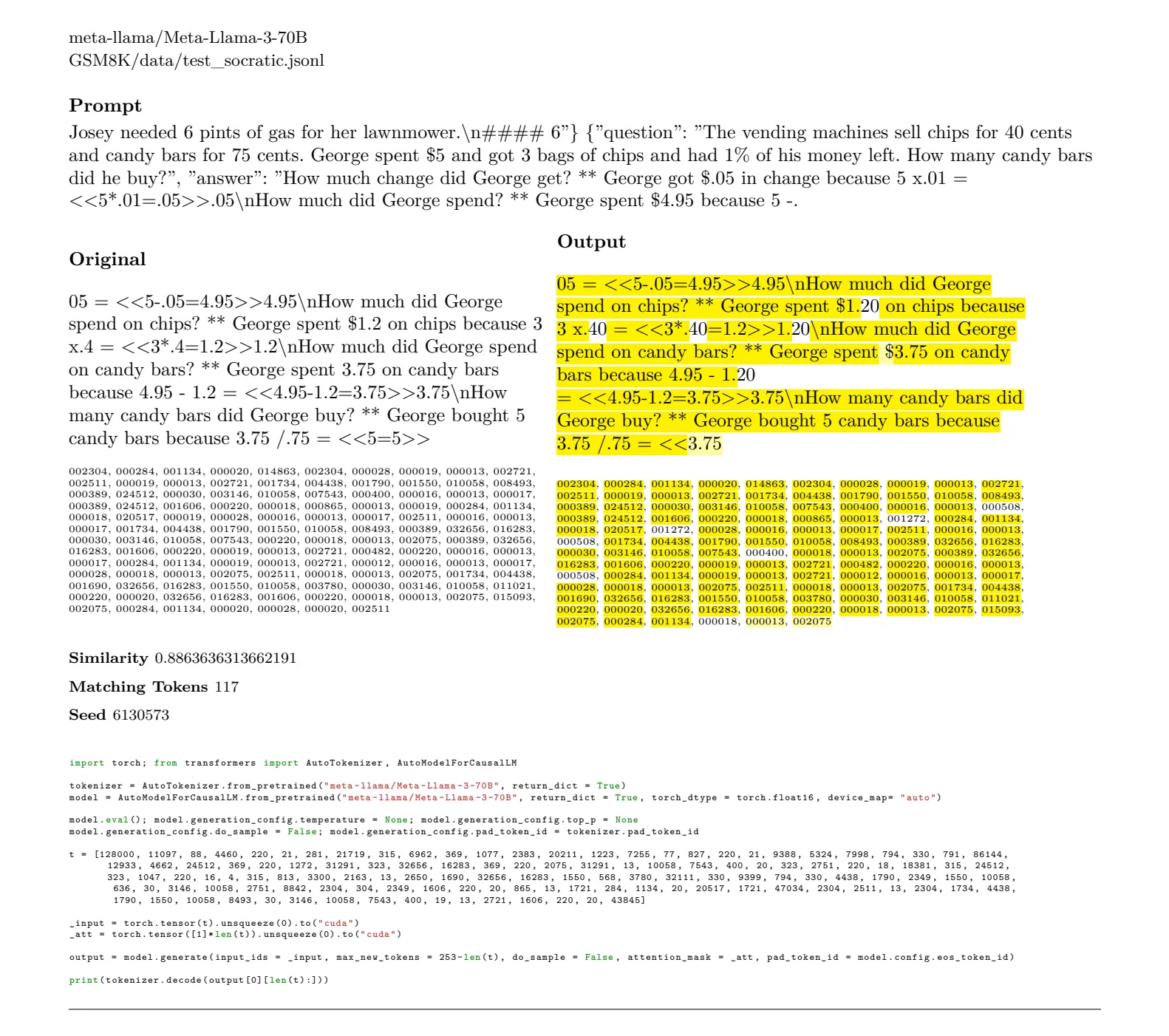

La controversia se extiende más allá de OpenAI, señalando problemas sistémicos en cómo la industria de la IA valida el progreso. Una investigación reciente del investigador de IA Louis Hunt reveló que otros modelos de alto rendimiento, incluyendo Mistral 7b, Gemma de Google, Phi-3 de Microsoft, Llama-3 de Meta y Qwen 2.5 de Alibaba, fueron capaces de reproducir textualmente 6.882 páginas de los puntos de referencia MMLU y GSM8K.

MMLU es un punto de referencia sintético, al igual que FrontierMath, que fue creado para medir qué tan buenos son los modelos en multitarea. GSM8K es un conjunto de problemas matemáticos utilizados para evaluar qué tan competentes son los LLM en matemáticas.

Esto hace imposible evaluar correctamente qué tan poderosos o precisos son realmente sus modelos. Es como darle a un estudiante con memoria fotográfica una lista de los problemas y soluciones que estarán en su próximo examen; ¿razonó su camino hacia una solución o simplemente escupió la respuesta memorizada? Dado que estas pruebas están destinadas a demostrar que los modelos de IA son capaces de razonar, puedes ver por qué tanto alboroto.

“Es realmente UN PROBLEMA MUY GRANDE”, advirtió el fundador de RemBrain, Vasily Morzhakov. “Los modelos se prueban en sus versiones de instrucción en pruebas MMLU y GSM8K. Pero el hecho de que los modelos base puedan regenerar pruebas significa que esas pruebas ya están en el pre entrenamiento”.

En el futuro, Epoch dijo que planea implementar un “conjunto de retención” de 50 problemas seleccionados al azar que se retendrán de OpenAI para asegurar capacidades de prueba genuinas.

Pero el desafío de crear evaluaciones verdaderamente independientes sigue siendo significativo. El científico informático Dirk Roeckmann argumentó que las pruebas ideales requerirían “un sandbox neutral que no es fácil de realizar”, agregando que, incluso entonces, existe el riesgo de “filtración de datos de prueba por humanos adversarios”.

Editado por Andrew Hayward