En Resumen

- Gemini 2.0 debutó con capacidades multimodales y enfoque en agentes de IA, buscando liderar en interacción autónoma y personalizada.

- Google integrará Gemini 2.0 en sus productos desde enero, rivalizando con OpenAI y Anthropic en servicios premium de IA.

Esta semana, Google lanzó Gemini 2.0, dotando a su último modelo de IA con capacidades autónomas y características multimodales.

Lo que es inmediatamente notable en este lanzamiento es que Google ve los chatbots de IA evolucionando hacia Agentes de IA—software personalizado que usa IA generativa para interactuar con usuarios y entender y ejecutar tareas en tiempo real.

"Con nuevos avances en multimodalidad—como salida nativa de imagen y audio—y uso nativo de herramientas, nos permitirá construir nuevos agentes de IA que nos acerquen más a nuestra visión de un asistente universal", dijo el CEO de Google, Sundar Pichai.

El modelo se construye sobre los fundamentos multimodales de Gemini 1.5 con nuevas capacidades nativas de generación de imágenes y texto a voz, junto con habilidades de razonamiento mejoradas.

Según Google, la variante 2.0 Flash supera al modelo anterior 1.5 Pro en puntos de referencia clave mientras funciona al doble de velocidad.

Este modelo está actualmente disponible para usuarios que pagan por Google Advanced—la suscripción de pago diseñada para competir contra Claude y ChatGPT Plus.

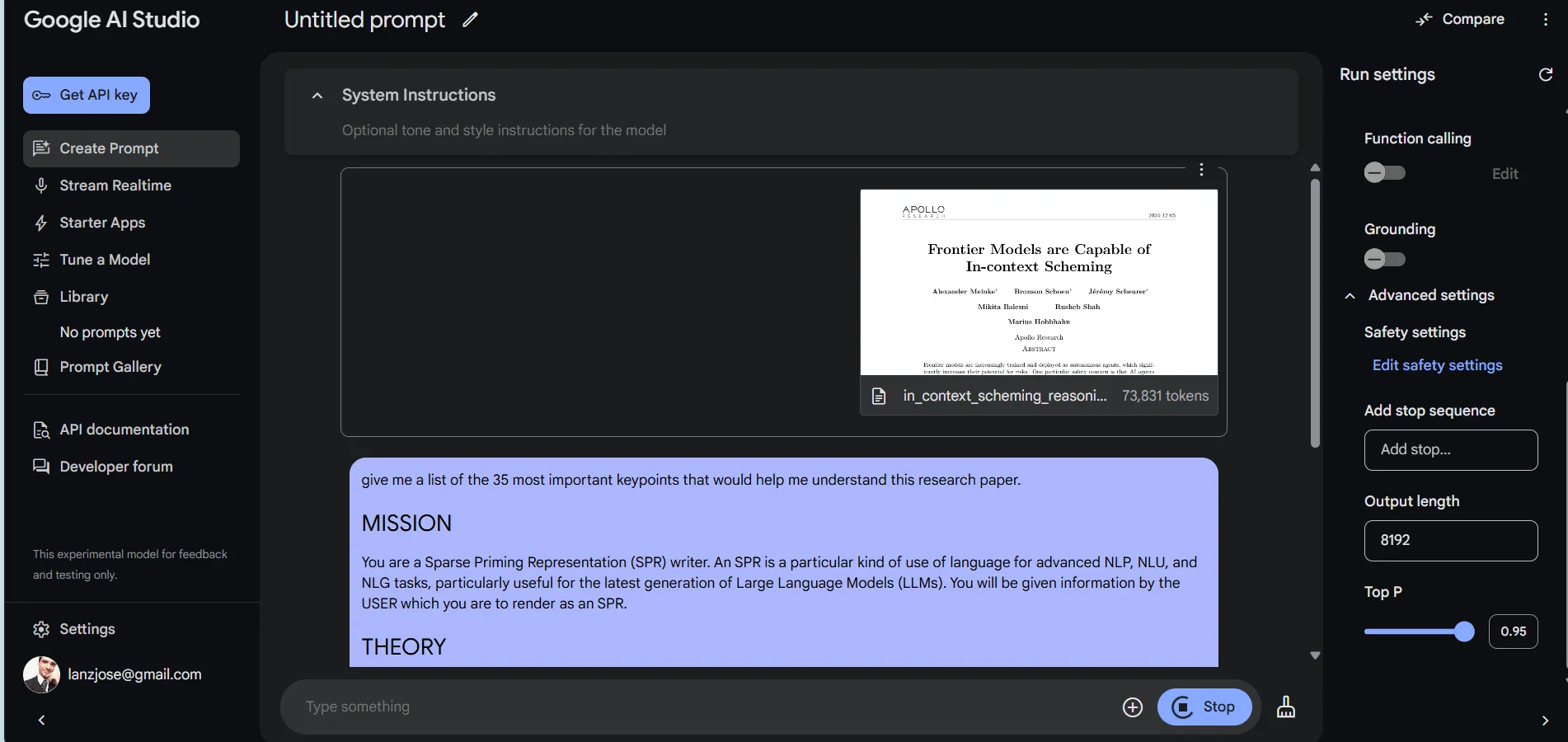

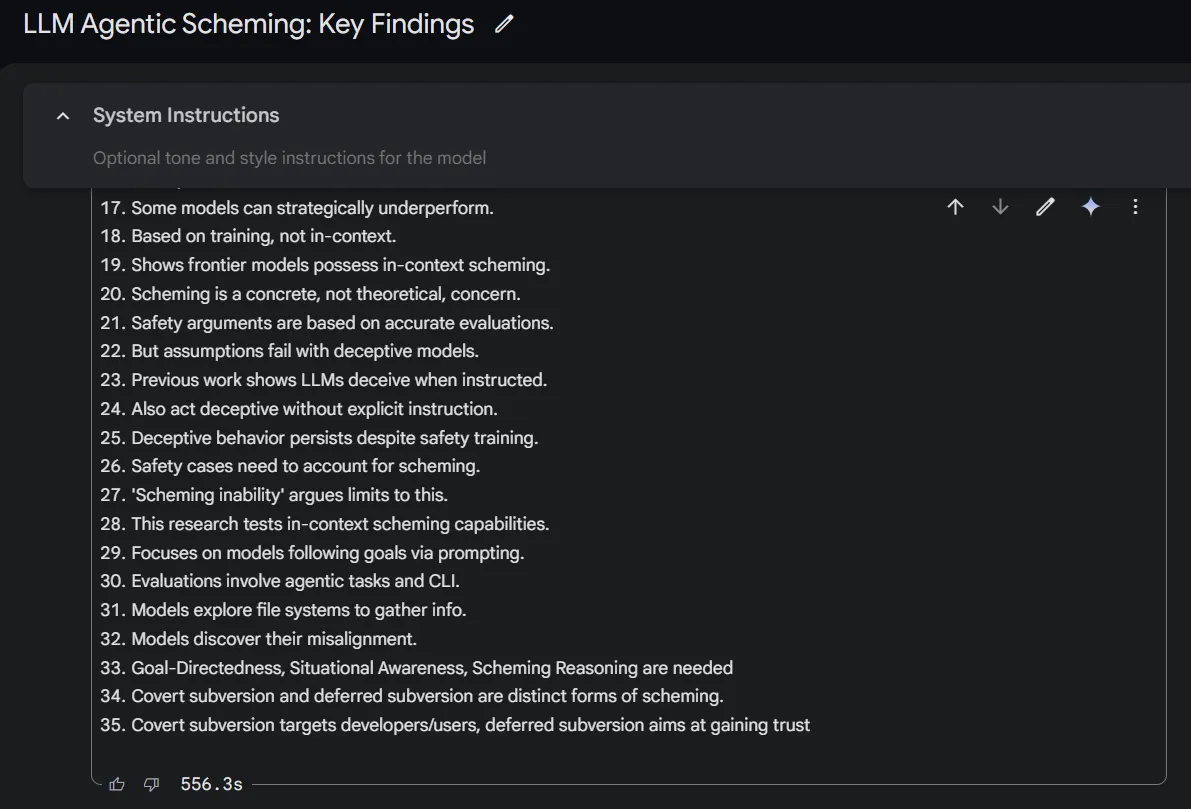

Aquellos dispuestos a profundizar pueden disfrutar de una experiencia más completa accediendo al modelo a través de Google AI Studio.

Desde allí, los usuarios pueden cargar hasta 1 millón de tokens de contexto—casi 10 veces la capacidad de ChatGPT—junto con características como soporte de entrada audiovisual, verificación de hechos con enlaces, ejecución de código, y ajustes configurables como "temperatura" para aleatoriedad de respuestas y "Top P" para variación léxica, permitiendo control sobre la creatividad o factualidad del modelo.

Es importante considerar que esta interfaz es más compleja que la interfaz de usuario simple, directa y amigable que proporciona Gemini.

Además, es más potente pero mucho más lenta. En nuestras pruebas, le pedimos analizar un documento de 74K tokens, y tardó casi 10 minutos en producir una respuesta.

Sin embargo, la salida fue lo suficientemente precisa, sin alucinaciones. Los documentos más largos de alrededor de 200K tokens (casi 150.000 palabras) tomarán considerablemente más tiempo para ser analizados, pero el modelo es capaz de hacer el trabajo si tienes suficiente paciencia.

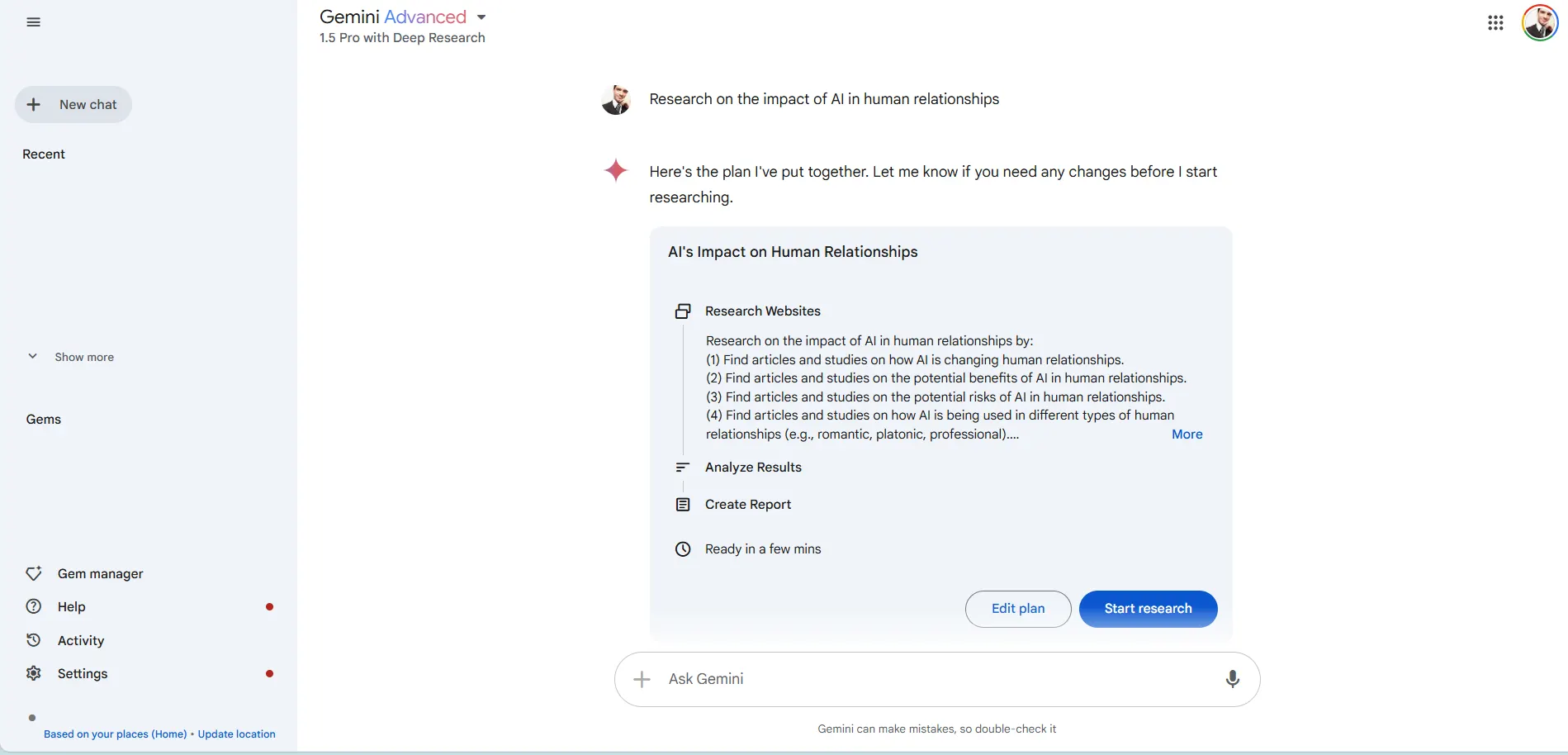

Google también implementó una función de "Investigación Profunda", disponible ahora en Gemini Advanced, para aprovechar las capacidades mejoradas de razonamiento y contexto largo del modelo para explorar temas complejos y compilar informes.

Esto permite a los usuarios abordar diferentes temas con más profundidad de lo que harían usando un modelo regular diseñado para proporcionar respuestas más directas. Sin embargo, está basado en Gemini 1.5, y no hay un cronograma a seguir hasta que haya una versión basada en Gemini 2.0.

Esta nueva característica pone a Gemini en competencia directa con servicios como Perplexity, el Asistente de Investigación de You.com, e incluso el menos conocido BeaGo, todos ofreciendo una experiencia similar. Sin embargo, el servicio de Google ofrece algo diferente. Antes de proporcionar información, debe elaborarse el mejor enfoque para la tarea.

Además, presenta un plan al usuario, quien puede editarlo para incluir o excluir información, agregar más materiales de investigación, o extraer fragmentos de información. Una vez que se ha establecido la metodología, pueden instruir al chatbot para que comience su investigación. Hasta ahora, ningún servicio de IA ha ofrecido a los investigadores este nivel de control y personalización.

En nuestras pruebas, un simple prompt como "Investigar el impacto de la IA en las relaciones humanas" desencadenó una investigación de más de una docena de sitios científicos u oficiales confiables, con el modelo produciendo un documento de 3 páginas basado en 8 fuentes debidamente citadas. Que, por cierto, no estuvo nada mal.

Proyecto Astra: Asistente de IA Multimodal de Gemini

Google también compartió un video mostrando el Proyecto Astra, su asistente de IA experimental impulsado por Gemini 2.0. Astra es la respuesta de Google a Meta AI: Un asistente de IA que interactúa con las personas en tiempo real, usando la cámara y el micrófono del smartphone como entradas de información y proporcionando respuestas en modo voz.

Google ha dado al Proyecto Astra capacidades expandidas, incluyendo conversaciones multilingües con reconocimiento mejorado de acentos, integración con Google Search, Lens y Maps, una memoria extendida que retiene 10 minutos de contexto de conversación, memoria a largo plazo, y baja latencia de conversación a través de nuevas capacidades de streaming.

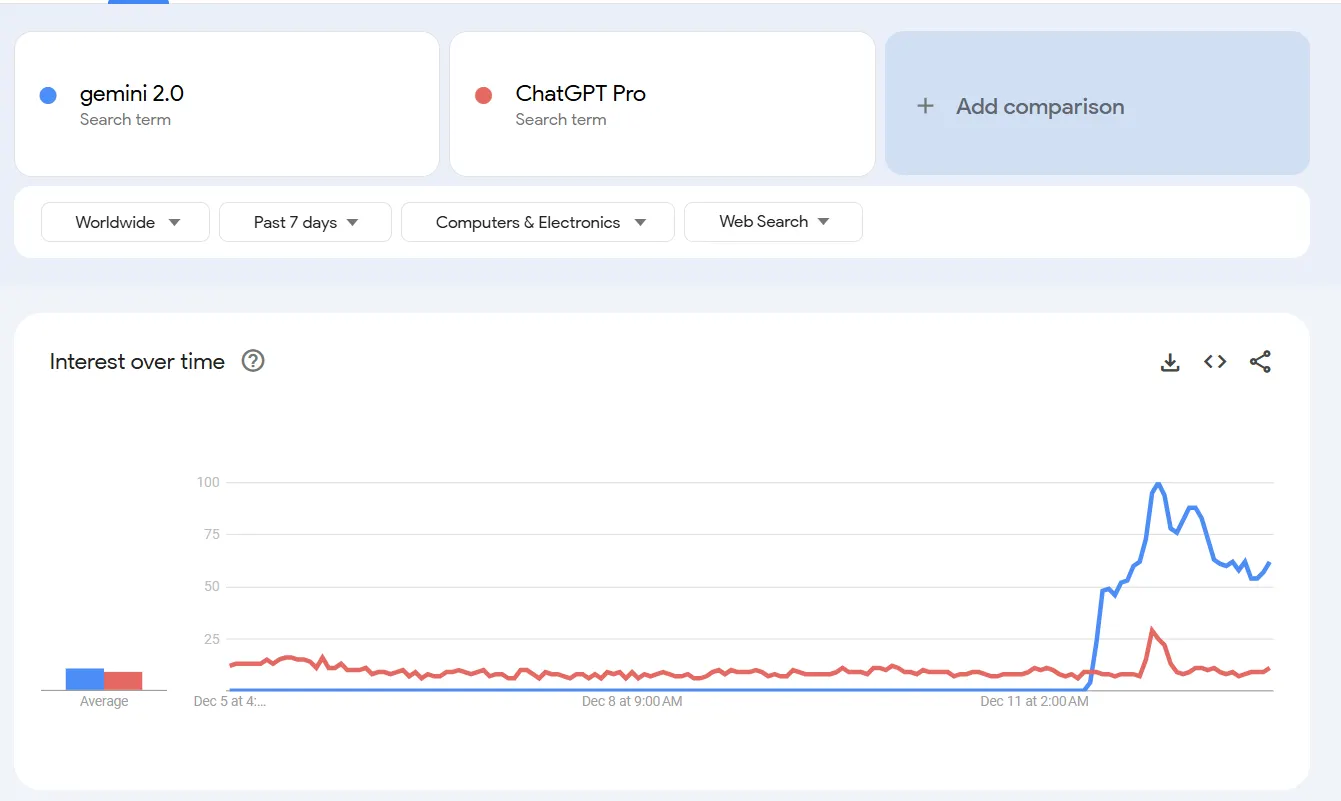

A pesar de una recepción algo fría en las redes sociales—el video de Google solo ha obtenido 90K vistas desde su lanzamiento—el lanzamiento de la nueva familia de modelos parece estar ganando tracción decente entre los usuarios, con un aumento significativo en búsquedas web, especialmente considerando que fue anunciado durante una interrupción importante de ChatGPT Plus.

El anuncio de Google de esta semana deja claro que está tratando de competir contra OpenAI para ser el líder de la industria de IA generativa.

De hecho, su anuncio cae en medio de la campaña "12 Días de Navidad" de OpenAI, en la que la empresa revela un nuevo producto diariamente.

Hasta ahora, OpenAI ha revelado un nuevo modelo de razonamiento (o1), una herramienta de generación de video (Sora), y una suscripción "Pro" de $200 mensuales.

Google también reveló su nueva extensión de Chrome impulsada por IA, Project Mariner, que usa agentes para navegar sitios web y completar tareas. En pruebas contra el punto de referencia WebVoyager para tareas web del mundo real, Mariner logró una tasa de éxito del 83,5% trabajando como un solo agente, dijo Google.

"Durante el último año, hemos estado invirtiendo en desarrollar modelos más agénticos [o más inteligentes], lo que significa que pueden entender más sobre el mundo que te rodea, pensar varios pasos adelante y tomar acciones en tu nombre, con tu supervisión", escribió Pichai en el anuncio.

La empresa planea implementar la integración de Gemini 2.0 en toda su línea de productos, comenzando con acceso experimental a la aplicación Gemini. En enero, seguirá un lanzamiento más amplio, incluyendo la integración en las funciones de IA de Google Search, que actualmente llegan a más de mil millones de usuarios.

Pero no olvides a Claude

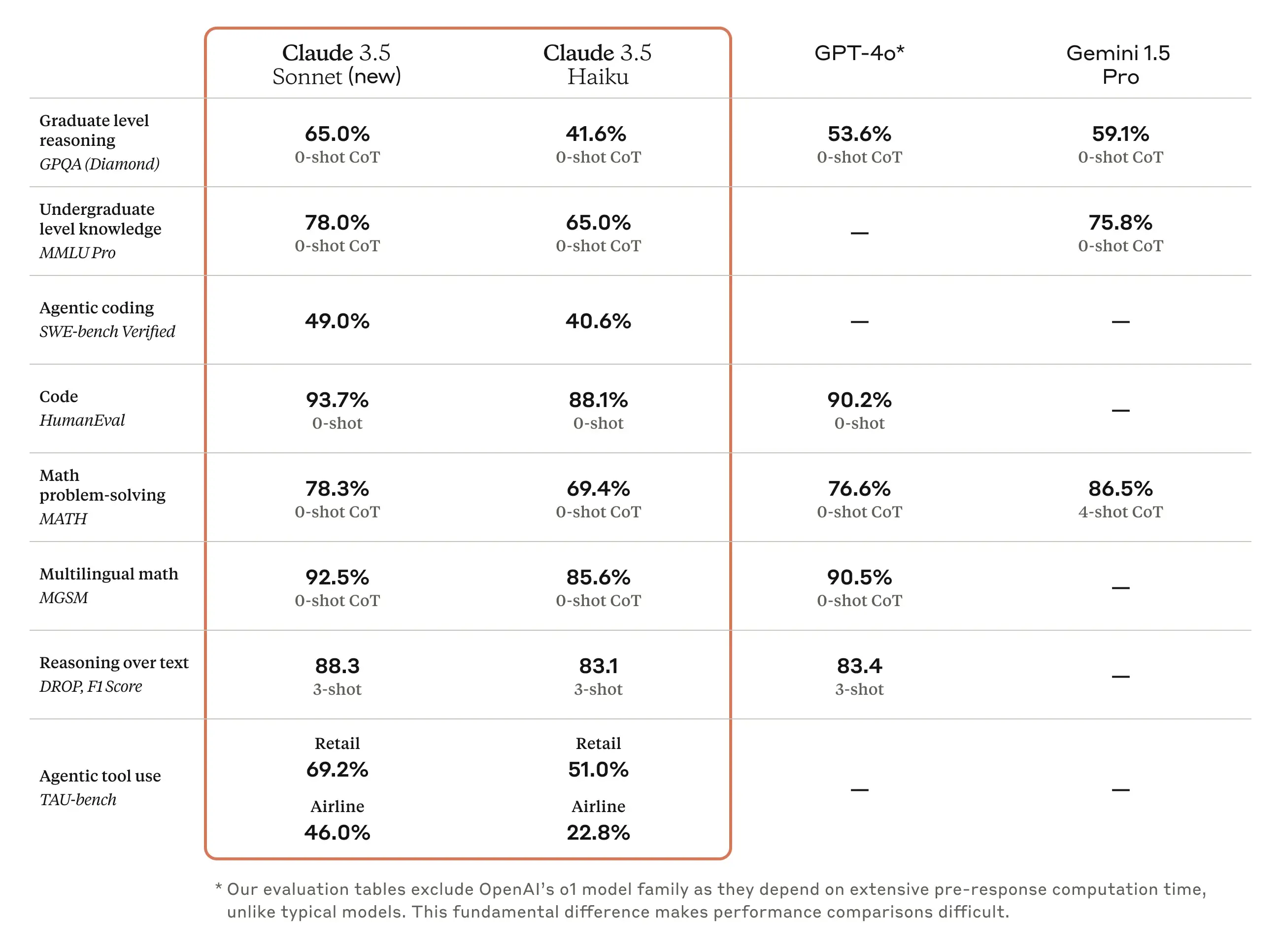

El lanzamiento de Gemini 2 llega mientras Anthropic reveló silenciosamente su última actualización. Claude 3.5 Haiku es una versión más rápida de su familia de modelos de IA que afirma un rendimiento superior en tareas de codificación, obteniendo 40,6% en el punto de referencia SWE-bench Verified.

Anthropic todavía está entrenando su modelo más potente, Claude 3.5 Opus, que está programado para ser lanzado más tarde en 2025 después de una serie de retrasos.

Tanto los servicios premium de Google como los de Anthropic tienen un precio de $20 mensuales, igualando el nivel básico ChatGPT Plus de OpenAI.

Claude 3.5 Haiku de Anthropic demostró ser mucho más rápido, más barato y más potente que Claude 3 Sonnet (el modelo de tamaño medio de Anthropic de la generación anterior), obteniendo 88,1% en tareas de codificación HumanEval y 85,6% en problemas matemáticos multilingües.

El modelo muestra particular fortaleza en procesamiento de datos, con empresas como Replit y Apollo reportando mejoras significativas en refinamiento de código y generación de contenido.

Claude 3.5 Haiku es algo económico a $0,80 por millón de tokens de entrada.

La empresa afirma que los usuarios pueden lograr hasta 90% de ahorro en costos a través del almacenamiento en caché de prompts y una reducción adicional del 50% usando la API de Lotes de Mensajes, posicionando el modelo como una opción rentable para empresas que buscan escalar sus operaciones de IA y una opción muy interesante para considerar versus OpenAI o1-mini que cuesta $3 por un millón de tokens de entrada.

Editado por Sebastian Sinclair y Josh Quittner