En Resumen

- Nvidia dominó el mercado de IA con ventas trimestrales triplicadas, impulsando el precio de las acciones.

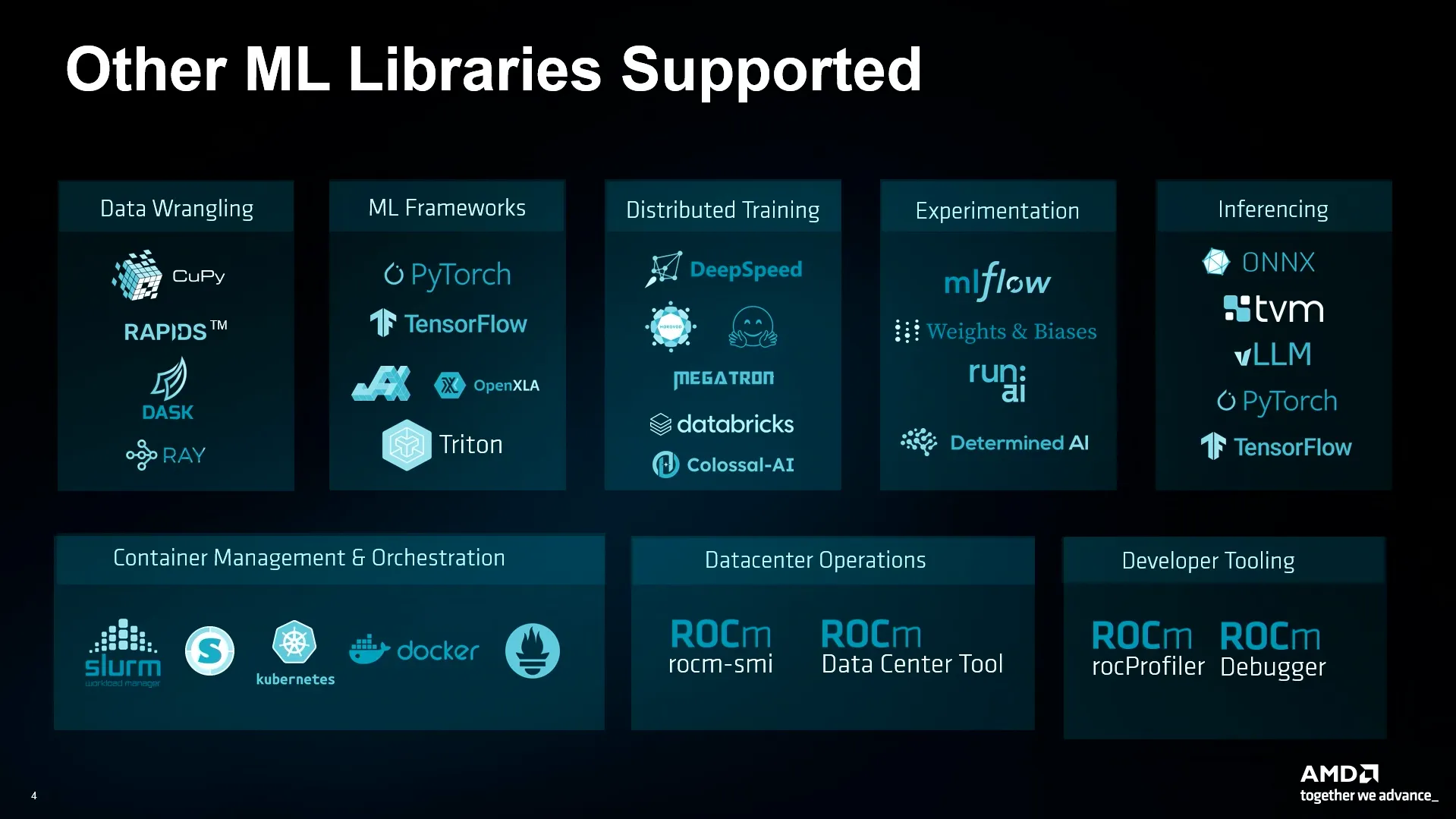

- AMD destacó la compatibilidad de sus soluciones con PyTorch, TensorFlow y JAX.

- AMD desafía a Nvidia con su enfoque de código abierto, asociándose con Hugging Face para brindar soporte IA.

Últimamente, Nvidia parece ser la empresa líder en el mundo de la tecnología y la industria en constante crecimiento de la inteligencia artificial. Entre su entrada al mercado en el momento oportuno, la investigación de hardware de vanguardia, y un ecosistema de software robusto diseñado para sus GPUs, la empresa domina el desarrollo de IA y el mercado de valores. Su último informe de ganancias reveló ayer en la tarde que las ventas trimestrales se triplicaron, impulsando aún más su precio de las acciones.

Sin embargo, su rival de toda la vida, el fabricante de chips AMD, sigue esforzándose por establecer una presencia en la IA, diciéndoles a los constructores detrás de las tecnologías clave en el espacio incipiente que también pueden hacer su trabajo en hardware de AMD.

"Solo quería recordarles a todos que si están usando PyTorch, TensorFlow o JAX, pueden usar sus cuadernos de notas o scripts, ya que funcionarán en AMD" declaró Ian Ferreira, director senior de AMD, en la conferencia Microsoft Build 2024 anteriormente el miércoles. “Lo mismo con los motores de inferencia. BLLM y Onyx también funcionan de forma nativa."

La compañía aprovechó su tiempo en el escenario para mostrar ejemplos de cómo las GPUs de AMD pueden ejecutar de forma nativa modelos de IA potentes como Stable Diffusion y Microsoft Phi, realizando de manera eficiente tareas de entrenamiento computacionalmente intensivas sin depender de la tecnología o hardware de Nvidia.

Con el anuncio de la disponibilidad de máquinas virtuales basadas en AMD en su plataforma de computación en la nube Azure, utilizando las GPU aceleradas MI300X de la compañía, el anfitrión de la conferencia Microsoft reforzó el mensaje. Los chips fueron anunciados en junio pasado, comenzaron a enviarse en el nuevo año y recientemente se implementaron en el servicio de OpenAI de Microsoft Azure e infraestructura de Hugging Face.

La tecnología CUDA propietaria de Nvidia, que incluye un modelo de programación completo y una API diseñada específicamente para las GPUs de Nvidia, se ha convertido en el estándar de la industria para el desarrollo de IA. El mensaje principal de AMD, por lo tanto, fue que sus soluciones podrían encajar perfectamente en los mismos flujos de trabajo.

La compatibilidad perfecta con los sistemas de IA existentes podría ser un cambio de juego, ya que los desarrolladores ahora pueden aprovechar el hardware menos costoso de AMD sin tener que renovar por completo su base de código.

“Por supuesto, entendemos que necesitas más que solo frameworks, necesitas un montón de cosas previas, necesitas un montón de cosas de experimentación, entrenamiento distribuido—todo eso está habilitado y funciona en AMD,” aseguró Ferreira.

Luego demostró cómo AMD maneja diferentes tareas, desde ejecutar modelos pequeños como ResNet 50 y Phi-3 hasta ajustar y entrenar GPT-2—todo utilizando el mismo código que ejecutan las tarjetas de Nvidia.

Una de las ventajas clave que AMD destacó es la capacidad de manejar eficientemente modelos de lenguaje grandes.

"Se pueden cargar hasta 70 mil millones de parámetros en una sola GPU, con ocho de ellas en esta instancia", explicó. "Se pueden cargar ocho llama 70B diferentes, o tomar un modelo de lenguaje grande o Large Language Model (LLM) como Llama-3 400Bn y desplegarlo en una sola instancia".

Desafiar la dominancia de Nvidia no es tarea fácil, ya que la empresa con sede en Santa Clara, California, ha protegido ferozmente su territorio. Nvidia ya ha tomado acción legal contra proyectos que intentan proporcionar capas de compatibilidad con CUDA para GPUs de terceros como AMD, argumentando que viola los términos de servicio de CUDA. Esto ha limitado el desarrollo de soluciones de código abierto y ha dificultado que los desarrolladores adopten alternativas.

La estrategia de AMD para evadir el bloqueo de Nvidia es aprovechar su marco ROCm de código abierto, que compite directamente con CUDA. La empresa ha estado avanzando significativamente en este sentido, asociándose con Hugging Face, el repositorio de modelos de IA de código abierto más grande del mundo, para brindar soporte para ejecutar código en hardware de AMD.

Esta asociación ya ha dado resultados prometedores, con AMD ofreciendo soporte nativo y herramientas de aceleración adicionales como la ejecución de modelos ONNX en GPUs con tecnología ROCm, Optimum-Benchmark, DeepSpeed para GPUs con tecnología ROCm utilizando Transformers, GPTQ, TGI, y más.

Ferreira también señaló que esta integración es nativa, eliminando la necesidad de soluciones de terceros o intermediarios que podrían hacer que los procesos sean menos eficientes.

"Puedes tomar tus cuadernos existentes, tus scripts existentes, y puedes ejecutarlos en AMD, y eso es importante, porque muchos de los otros aceleradores requieren transcodificación y todo tipo de scripts de precompilación", dijo. "Nuestras cosas simplemente funcionan directamente, y es realmente, realmente rápido".

Aunque la jugada de AMD es ciertamente audaz, desbancar a Nvidia será un reto significativo. Nvidia no se está quedando atrás, innovando constantemente y haciendo que sea difícil para los desarrolladores migrar a una nueva infraestructura desde el estándar de facto CUDA.

Sin embargo, con su enfoque de código abierto, alianzas estratégicas y un enfoque en la compatibilidad nativa, AMD se está posicionando como una alternativa viable para los desarrolladores que buscan más opciones en el mercado de hardware de IA.

Editado por Ryan Ozawa.