Microsoft Research ha anunciado el lanzamiento de Phi-2, un modelo de lenguaje pequeño o small language model (SLM) que demuestra capacidades notables para su tamaño. El modelo fue revelado por primera vez durante el evento Ignite 2023 de Microsoft, en el que Satya Nadella, CEO de Microsoft, destacó su capacidad para lograr un rendimiento de vanguardia con una fracción de los datos de entrenamiento.

A diferencia de GPT, Gemini y otros modelos de lenguaje grandes o Large Language Models (LLM), un SLM se entrena con un conjunto de datos limitado, utilizando menos parámetros y requiriendo menos cálculos para funcionar. Como resultado, el modelo no puede generalizar tanto como un LLM, pero puede ser muy bueno y eficiente en tareas específicas, como matemáticas y cálculos en el caso de Phi.

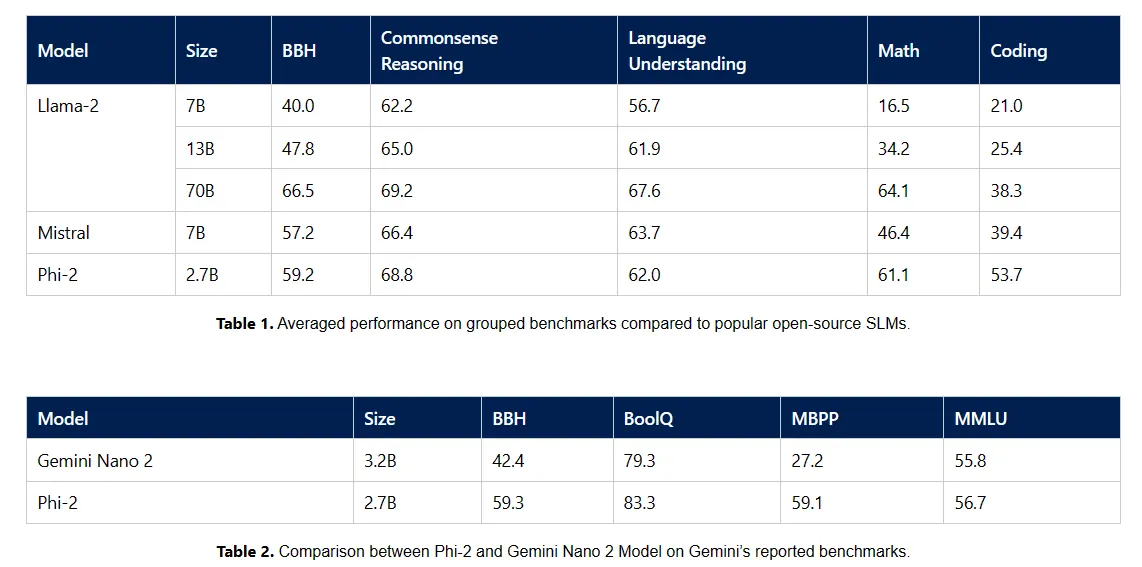

Phi-2, con sus 2.700 millones de parámetros, muestra un buen razonamiento y comprensión del lenguaje, rivalizando con modelos hasta 25 veces su tamaño, según Microsoft. Esto se debe al enfoque de Microsoft Research en datos de entrenamiento de alta calidad y técnicas avanzadas de escalado, lo que produce un modelo que supera a sus predecesores en varios puntos de referencia, incluyendo matemáticas, programación y razonamiento de sentido común.

"Con solo 2.7 mil millones de parámetros, Phi-2 supera el rendimiento de los modelos Mistral y Llama-2 con 7B y 13B de parámetros en varios puntos de referencia agregados", dijo Microsoft, lanzando un golpe bajo al nuevo modelo de IA de Google: "Además, Phi-2 iguala o supera al recientemente anunciado Google Gemini Nano 2, a pesar de ser más pequeño en tamaño".

Gemini Nano 2 es la última apuesta de Google en un multimodal LLM capaz de funcionar localmente. Fue anunciado como parte de la familia Gemini de LLMs que se espera que reemplacen a PaLM-2 en la mayoría de los servicios de Google.

El enfoque de Microsoft hacia la IA va más allá del desarrollo de modelos. Como informó Decrypt recientemente, la introducción de chips personalizados, Maia y Cobalt, muestra que la empresa se está moviendo hacia la integración total de la IA y la computación en la nube. Los chips de computadora, optimizados para tareas de IA, respaldan la visión más amplia de Microsoft de armonizar las capacidades de hardware y software y compiten directamente contra Google Tensor y la nueva serie de chips M de Apple.

Es importante destacar que Phi-2 es un modelo de lenguaje tan pequeño que se puede ejecutar localmente en equipos de baja gama, incluso potencialmente en teléfonos inteligentes, lo que abre el camino a nuevas aplicaciones y casos de uso.

A medida que Phi-2 entra en el ámbito de la investigación y desarrollo de IA, su disponibilidad en el catálogo de modelos de Azure AI Studio también es un paso hacia la democratización de la investigación en IA. Además, Microsoft es una de las empresas más activas que contribuyen al desarrollo de IA de código abierto.

A medida que el panorama de la IA continúa evolucionando, Phi-2 de Microsoft es evidencia de que el mundo de la IA no siempre se trata de pensar en grande. A veces, el mayor poder radica en ser más pequeño pero más inteligente que la competencia.

Editado por Ryan Ozawa.