En Resumen

- Google sorprendió al presentar Gemini, su conjunto de herramientas de inteligencia artificial multimodal para consumidores y empresas, con tres versiones: Nano, Pro y Ultra.

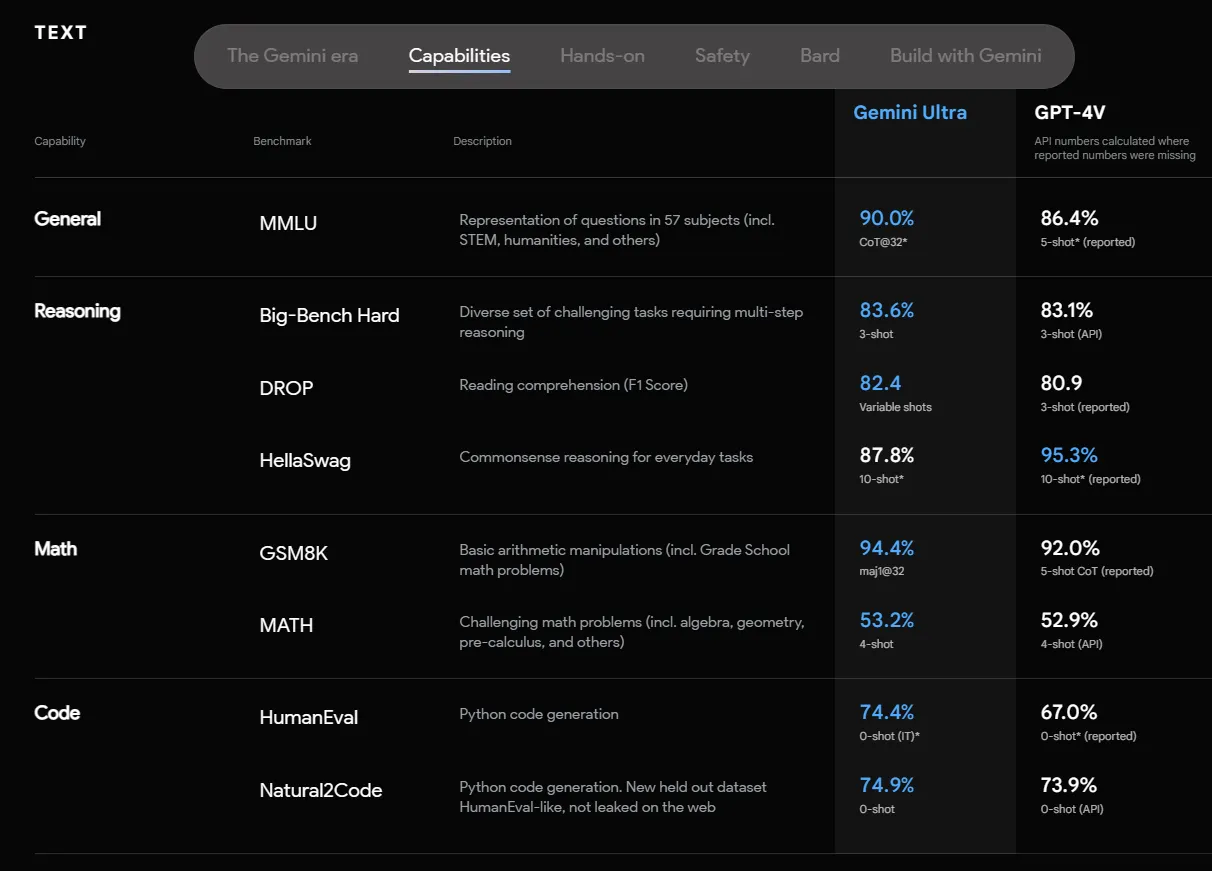

- Gemini Ultra obtuvo resultados sólidos en benchmarks, igualando o superando el rendimiento humano en algunos casos.

- Su entrenamiento "nativamente multimodal" le permite procesar texto, imágenes, audio y video como entradas y salidas.

- La capacidad de razonamiento multimodal de Gemini destaca en evaluaciones cualitativas, mostrando eficiencia en tareas educativas y superando a modelos existentes en pruebas de preferencia humana.

Este miércoles Google sorprendió al mundo tecnológico con el debut de Gemini, su conjunto de herramientas de inteligencia artificial multimodal para consumidores y empresas.

Entre los gigantes tecnológicos que se adentran agresivamente en la IA, Google, parecía estar nadando en el espacio intermedio, mientras que OpenAI, respaldado por Microsoft, impulsaba a ChatGPT a Turbo y Vision y, Anthropic mejoraba a Claude.

Sin embargo, hoy, Google se disparó en la competencia con tres versiones de Gemini: Nano, Pro y Ultra, que comprenden e integran sin problemas texto, imágenes, audio y video.

Gemini parece estar listo para superar a los modelos de IA de última generación de OpenAI, que acaba de lanzar una lista interminable de nuevas capacidades, pero poco después se vio envuelta en intrigas corporativas.

La versión más avanzada, Gemini Ultra, obtuvo resultados sólidos en varios benchmarks populares, igualando o superando el rendimiento humano en algunos casos. Por ejemplo, estableció nuevos récords en 30 de los 32 benchmarks en el examen MMLU, que abarca una variedad de materias académicas.

Una característica clave de Gemini es su entrenamiento "nativamente multimodal", que le permite procesar múltiples tipos de datos como texto, imágenes y audio como entradas y salidas. Este enfoque significa que el modelo fue construido y entrenado desde cero para comprender diferentes entradas, en lugar de ser el resultado de combinar modos y módulos discretos más tarde.

Las IAs multimodales más populares en la actualidad siguen la última hoja de ruta. Por ejemplo, ChatGPT combina GPT-4 Turbo con Dall-E 3 para procesar texto y generar imágenes, GPT-4 Vision para procesar imágenes y un módulo de codificación especial para cálculos. Como resultado, el LLM se relega al papel de coordinador entre diferentes modelos de IA que no pueden comprender de forma independiente la naturaleza completa de un problema específico.

Esta limitación también puede llevar a vulnerabilidades como la inyección de comandos. Por ejemplo, técnicas para evadir los controles de seguridad establecidos para los mensajes de texto, escribiéndolos o imprimiéndolos en un papel, tomando una foto y pidiendo al módulo visual que lo procese.

En contraste, las primeras evaluaciones cualitativas de Gemini revelan su notable capacidad para realizar razonamiento multimodal. Por ejemplo, en entornos educativos, Gemini puede comprender problemas complejos de física, convertirlos en fórmulas matemáticas y proporcionar soluciones correctas. Esta capacidad abre caminos transformadores en la educación y en otros campos.

Los LLM tradicionales generalmente no son muy buenos en matemáticas, por lo que las capacidades de razonamiento de la familia Gemini de LLM multimodales merecen atención.

En otra prueba de referencia centrada en la comprensión del lenguaje multimodal, Gemini Ultra logró una precisión superior al 90%, superando a otros modelos existentes. Google afirma que las pruebas de preferencia humana también mostraron una clara preferencia por Gemini sobre modelos como PaLM 2 en áreas como la escritura creativa.

El servicio más pequeño, Gemini Nano, está diseñado para una eficiencia en el dispositivo, destacando en la resumenización, comprensión de lectura y diversas tareas de razonamiento. A pesar de su tamaño más pequeño, Gemini Nano muestra un rendimiento notable en comparación con el modelo Gemini Pro más grande. Esto significa que Gemini podría convertirse en la IA preferida para alimentar asistentes móviles que pueden o deben funcionar sin conexión.

Gemini parece tener un debut muy sólido. Y a medida que se mejoren las capacidades de IA de Google, su versatilidad podría permitir nuevas aplicaciones en muchos ámbitos. Sin embargo, por ahora, se requieren pruebas adicionales en el mundo real para determinar sus niveles de rendimiento realistas.

Hoy, los usuarios pueden probar una versión afinada de Gemini Pro con Bard. Gemini Ultra se lanzará el próximo año en una nueva versión del chatbot de Google llamado Bard Advanced. Google espera lanzar Gemini en más de 170 idiomas diferentes y utilizar la tecnología para impulsar su línea de productos Pixel y la Experiencia Generativa de Búsqueda.