En Resumen

- Reavivan los rumores en Japón sobre Putin usando dobles y tecnología IA en sus apariciones públicas para parecer más real.

- Los deepfakes de IA plantean desafíos en la autenticidad de imágenes y videos.

- Estrategias como el marcado de agua y la lucha contra deepfakes continúan siendo un desafío en evolución.

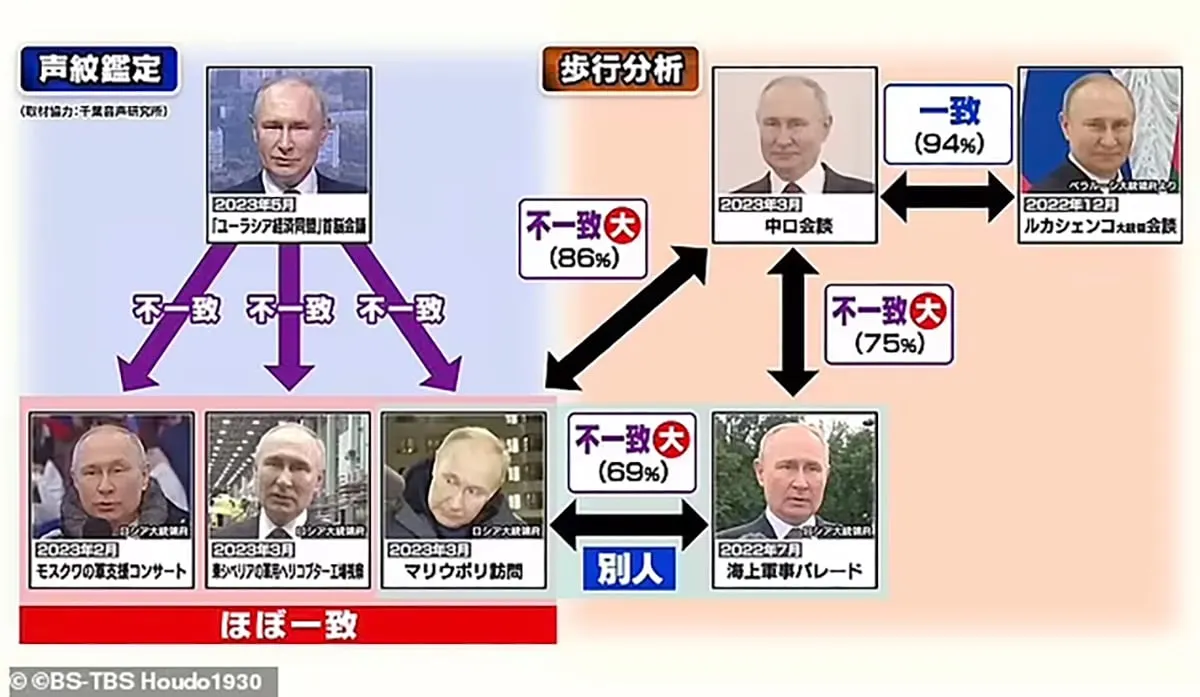

Un segmento de un medio de comunicación en Japón revivió los rumores de que Vladimir Putin utiliza dobles para sus apariciones públicas, y supuestamente se utiliza IA generativa para hacer que las fotos de esos dobles se parezcan más al verdadero presidente ruso.

La afirmación persistente y no fundamentada ha circulado durante meses y ha resurgido en Japón, según un reporte del Daily Mail. Según se informa, investigadores japoneses analizaron imágenes de video y fotos de Putin en diferentes eventos y sugirieron que hay al menos tres personas que lo interpretan. Aunque tales afirmaciones fueron rápidamente rechazadas por el Kremlin, la historia ilustra un efecto secundario de los rápidos avances en IA: los avances en deepfakes de IA.

Un deepfake de IA es una tecnología que utiliza algoritmos para intercambiar caras en videos, imágenes y otros contenidos digitales para hacer que lo falso parezca real. Los deepfakes han sido reconocidos como una nueva herramienta peligrosa para la manipulación política. Y detectar deepfakes se ha convertido en una industria en rápido crecimiento, con OpenAI, líder en IA generativa, afirmando poder identificar un deepfake con un 99% de precisión.

Pero los investigadores dicen que hacerlo no es fácil y seguirá siendo más difícil.

"Hay formas intentadas en tecnología probabilística para determinar si algo es IA", dijo Riley McCormack, presidente y CEO de Decrypt. "Creo que has visto que si observas muchos de estos métodos, los mejores tienen una precisión bastante baja".

Lanzado en 1994, Digimarc proporciona marcas de agua digitales que ayudan a identificar y proteger activos digitales y derechos de autor. Las marcas de agua son una de las formas más comúnmente sugeridas para identificar deepfakes, y empresas como Google están explorando este enfoque.

Durante el evento Google Cloud Next en San Francisco, el CEO de Alphabet y Google, Sundar Pichai, presentó una función de marca de agua en la plataforma de IA Google Vertix.

"Utilizando tecnología impulsada por Google Deepmind, las imágenes generadas por Vertex AI pueden ser marcadas de agua de una manera invisible para el ojo humano sin dañar la calidad de la imagen", dijo Pichai.

Sin embargo, como estrategia, el marcado de agua tiene una serie de debilidades. McCormack dijo que detener los deepfakes de IA con marcado de agua requiere que todos adopten el mismo método para indicar si algo es generado por IA o auténtico, algo que él ha argumentado anteriormente.

"El problema de hacer solo IA generativa con marcado de agua es que no todos los motores de IA generativa lo van a adoptar", dijo. "El problema con cualquier sistema de autenticidad es que a menos que tengas ubiquidad, simplemente marcarlo de una manera no hace nada".

Porque los generadores de imágenes de IA se basan en imágenes de libre acceso de Internet y redes sociales, otros expertos han abogado por incluir código que degrade la imagen en el generador o utilizar una píldora venenosa mediante la etiquetación incorrecta de los datos, de modo que cuando se alimente al modelo de IA, este no podrá crear la imagen deseada y potencialmente colapse bajo estrés.

Se han creado deepfakes de IA que parodian al presidente de Estados Unidos, Joe Biden, al Papa Francisco y al ex presidente Donald Trump. A medida que la tecnología deepfake mejora día a día, los detectores de IA se ven obligados a jugar al juego del "Whack-a-mole" en una carrera por mantenerse al día.

Añadiendo a los peligros de las deepfakes de IA está el aumento en el material para adultos generado por IA que involucra a menores (CSAM). En un informe publicado en octubre por el grupo de vigilancia de Internet del Reino Unido, la Internet Watch Foundation, la pornografía infantil se está propagando rápidamente en línea utilizando modelos de IA de código abierto que son gratuitos para usar y distribuir.

La IWF sugirió que la pornografía de deepfakes ha avanzado hasta el punto en que se ha vuelto cada vez más difícil distinguir entre imágenes generadas por IA de niños y imágenes reales de niños, lo que lleva a las fuerzas del orden a perseguir fantasmas en línea en lugar de víctimas reales de abuso.

"Entonces está esa cosa continua de que no puedes confiar en si las cosas son reales o no", dijo Dan Sexton, CTO de Internet Watch Foundation, a Decrypt.

Otro problema que planteó McCormack es que muchos de los modelos de IA en el mercado son de código abierto y se pueden utilizar, modificar y compartir sin restricciones.

"Si estás poniendo una técnica de seguridad en un sistema de código abierto", dijo McCormack. "Estás poniendo un candado allí y, justo al lado, estás poniendo el plano de cómo abrir el candado, por lo que realmente no agrega mucho valor".

Sexton dijo que es optimista en una cosa cuando se trata de modelos de generación de imágenes: a medida que los modelos más grandes como Stable Diffusion, Midjourney y Dall-E mejoren y mantengan fuertes barreras de protección, los modelos antiguos que permiten la creación local de CSAM caerán en desuso. También será más fácil identificar qué modelos crearon las imágenes, dijo.

"Llegarás al punto en el que sería más difícil hacer estas cosas, mucho más especializado hacer estas cosas y potencialmente más fácil de identificar y prevenir esos daños", dijo Sexton.

Si bien los líderes gubernamentales son un objetivo principal de los deepfakes de IA, cada vez más celebridades de Hollywood están encontrando sus semblanzas utilizadas en estafas en línea y anuncios que presentan deepfakes de IA.

Buscando detener el uso no autorizado de su imagen, la actriz de Hollywood Scarlett Johansson dijo que está tomando medidas legales contra la empresa de IA, Lisa AI, que utilizó una imagen generada por IA de la estrella de los Vengadores en un anuncio.

El mes pasado, el gigante de YouTube Mr. Beast alertó a sus seguidores sobre una estafa en línea que utilizaba su imagen, e incluso Tom Hanks fue víctima de una campaña de deepfake de IA que utilizó su imagen para promocionar, de todas las cosas, un plan dental.

En septiembre, el Papa Francisco, sujeto de muchos deepfakes de IA, convirtió la tecnología en el centro de un sermón festivo para el Día Mundial de la Paz. El líder religioso llamó a un diálogo abierto sobre la IA y lo que significa para la humanidad.

"Los avances notables realizados en el campo de la inteligencia artificial están teniendo un impacto cada vez mayor en la actividad humana, la vida personal y social, la política y la economía", dijo Francis.

A medida que las herramientas de detección de IA mejoran, McCormack resaltó que los generadores de deepfake de IA también lo harán, lo que llevará a otro frente de la carrera armamentista de IA que comenzó con el lanzamiento de ChatGPT el año pasado.

"La IA generativa no creó el problema de los deepfakes ni el problema de la desinformación", dijo McCormack. "Simplemente lo democratizó".

Editado por Ryan Ozawa.