En Resumen

- La marca de agua puede no ser suficiente para prevenir la difusión de contenido falso generado por IA.

- La investigación realizada por un equipo de científicos de varias universidades reveló vulnerabilidades en los métodos actuales de marca de agua.

- Se sugiere la necesidad de mecanismos de marca de agua más robustos y la posibilidad de combinar criptografía con los esquemas de marca de agua para proteger el contenido generado por IA.

La propagación desenfrenada de deepfakes conlleva riesgos significativos, desde la creación de imágenes explícitas de menores, hasta estafas utilizando deepfakes de celebridades, la capacidad de distinguir el contenido generado por IA (AIGC) de los creados por humanos nunca ha sido tan crucial.

La marca de agua, una medida común contra la falsificación que se ve en documentos y monedas, es un método para identificar dicho contenido, con la adición de información que ayuda a diferenciar una imagen generada por IA de una no generada por IA. Sin embargo, un reciente artículo de investigación concluyó que los métodos de marca de agua simples o incluso avanzados, pueden no ser suficientes para prevenir los riesgos asociados con la difusión de material de IA como si fuera hecho por humanos.

La investigación fue realizada por un equipo de científicos de la Universidad Tecnológica de Nanyang, S-Lab, NTU, la Universidad de Chongqing, Shannon.AI y la Universidad de Zhejiang.

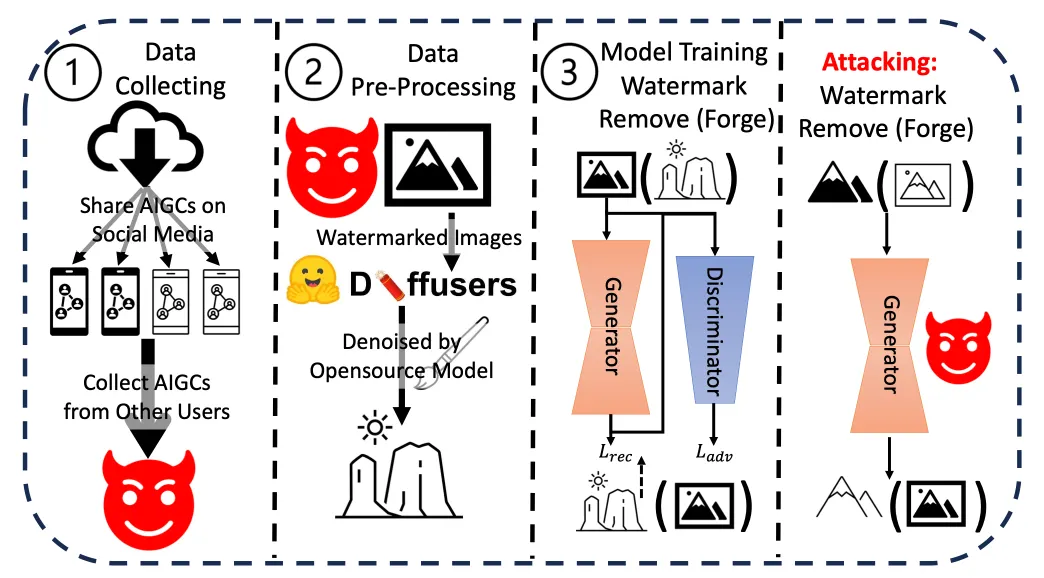

Uno de los autores, Li Guanlin, le dijo a Decrypt que "la marca de agua puede ayudar a las personas a saber si el contenido fue generado por IA o por humanos". Pero agregó: "Si la marca de agua en AIGC es fácil de eliminar o falsificar, podemos hacer que otros crean libremente que una obra de arte fue generada por IA agregando una marca de agua, o que un AIGC fue creado por humanos eliminando la marca de agua".

El artículo exploró varias vulnerabilidades en los métodos actuales de marca de agua.

"Los esquemas de marca de agua para AIGC son vulnerables a ataques adversarios, que pueden eliminar la marca de agua sin conocer la clave secreta", dice. Esta vulnerabilidad tiene implicaciones en el mundo real, especialmente en lo que respecta a la desinformación o el uso malicioso de contenido generado por IA.

"Si algunos usuarios malintencionados difunden imágenes falsas generadas por IA de algunas celebridades después de eliminar las marcas de agua, es imposible demostrar que las imágenes fueron generadas por IA, ya que no tenemos suficientes pruebas", dijo Li a Decrypt.

Li y su equipo realizaron una serie de experimentos para probar la resistencia y la integridad de los métodos actuales de marca de agua en contenido generado por IA. Aplicaron diversas técnicas para eliminar o falsificar las marcas de agua, evaluando la facilidad y efectividad de cada método. Los resultados mostraron consistentemente que las marcas de agua podrían ser comprometidas con relativa facilidad.

Además, evaluaron las posibles implicaciones del mundo real de estas vulnerabilidades, especialmente en escenarios que involucran desinformación o uso malicioso de contenido generado por IA. Los hallazgos acumulativos de estos experimentos y análisis los llevaron a concluir que existe una necesidad urgente de mecanismos de marca de agua más robustos.

Si bien empresas como OpenAI han anunciado el desarrollo de métodos para detectar contenido generado por IA con un 99% de precisión, el desafío general persiste. Los métodos de identificación actuales, como los metadatos y la marca de agua invisible, tienen sus limitaciones.

Li sugiere que "es mejor combinar algunos métodos de criptografía como la firma digital con los esquemas de marca de agua existentes para proteger AIGC", aunque la implementación exacta aún no está clara.

Otros investigadores han propuesto un enfoque más extremo. Como informó recientemente Decrypt, un equipo del MIT ha propuesto convertir las imágenes en "veneno" para los modelos de IA. Si una imagen "envenenada" se utiliza como entrada en un conjunto de datos de entrenamiento, el modelo final produciría resultados incorrectos porque captaría detalles que no son visibles para el ojo humano, pero que son altamente influyentes en el proceso de entrenamiento. Sería como una marca de agua mortal que mata al modelo que entrena.

Como destacó el CEO de OpenAI, Sam Altman, los rápidos avances en IA, sugieren un futuro en el que los procesos de pensamiento inherentes de la IA podrían reflejar la lógica y la intuición humanas. Con tales avances, la necesidad de medidas de seguridad sólidas como la marca de agua se vuelve aún más importante.

Li cree que "el marcado de agua y el análisis de contenido son esenciales porque en realidad no afectarán a los usuarios normales", pero el conflicto entre los creadores y los adversarios persiste, "siempre será un juego del gato y el ratón... Por eso necesitamos seguir actualizando nuestros esquemas de marcado de agua".