En Resumen

- OpenAI anunció planes para lanzar un modelo de lenguaje de pesos abiertos.

- El modelo tendrá capacidades de razonamiento comparables al o3-mini.

- OpenAI busca retroalimentación de desarrolladores antes del lanzamiento.

Las plegarias de los entusiastas de la IA, han sido escuchadas.

OpenAI está volviendo a la arena de la IA de tecnología abierta con planes para lanzar un potente modelo de lenguaje 'Open-Weight' o de pesos abiertos con capacidades de razonamiento en los próximos meses, dijo el CEO Sam Altman el lunes.

"Estamos planeando lanzar nuestro primer modelo de lenguaje 'Open-Weight' desde GPT-2", escribió Altman en una publicación en X. "Hemos estado pensando en esto durante mucho tiempo, pero otras prioridades tomaron precedencia. Ahora se siente importante hacerlo"

TL;DR: we are excited to release a powerful new open-weight language model with reasoning in the coming months, and we want to talk to devs about how to make it maximally useful: https://t.co/XKB4XxjREV

we are excited to make this a very, very good model!

__

we are planning to…

— Sam Altman (@sama) March 31, 2025

El anuncio llega mientras OpenAI enfrenta una creciente competencia de rivales que incluyen a Meta y su familia de modelos de código abierto Llama; Gemma de Google, que viene con capacidades multimodales; y el laboratorio chino de IA DeepSeek, que recientemente lanzó un modelo de razonamiento de código abierto que supuestamente superó al o1 de OpenAI.

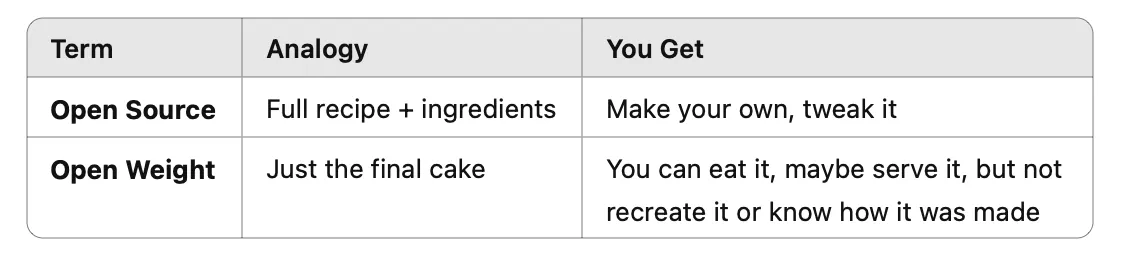

Un modelo es de código abierto cuando su desarrollador comparte con el público todo sobre él: los usuarios tienen acceso al código, conjunto de datos de entrenamiento y arquitectura, entre otras cosas.

Esto da a los usuarios la capacidad de modificar y redistribuir el modelo. Un modelo de pesos abiertos es menos abierto: los usuarios tienen la capacidad de ajustarlo, pero no pueden construirlo desde cero porque no tienen acceso a elementos clave como el conjunto de datos de entrenamiento o la arquitectura.

Para recopilar información sobre lo que los desarrolladores realmente quieren, OpenAI publicó un formulario de retroalimentación en su sitio web y anunció planes para eventos de desarrolladores comenzando en San Francisco en las próximas semanas, seguidos por sesiones en Europa y las regiones de Asia-Pacífico.

"Estamos emocionados de colaborar con desarrolladores, investigadores y la comunidad más amplia para recopilar aportes y hacer este modelo tan útil como sea posible", dijo la compañía en su anuncio.

Steven Heidel, que trabaja en el equipo de API en OpenAI, también compartió que este modelo podría ejecutarse localmente: "Estamos lanzando un modelo este año que podrás ejecutar en tu propio hardware".

No especificó cuántos parámetros tendría, la ventana de contexto de tokens, el conjunto de datos, las técnicas utilizadas en el entrenamiento o la licencia de lanzamiento, que podría restringir acciones como la ingeniería inversa o el ajuste fino en países específicos, por ejemplo.

we're releasing a model this year that you can run on your own hardware https://t.co/0ji9oezNyr

— Steven Heidel (@stevenheidel) March 31, 2025

Este nuevo anuncio marca una desviación significativa de la estrategia reciente de OpenAI de mantener sus modelos más avanzados bloqueados detrás de APIs.

También se alinea con los comentarios recientes de Altman durante una sesión de preguntas y respuestas en Reddit, donde compartió por primera vez que la compañía estaba considerando la idea de lanzar un modelo completo de código abierto.

"Sí, estamos discutiendo (liberar algunos modelos pesados y publicar alguna investigación)", escribió Altman. "Personalmente, creo que hemos estado en el lado equivocado de la historia aquí y necesitamos encontrar una estrategia diferente de código abierto; no todos en OpenAI comparten esta visión, y tampoco es nuestra mayor prioridad actual".

El próximo modelo contará con capacidades de razonamiento comparables al o3-mini de OpenAI, según la publicación de Altman. Esto lo convertiría en el modelo de razonamiento abierto más capaz hasta la fecha, superando al DeepSeek R1.

Editado por Sebastian Sinclair y Josh Quittner