Figure AI finalmente reveló el "gran avance" que llevó a la comentada startup de robótica a romper lazos con uno de sus inversores, OpenAI: Una novedosa arquitectura de IA de sistema dual que permite a los robots interpretar comandos en lenguaje natural y manipular objetos que nunca han visto antes, sin necesitar un pre-entrenamiento o programación específica para cada uno.

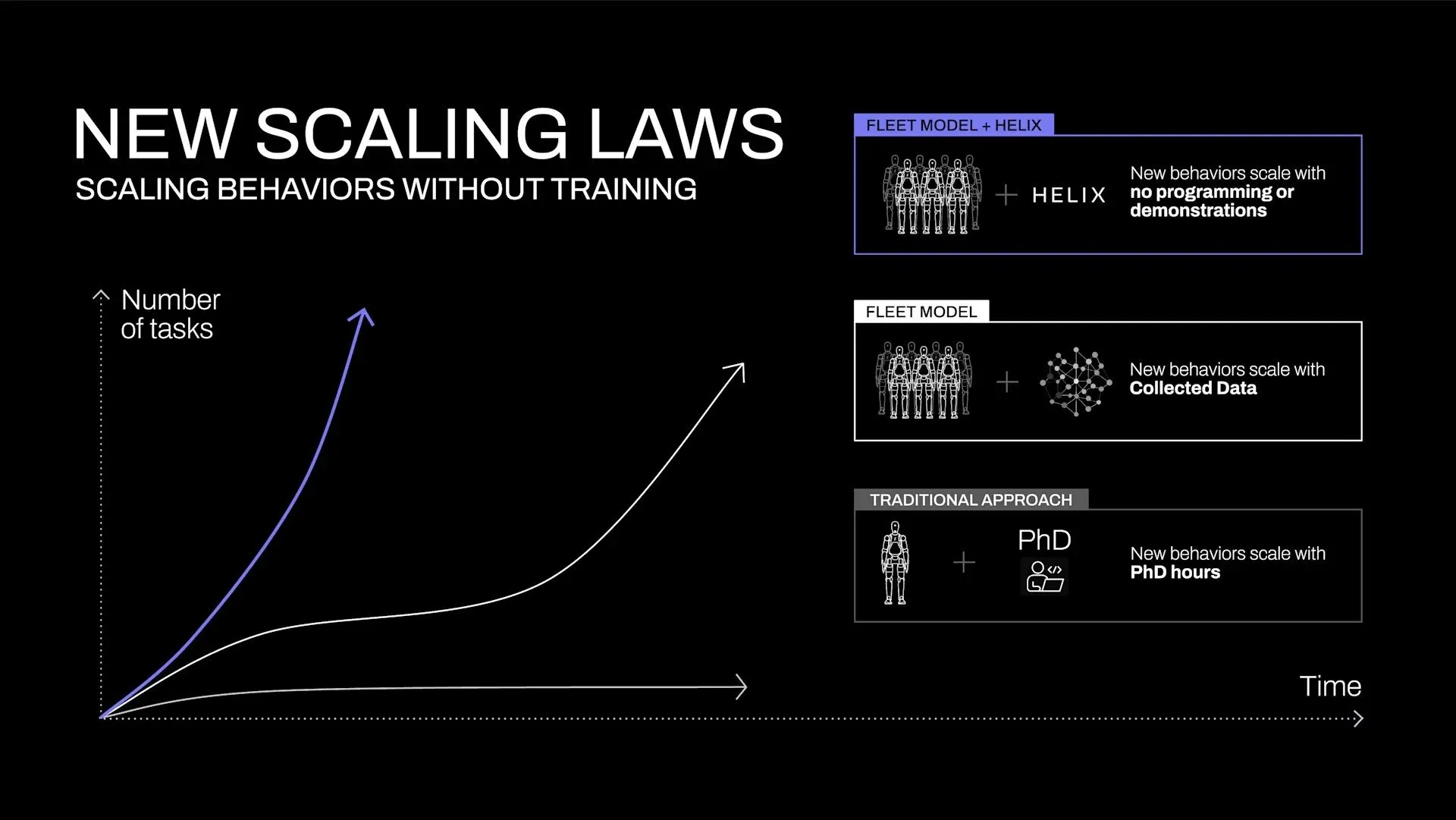

A diferencia de los robots convencionales que requieren programación extensiva o demostraciones para cada nueva tarea, Helix combina un sistema de razonamiento de alto nivel con control motor en tiempo real. Sus dos sistemas conectan efectivamente la brecha entre la comprensión semántica (saber qué son los objetos) y la acción o control motor (saber cómo manipular esos objetos).

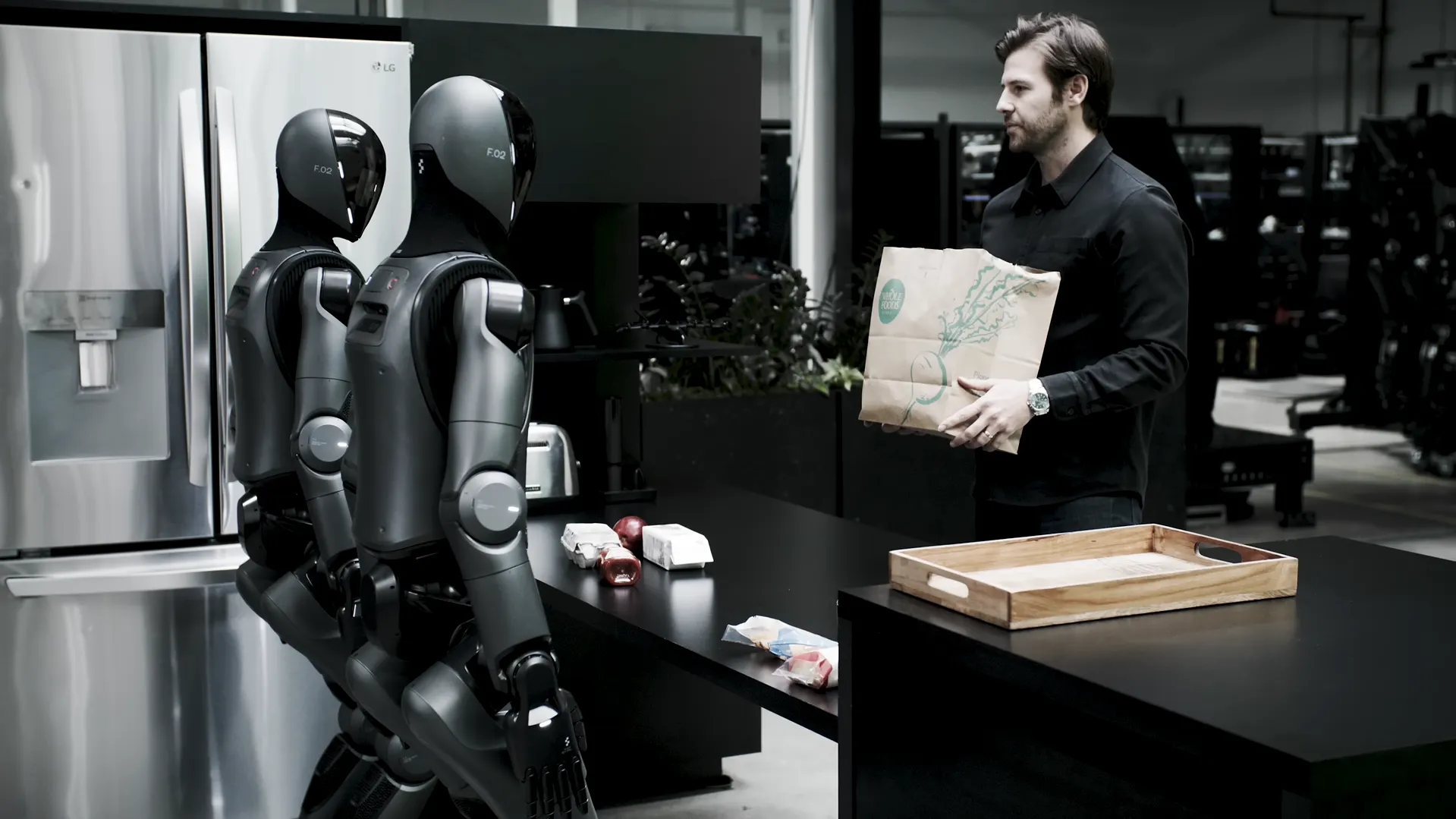

Esto hará posible que los robots se vuelvan más capaces con el tiempo sin tener que actualizar sus sistemas o entrenar con nuevos datos. Para demostrar cómo funciona, la compañía publicó un video que muestra a dos robots Figure trabajando juntos para guardar comestibles, con un robot entregando artículos a otro que los coloca en cajones y refrigeradores.

Figure afirmó que ninguno de los robots conocía los artículos con los que estaban tratando, sin embargo, fueron capaces de identificar cuáles deberían ir en un refrigerador y cuáles se supone que deben almacenarse en seco.

"Helix puede generalizar a cualquier artículo del hogar", tuiteó Adcock. "Como un humano, Helix entiende el habla, razona a través de problemas y puede agarrar cualquier objeto, todo sin necesidad de entrenamiento o código".

Cómo funciona la magia

Para lograr esta capacidad de generalización, la startup con sede en Sunnyvale, California, también desarrolló lo que llamó un modelo de Visión-Lenguaje-Acción (VLA) que unifica la percepción, la comprensión del lenguaje y el control aprendido, lo que hizo que sus modelos fueran capaces de generalizar.

Este modelo, según Figure, marca varios hitos en robótica. Produce un control continuo de todo el cuerpo superior humanoide a 200Hz, incluyendo movimientos individuales de los dedos, posiciones de la muñeca, orientación del torso y dirección de la cabeza. También permite que dos robots colaboren en tareas con objetos que nunca han visto antes.

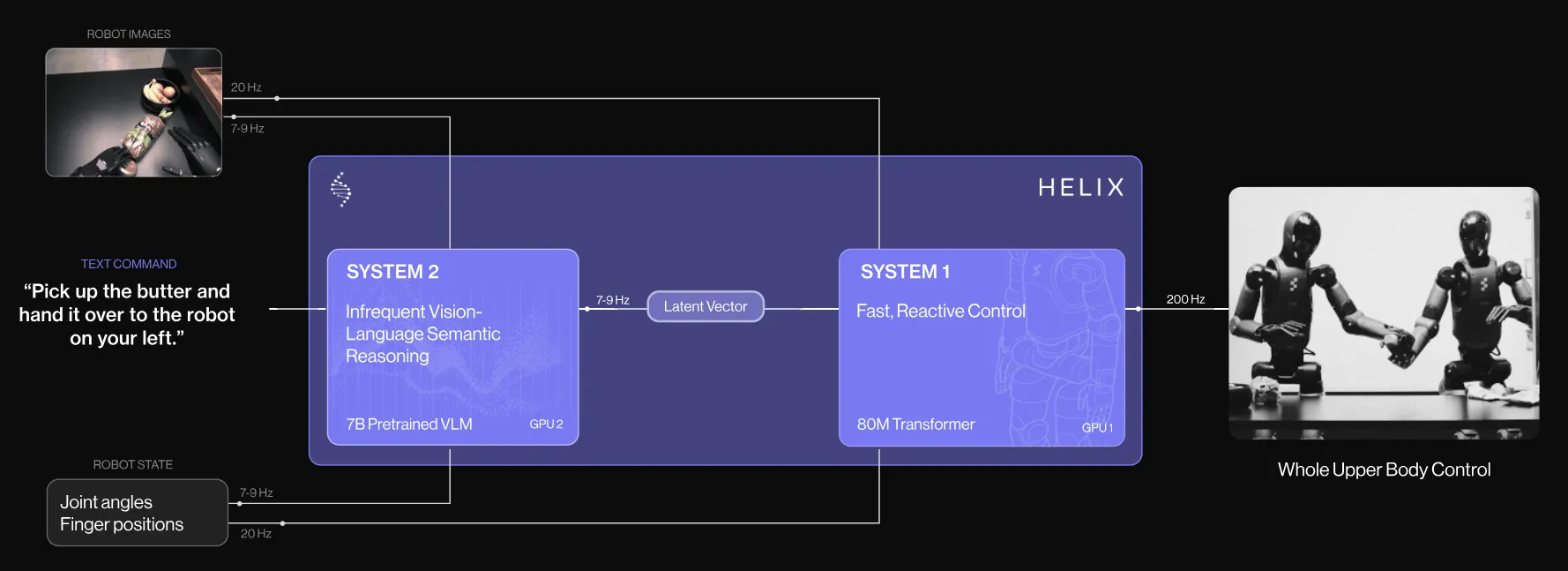

El avance en Helix proviene de su arquitectura de sistema dual que refleja la cognición humana: un modelo de visión-lenguaje "Sistema 2" de 7 mil millones de parámetros que maneja la comprensión de alto nivel a 7-9Hz (actualizando su estado 9 veces por segundo pensando lentamente para tareas o movimientos estructurales y complejos), y una política visual motora "Sistema 1" de 80 millones de parámetros que traduce esas instrucciones en movimientos físicos precisos a 200Hz (básicamente actualizando su estado 200 veces por segundo) para un pensamiento rápido.

A diferencia de enfoques anteriores, Helix utiliza un único conjunto de pesos de red neuronal para todos los comportamientos sin ajuste específico por tarea. Uno de los sistemas procesa datos de voz y visuales para permitir la toma de decisiones complejas, mientras que el otro traduce estas instrucciones en acciones motoras precisas para una respuesta en tiempo real.

"Hemos estado trabajando en este proyecto durante más de un año, con el objetivo de resolver la robótica general", tuiteó Adcock. "Programar tu salida de esto no funcionará; simplemente necesitamos un cambio de paso en las capacidades para escalar a un nivel de robot de mil millones de unidades".

Helix dice que todo esto abre la puerta a una nueva ley de escalado en robótica, una que no depende de la programación y en su lugar se basa en un esfuerzo colectivo que hace que los modelos sean más capaces sin ningún entrenamiento previo en tareas específicas.

Figure entrenó a Helix en aproximadamente 500 horas de comportamientos de robot teleoperados, luego usó un proceso de auto-etiquetado para generar instrucciones en lenguaje natural para cada demostración. Todo el sistema se ejecuta en GPUs integradas dentro de los robots, haciéndolo inmediatamente listo para uso comercial.

Figure AI dijo que ya ha asegurado acuerdos con BMW Manufacturing y un importante cliente estadounidense no identificado. La compañía cree que estas asociaciones crean "un camino hacia 100.000 robots en los próximos cuatro años", dijo Adcock.

La compañía de robótica humanoide aseguró $675 millones en financiamiento Serie B a principios de este año, de inversores como OpenAI, Microsoft, NVIDIA y Jeff Bezos, con una valoración de $2.600 millones. Según los informes, está en conversaciones para recaudar otros $1.500 millones, lo que valoraría a la compañía en $39.500 millones.

Editado por Andrew Hayward.