En Resumen

- Cuidado, tramposos: los detectores de IA están aquí para atraparte a ti y a tu chatbot con las manos en la masa.

- Los desarrolladores de IA afirman que estas herramientas pueden distinguir entre texto escrito por IA y texto escrito por humanos, pero su precisión es cuestionable.

- Según Christopher Penn, Científico de Datos Principal en Trust Insights, los detectores de IA son poco sofisticados y dañinos, y pueden llevar a decisiones injustas en contextos académicos.

Cuidado, tramposos: los detectores de IA están aquí para atraparte a ti y a tu chatbot con las manos en la masa.

O, al menos, eso es lo que los desarrolladores de IA quieren que creamos y utilizan como argumento de venta. Cuando ChatGPT entró en el espíritu cultural en 2022, los profesores se sorprendieron ante el aumento de trabajos de investigación y tareas generados por IA. Para frenar el uso de la IA en el aula, los educadores han estado utilizando detectores de IA que afirman distinguir entre texto escrito por IA y texto escrito por humanos.

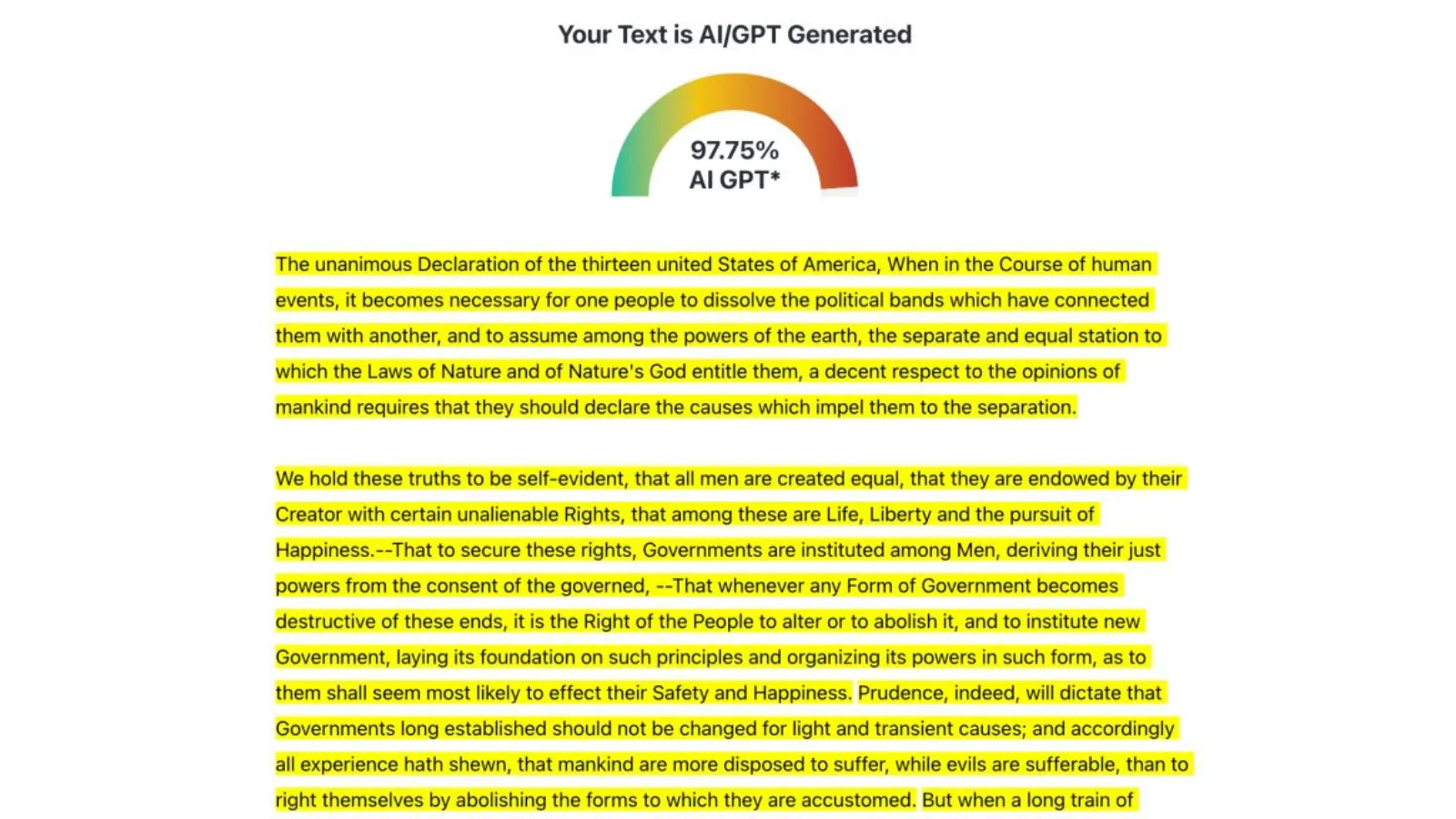

Pero, ¿qué tan precisas son estas herramientas? Según Christopher Penn, Científico de Datos Principal en la firma de análisis de marketing con sede en Boston, Trust Insights, "Los detectores de IA son una broma". Un detector de IA que probó afirmó que el 97,75% del preámbulo de la Declaración de Independencia de los EE. UU. fue generado por IA.

“Lo que me llevó a probar los detectores de IA fue ver a colegas debatiendo, discutiendo si un contenido era generado por IA”, dijo Penn a Decrypt. “Vi esto en LinkedIn; algunas personas se estaban lanzando acusaciones mutuas de que fulano estaba siendo un vago comercializador, tomando el camino fácil y simplemente usando IA.”

¿Palabras de lucha? Quizás. Dijo Penn: “Probablemente, deberíamos probar eso para entender si esto es realmente cierto.”

Penn decidió probar varios detectores de IA usando la Declaración de Independencia, y se sintió consternado por lo que encontró: "Creo que son peligrosos", dijo de tales detectores. "Son poco sofisticados y dañinos."

“Estas herramientas se están utilizando para cosas como descalificar a estudiantes, poniéndolos en probatoria académica o suspensión”, dijo. Eso es “una aplicación de muy alto riesgo cuando, en Estados Unidos, una educación universitaria cuesta decenas de miles de dólares al año.”

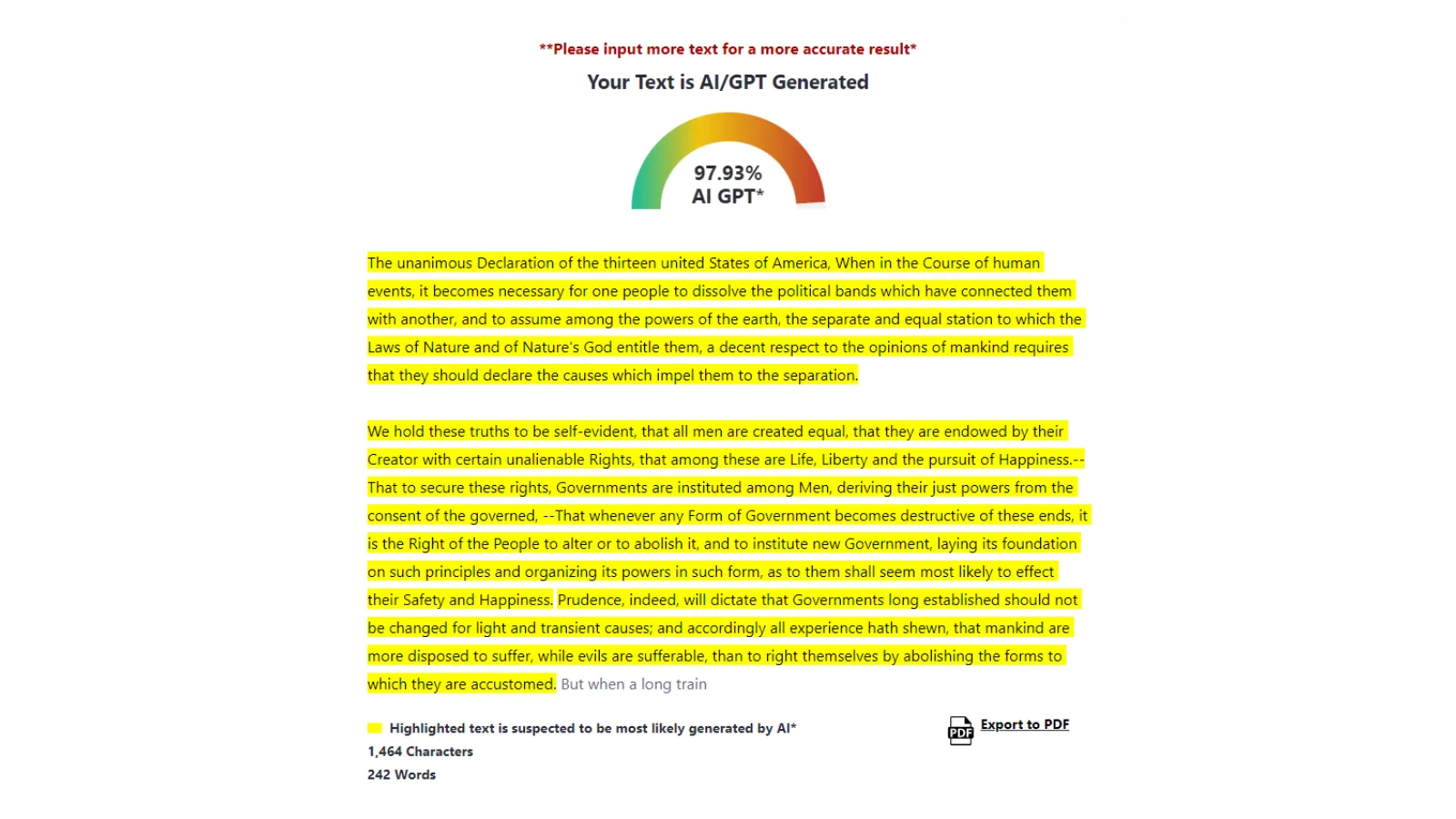

Decidimos hacer una prueba propia para ver cómo se desempeñaban estos sitios. En la primera, utilizamos el mismo fragmento que Penn usó de la Declaración de Independencia para determinar qué detectores creían erróneamente que el texto era generado por IA. Para la segunda prueba, tomamos un fragmento del cuento de ciencia ficción de 1909 de E.M. Forrester "“The Machine Stops” y le pedimos a ChatGPT que lo reescribiera para ver qué detector identificaba el pasaje como escrito por IA. Aquí están nuestros resultados:

Tomando el mismo texto que usó Penn, comparamos varios detectores de IA: Grammarly, GPTZero, QuillBot y ZeroGPT, el detector de IA que Penn mostró en su publicación de LinkedIn.

MEJOR A PEOR: Detectando texto escrito por humanos

- Grammarly. De los cuatro que probamos, Grammarly fue el mejor en detectar texto escrito por humanos y por IA. Incluso me recordó citar mi trabajo.

- El detector de IA de Quillbot también identificó el texto de la Declaración como "Escrito por humanos al 100%".

- GPTZero dio a la Declaración de Independencia una probabilidad del 89% de haber sido escrita por humanos.

- ZeroGPT la erró totalmente y dijo que el texto de la Declaración de Independencia era 97,93% generado por IA, incluso más alto que los hallazgos de Penn a principios de este mes.

En esta próxima prueba, ejecutamos “The Machine Stops” a través de ChatGPT-4o para reescribir el texto y ver si los detectores de IA podían detectar la escritura falsa.

MEJOR A PEOR: Detectando texto escrito por IA

- Grammarly fue el más efectivo en detectar contenido generado por IA al comparar "The Machine Stops" con su versión de IA.

- GPTZero identificó la historia original como escrita probablemente por humanos en un 97%, y la versión de IA como generada por IA en un 95%.

- Quillbot no pudo distinguir la diferencia entre el texto humano y el de IA, dando a ambos una probabilidad del 0%.

- ZeroGPT identificó el texto "The Machine Stops" como probablemente escrito por humanos con una probabilidad del 4,27%, pero etiquetó erróneamente la versión generada por IA como escrita por humanos con una probabilidad del 6,35%.

“Grammarly continúa profundizando su experiencia en la evaluación de la originalidad del texto y el uso responsable de la IA”, dijo un portavoz de Grammarly a Decrypt, señalando una publicación de la empresa sobre su software de detección de IA.

“Estamos agregando la detección de IA a nuestras funciones de originalidad como parte de nuestro compromiso con el uso responsable de la IA”, dijo la empresa. “Estamos priorizando brindar a nuestros usuarios, especialmente a los estudiantes, la mayor cantidad de información transparente posible, a pesar de que la tecnología tiene limitaciones inherentes”.

El portavoz de Grammarly también destacó la última actualización de la empresa, Grammarly Authorship, una extensión de Google Chrome que permite a los usuarios demostrar qué partes de un documento fueron creadas por humanos, generadas por IA o editadas por IA.

“Recomendaríamos no utilizar los resultados de detección de IA para disciplinar directamente a los estudiantes”, dijo Alex Cui, CTO de GPTZero, a Decrypt. “Creo que es útil como herramienta de diagnóstico, pero requiere nuestras herramientas de autoría para una solución real”.

Al igual que Grammarly, GPTZero cuenta con una herramienta de “autoría” que Cui recomienda utilizar para verificar que las futuras presentaciones de contenido estén escritas por humanos.

“Nuestros informes de escritura en Google Docs y nuestro propio editor analizan los patrones de escritura en un documento para ver si el documento fue escrito por un humano, y reducen en gran medida el riesgo de conclusiones incorrectas”, dijo.

Cui enfatizó la importancia de entrenar continuamente el modelo de IA en un conjunto de datos diverso.

“Utilizamos grandes modelos de procesamiento de lenguaje natural (NLP) y de machine learning entrenados en un conjunto de datos de millones de documentos generados por IA y humanos, y se prueban para tener bajos errores antes de su lanzamiento”, dijo. “Ajustamos nuestro detector para tener menos del 1% de tasas de falsos positivos antes de su lanzamiento en general para reducir el riesgo de falsos positivos”.

Penn señaló que depender ciegamente de los detectores de IA para encontrar plagio y trampas es tan peligroso como depender de la IA para escribir un informe basado en hechos.

“Mi advertencia para cualquiera que esté pensando en usar estas herramientas es que tienen tasas de falsos positivos inaceptablemente altas para cualquier aplicación crítica o de alto riesgo”, dijo Penn. “La tasa de falsos positivos, si vas a expulsar a alguien de la universidad o revocar su doctorado, tiene que ser cero. Punto. Fin de la historia. Si las instituciones hicieran esa prueba rigurosa, rápidamente descubrirían que no hay una sola herramienta en el mercado que puedan comprar. Pero eso es lo que debe suceder.”

Afortunadamente, solo el 5% de este artículo fue generado por IA.

ZeroGPT y Quillbot no respondieron de inmediato a las solicitudes de comentarios.

Editado por Andrew Hayward