En Resumen

- Google presentó mejoras en Gemini AI tras el anuncio de GPT-4, incluyendo respuestas generadas por IA en búsqueda web.

- Gemini incorporó funciones como "Preguntar a Fotos" y analizar reuniones en Google Meet para resumirlas y generar respuestas en el chat.

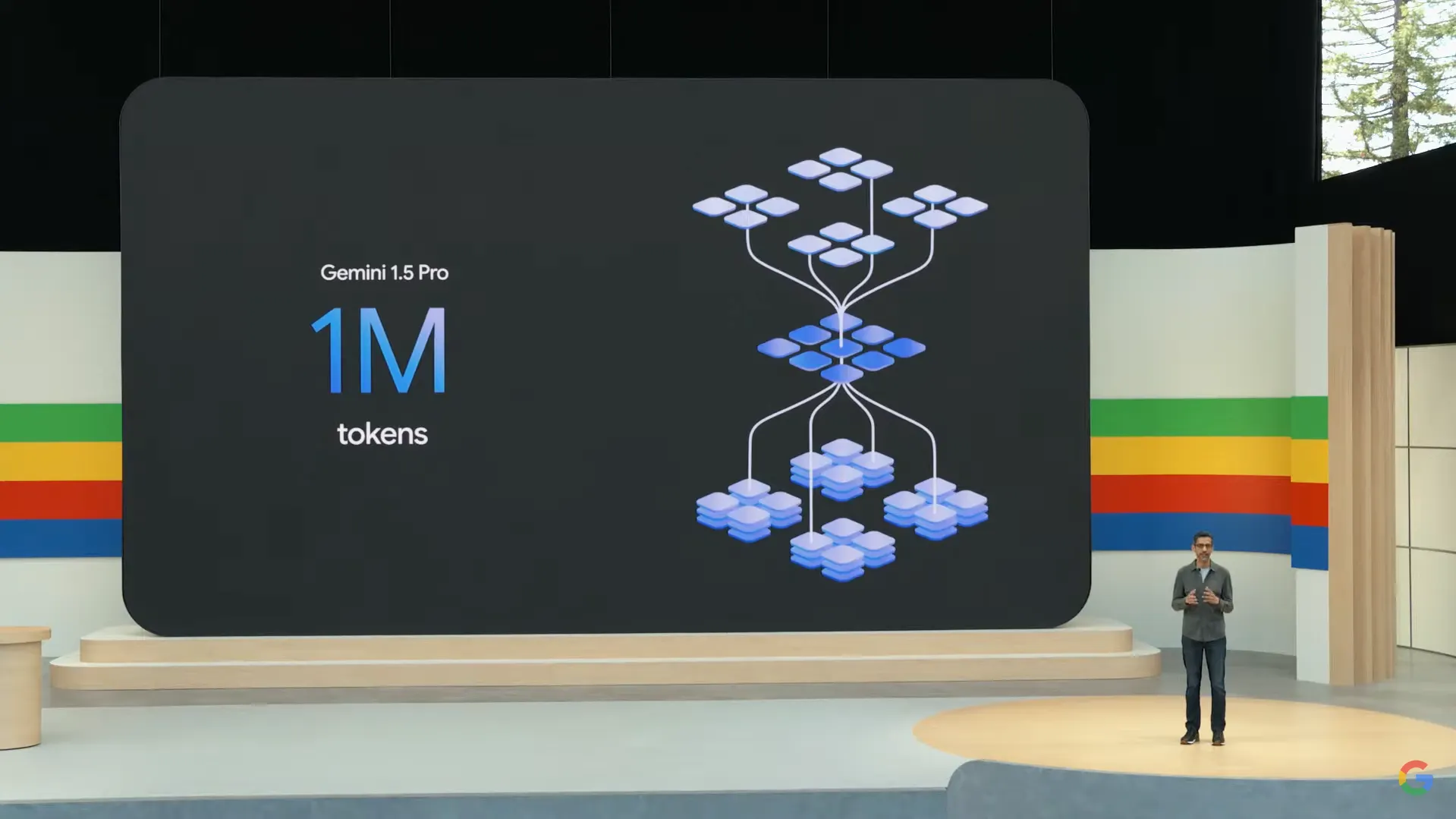

- Anunció Gemini 1.5 Pro con una ventana de contexto de 1 millón de tokens multimodales, superando a GPT-4.

El día después del tan esperado anuncio de GPT-4o de OpenAI, su mejorado Large Language Model (LLM) "omnimodal", Google respondió con una serie de mejoras a sus ofertas de inteligencia artificial de Gemini AI, mostrando su destreza tecnológica, aprovechando sus ventajas de búsqueda en vivo y consolidando su posición frente al líder en participación mental ChatGPT.

Aprovechando sus fortalezas, Google está incorporando inteligencia artificial generativa en su experiencia de búsqueda, permitiendo a los usuarios interactuar de forma natural con su motor de búsqueda en lugar de depender de consultas basadas en palabras clave. La presentación incluyó una demostración de una consulta de búsqueda en Google sobre cómo quitar una mancha de café. En lugar de simplemente mostrar enlaces a páginas web con instrucciones, el motor de búsqueda proporcionó de inmediato una respuesta completa generada por inteligencia artificial.

Estos resultados generados por IA, diseñados para abordar directa y eficientemente las consultas de los usuarios, se mostrarán por encima de los resultados de búsqueda.

A lo largo de la presentación, Google dejó claro que su dominio en la búsqueda web se traduce en una ventaja clave para sus iniciativas de IA, mostrando cómo varias funciones pueden acceder a información actual en lugar de depender de una instantánea desactualizada como otros modelos de lenguaje grandes.

Una de las características destacadas anunciadas es "Preguntar a Fotos", que permite a los usuarios tener conversaciones naturales con Gemini para buscar información en su galería. Si bien Google Fotos ha permitido durante mucho tiempo a las personas buscar en su biblioteca de imágenes a personas específicas, objetos o palabras, la actualización con IA admite consultas abiertas y en lenguaje natural.

Por ejemplo, un usuario de Google le preguntó a Gemini cuál era el número de matrícula de su coche. Gemini buscó en todas sus fotos, las evaluó y proporcionó la respuesta correcta.

Otra mejora sería familiar para los usuarios de una serie de asistentes de reuniones de IA, incluidos los integrados en plataformas de conferencias en línea como Zoom. En Google Meet, Gemini ahora puede analizar las reuniones, resumirlas y generar respuestas a preguntas en el chat. Después de una reunión, Gemini proporciona una lista de tareas pendientes y asignaciones de tareas.

Las noticias más importantes involucraron actualizaciones bajo el capó. Google anunció hoy el lanzamiento de Gemini 1.5 Pro, presumiendo de una impresionante ventana de contexto de 1 millón de tokens multimodales. Esa capacidad supera con creces el límite de 128.000 tokens de GPT-4 y ya está disponible tanto para desarrolladores como para consumidores en Gemini Advanced, el nivel de servicios de IA pago del gigante tecnológico.

Google dice que planea expandir este año aún más su capacidad de manejo de tokens, alcanzando potencialmente hasta 2 millones de tokens para desarrolladores y un aumento de diez veces sobre el de GPT-4.

Gracias a su capacidad masivamente aumentada, Google también mostró las impresionantes capacidades de recuperación de Gemini. Esta es una característica clave, porque hasta ahora, LLMs como Claude o GPT-4 muestran una degradación del rendimiento —"olvidando" información discutida previamente— cuando se les solicita grandes cantidades de datos.

Además de sus modelos de última generación, Google lanzó Gemini 1.5 Flash, un LLM multimodal compacto diseñado para competir contra Claude 3 Haiku y GPT-3.5 en proporción de respuestas rápidas. Sin embargo, su capacidad de manejo de 1 millón de tokens lo posiciona como el modelo "ligero" más potente disponible hasta la fecha.

Probablemente, el anuncio más interesante fue el Proyecto Astra de Google, un agente de IA universal que puede ser personalizado y adaptado a las necesidades de cada usuario. Google señaló que la presentación de Astra fue grabada en tiempo real, probablemente en respuesta a la demostración en vivo de GPT-4o de OpenAI ayer. La interacción parecía más capaz y menos torpe que la de GPT-4o, aunque con respuestas más concretas y menos humanas.

Here's a demo of the new Project Astra assistant! Pretty cool to see it on smart glasses too. Some of these agent experiences will come to the Gemini app later this year. pic.twitter.com/hGk6bbIzUD

— Mishaal Rahman (@MishaalRahman) May 14, 2024

Si bien la voz de Gemini también es ampliamente natural, carece de la calidad emocional, o incluso "coqueta", del nuevo asistente de ChatGPT de OpenAI. La prioridad de Google parece ser la funcionalidad, en contraste con el énfasis de OpenAI en interacciones más parecidas a las humanas.

Yendo más allá de los modelos de lenguaje tradicionales, Google presentó agentes de IA personalizables y de multiplataforma que, según afirma, son capaces de razonar, planificar y memorizar. Estas habilidades permiten que Gemini se comporte como un conjunto de IA especializadas trabajando juntas.

Estas conexiones basadas en API, que Google describió como "Gems", parecen ser una respuesta a los GPT personalizables de OpenAI. Las Gems se integran perfectamente con el ecosistema de Google, ofreciendo funciones como traducción de idiomas en tiempo real, búsqueda contextual y recomendaciones personalizadas. Los usuarios pueden moldear las Gems para enfocarse en tareas o áreas temáticas específicas, utilizando un tono específico.

Google también anunció nuevos modelos de IA generativa para imágenes, videos y música. Imagen 3, el nuevo generador de imágenes de Google, proporciona imágenes altamente realistas y detalladas, en contraste con el aspecto caricaturesco de OpenAI. También afirman que sobresale en la generación de texto, una característica que OpenAI también dice haber mejorado.

Además, lanzaron una versión mejorada de MusicLM para los entusiastas de la música generativa.

La cereza del pastel fue Veo, un modelo de video generativo, anunciado antes del lanzamiento de la muy esperada pero aún no lanzada herramienta de video Sora de OpenAI. La salida cruda sin editar sugiere un nivel de calidad comparable a la próxima entrada de OpenAI. Google dice que hará que Veo esté disponible en unas semanas, un plazo que podría superar a Sora en el mercado.

Introducing Veo: our most capable generative video model. 🎥

It can create high-quality, 1080p clips that can go beyond 60 seconds.

From photorealism to surrealism and animation, it can tackle a range of cinematic styles. 🧵 #GoogleIO pic.twitter.com/6zEuYRAHpH

— Google DeepMind (@GoogleDeepMind) May 14, 2024

Hacia el final de su presentación de más de dos horas, Google mostró su aprecio a la comunidad de código abierto, presentando a Pali Gemma, un modelo de visión de código abierto. La compañía también prometió lanzar Gemma 2, la próxima iteración de su modelo de lenguaje grande de código abierto, en junio. El nuevo modelo tendrá una ventana de contexto de token extendida y será más potente y preciso.

Finalmente, Google anunció que estaba lanzando por primera vez su conjunto de funciones impulsadas por Gemini en su sistema operativo móvil Android. Sigue el aparente favoritismo de OpenAI por las plataformas MacOS e iOS de Apple, donde estaba lanzando sus últimas actualizaciones antes de hacerlo en Windows, creado por su principal inversor, Microsoft.