In brief

- Los modelos fundamentales de IA, como Claude, Bard y LlaMA, se está volviendo menos transparentes, según investigadores de la Universidad de Stanford.

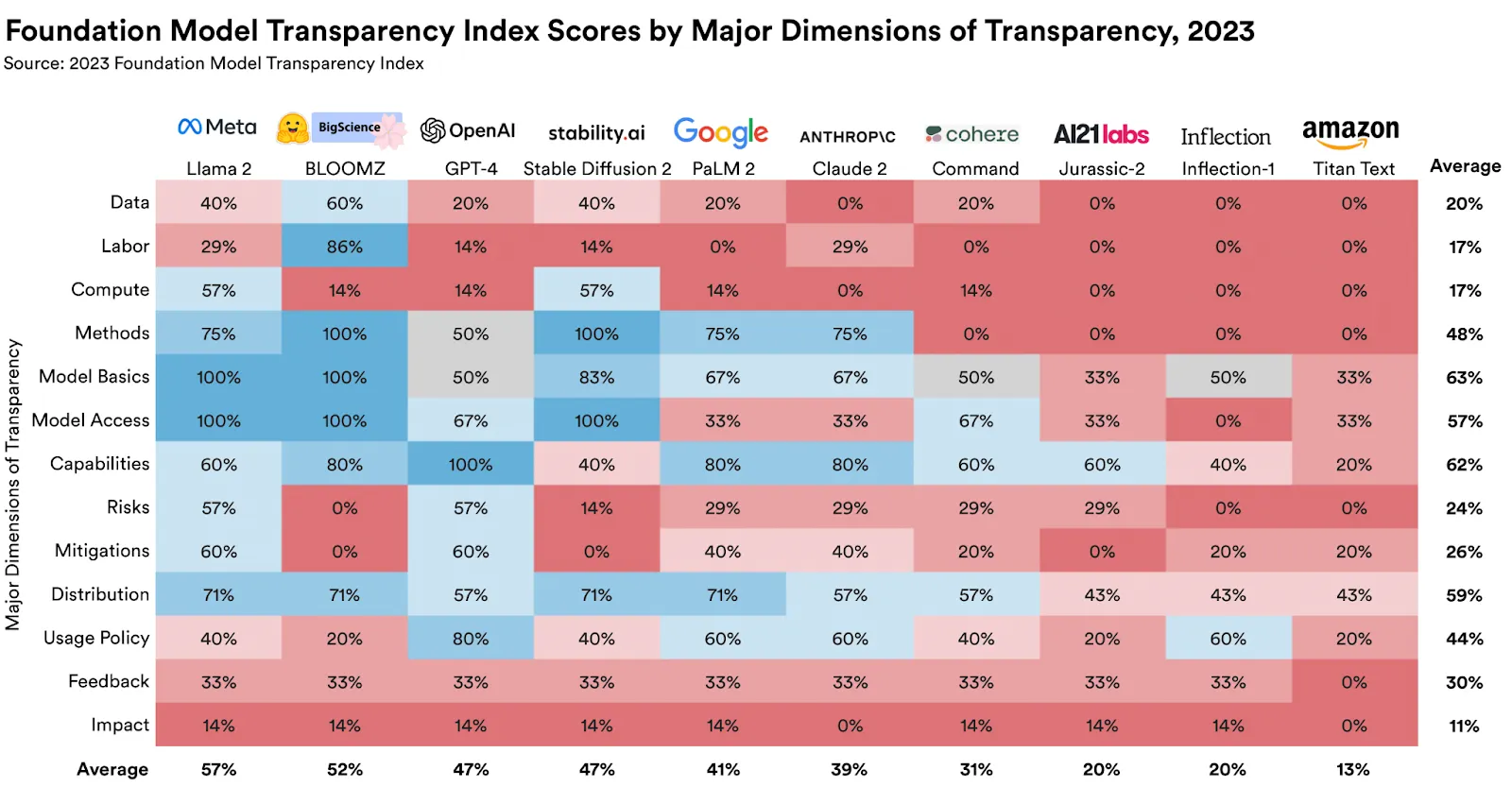

- Varias empresas de modelos fundamentales difieren en su enfoque de transparencia.

- Un índice de transparencia de modelos de IA, reveló puntuaciones bajas para empresas líderes, como Google y OpenAI.

Los principales modelos fundamentales de IA como ChatGPT, Claude, Bard y LlaMA están volviéndose menos transparentes, según un equipo de investigadores de la Universidad de Stanford.

El nuevo estudio proviene del Centro de Investigación sobre Modelos Fundamentales (CRFM) de la universidad, parte del Instituto Stanford para la Inteligencia Artificial Centrada en el Ser Humano (HAI), que estudia y desarrolla modelos fundamentales de IA.

"Las empresas en el espacio de los modelos fundamentales están volviéndose menos transparentes", dijo Rishi Bommasani, Líder de la Sociedad en CRFM, según un comunicado de prensa oficial. Esta opacidad plantea desafíos para las empresas, los responsables de políticas y los consumidores.

Las empresas detrás de los Large Language Models (LLMs) más precisos y utilizados están de acuerdo en que quieren hacer el bien, pero tienen diferentes puntos de vista con respecto a la apertura y transparencia.

Por ejemplo, OpenAI, ha adoptado la falta de transparencia como una medida de precaución.

"Ahora creemos que estábamos equivocados en nuestro pensamiento original sobre la apertura, y hemos cambiado de pensar que deberíamos publicar todo a pensar en cómo compartir de manera segura el acceso y los beneficios de los sistemas", cita un comunicado oficial.

Investigaciones del MIT de 2020 muestran que esta ha sido una filosofía central durante un tiempo. "Sus cuentas sugieren que OpenAI, a pesar de sus nobles aspiraciones, está obsesionada con mantener el secreto, proteger su imagen y retener la lealtad de sus empleados", escribieron los investigadores.

Por su parte, las opiniones fundamentales de Anthropic sobre la seguridad de la IA muestran el compromiso de la startup de "tratar los sistemas de IA de manera transparente e interpretable" y su enfoque en establecer "medidas de transparencia y procedimiento para garantizar el cumplimiento verificable de sus compromisos". Además, en agosto de 2023, Google anunció el lanzamiento de un Centro de Transparencia para divulgar mejor sus políticas y abordar este problema.

Pero, ¿por qué deberían preocuparse los usuarios por la transparencia de la IA?

"Menos transparencia dificulta que otras empresas sepan si pueden construir de manera segura aplicaciones que dependan de modelos de fundación comercial; que los académicos confíen en modelos de fundación comercial para la investigación; que los responsables de formular políticas diseñen políticas significativas para controlar esta poderosa tecnología; y que los consumidores comprendan las limitaciones del modelo o busquen reparación por los daños causados", argumenta el documento de Stanford.

Para abordar esto, Bommasani y un equipo de Stanford, el MIT y Princeton idearon el Índice de Transparencia del Modelo de Fundación (FMTI). El índice evalúa un amplio conjunto de temas que proporcionan una visión integral de la transparencia de las empresas en lo que respecta a sus modelos de IA.

Además, el ranking estudia cómo una empresa construye un modelo de fundación, la disponibilidad de su conjunto de datos, cómo funciona y cómo se utiliza en cascada, entre otros aspectos.

Los resultados del ranking fueron menos que estelares. Las puntuaciones más altas oscilaron entre 47 y 54 en una escala de 0 a 100, siendo Llama 2 de Meta el líder del grupo. OpenAI tiene un 47% de transparencia, Google solo un 41% y Anthropic obtuvo un 39% en cuanto a su transparencia.

La distinción entre modelos de código abierto y modelos de código cerrado también jugó un papel en las clasificaciones.

"En particular, cada desarrollador de código abierto es casi tan transparente en términos de puntuación agregada como el desarrollador de código cerrado con la puntuación más alta", escribió el equipo de la Universidad de Stanford en un extenso documento de investigación. Para los no científicos, eso significa que el peor modelo de IA de código abierto es más transparente que los mejores modelos de código cerrado.

La transparencia en los modelos de IA no es solo una cuestión de interés académico. La necesidad de un desarrollo de IA adecuadamente transparente ha sido expresada por los responsables políticos a nivel mundial.

"Para muchos responsables políticos en la UE, así como en EE.UU., el Reino Unido, China, Canadá, el G7 y una amplia gama de otros gobiernos, la transparencia es una prioridad política importante", dijo Bommasani.

Las implicaciones más amplias de estos hallazgos son claras. A medida que los modelos de IA se integran cada vez más en diversos sectores, la transparencia se vuelve fundamental. No solo por consideraciones éticas, sino también por aplicaciones prácticas y confiabilidad.

Editado por Stacy Elliott.