En Resumen

- Líderes tecnológicos sugieren que la IA podría ser una amenaza real para la humanidad.

- Proponen abordar el riesgo de extinción por la IA como una prioridad global comparándola con pandemias o guerras nucleares.

- El debate sobre los peligros de la IA genera opiniones diversas sobre su impacto futuro.

Prepárense: la IA podría causar la extinción de la humanidad.

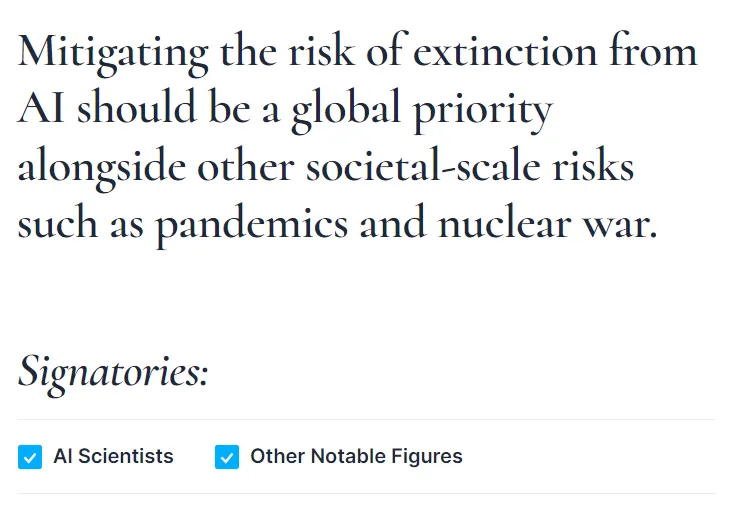

El 30 de mayo, cientos de líderes e investigadores de la industria de la inteligencia artificial (IA), incluidos ejecutivos de Microsoft, Google y OpenAI, emitieron una advertencia sombría. Afirman que la tecnología de IA que están desarrollando podría representar algún día un peligro real para la existencia de la humanidad. Junto con los horrores de las pandemias y las guerras nucleares, consideran que la IA es un riesgo social de magnitud similar.

En una carta publicada por el Centro de Seguridad de la IA, los especialistas en inteligencia artificial ofrecieron esta declaración caracterizada por su brevedad contundente: "Mitigar el riesgo de extinción por la IA debería ser una prioridad global junto con otros riesgos a escala social como las pandemias y la guerra nuclear".

Eso es todo, eso es lo que dicen.

La declaración presenta a la inteligencia artificial como una amenaza inminente, similar a un desastre nuclear o una pandemia global. Pero los firmantes y magos de la industria tecnológica, no ampliaron su ominosa advertencia.

¿Cómo se supone que sucederá este escenario apocalíptico? ¿Cuándo debemos marcar nuestros calendarios para el surgimiento de nuestros gobernantes robots? ¿Por qué la inteligencia artificial, una invención de la innovación humana, se volvería en contra de sus creadores? El silencio de estos arquitectos de la IA fue deslumbrante.

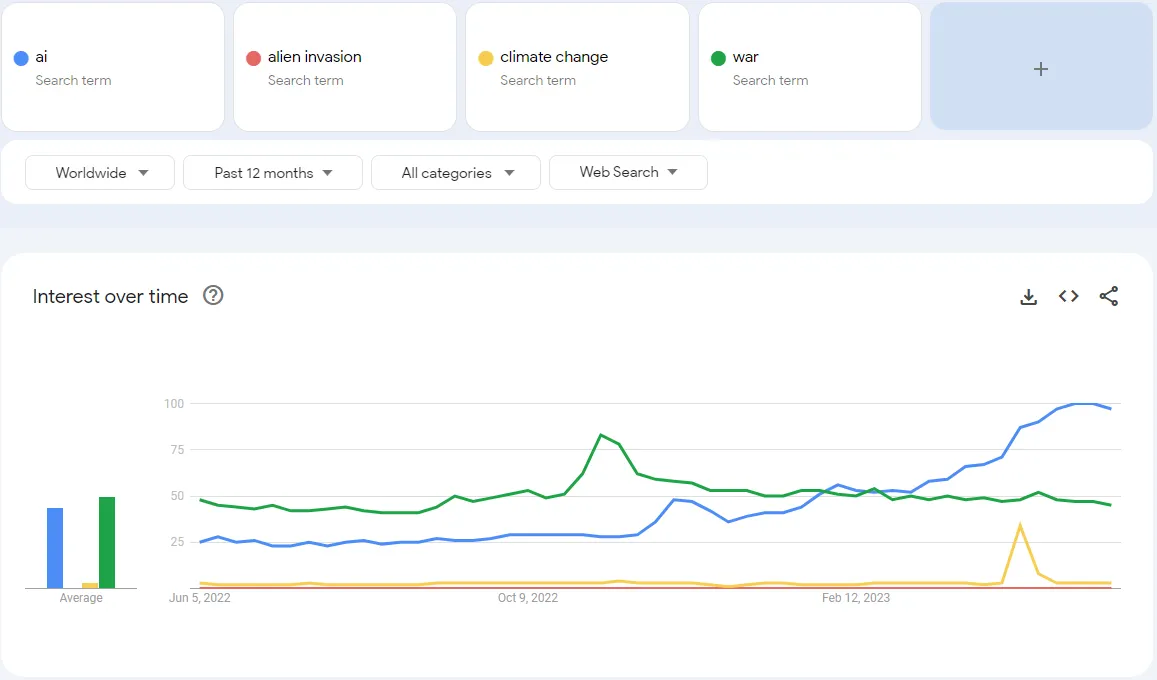

De hecho, esos líderes de la industria no fueron más informativos que un chatbot con una respuesta predefinida. En el ámbito de las amenazas globales, la inteligencia artificial parece haber saltado repentinamente la cola, superando al cambio climático, los conflictos geopolíticos e incluso las invasiones alienígenas en términos de búsquedas de palabras clave en Google.

Curiosamente, las empresas tienden a abogar por regulaciones cuando se alinean con sus intereses. Esto podría interpretarse como su forma de decir: "Deseamos tener una mano en la creación de estas regulaciones". Es similar a cuando el zorro pide nuevas reglas en el gallinero.

También es notable que el CEO de OpenAI, Sam Altman, ha estado presionando por regulaciones en los Estados Unidos. Incluso, amenazó con irse de Europa si los políticos del continente seguían intentando regular la IA. "Vamos a intentar cumplir", dijo Altman en un panel en el University College London. "Si podemos cumplir, lo haremos. Y si no podemos, dejaremos de operar".

Es justo decir que tuvo que corregir su postura un par de días después, diciendo que OpenAI no tenía planes de abandonar Europa. Esto, por supuesto, sucedió después de que tuvo la oportunidad de hablar con los reguladores sobre el tema en una "semana muy productiva".

very productive week of conversations in europe about how to best regulate AI! we are excited to continue to operate here and of course have no plans to leave.

— Sam Altman (@sama) May 26, 2023

La IA es arriesgada, ¿pero realmente es tan arriesgada?

Los posibles peligros de la inteligencia artificial no han pasado desapercibidos entre los expertos. Una carta abierta anteriormente firmada por 31,810 entusiastas tecnológicos, incluyendo a Elon Musk, Steve Wozniak, Yuval Harari y Andrew Yang, pidió una pausa en el entrenamiento de modelos de IA poderosos.

"Estos protocolos deben garantizar que los sistemas que los siguen sean seguros más allá de toda duda razonable", dice la carta, aclarando que "esto no significa una pausa en el desarrollo de la IA en general, sino simplemente un retroceso en la peligrosa carrera hacia modelos de caja negra impredecibles cada vez más grandes con capacidades emergentes".

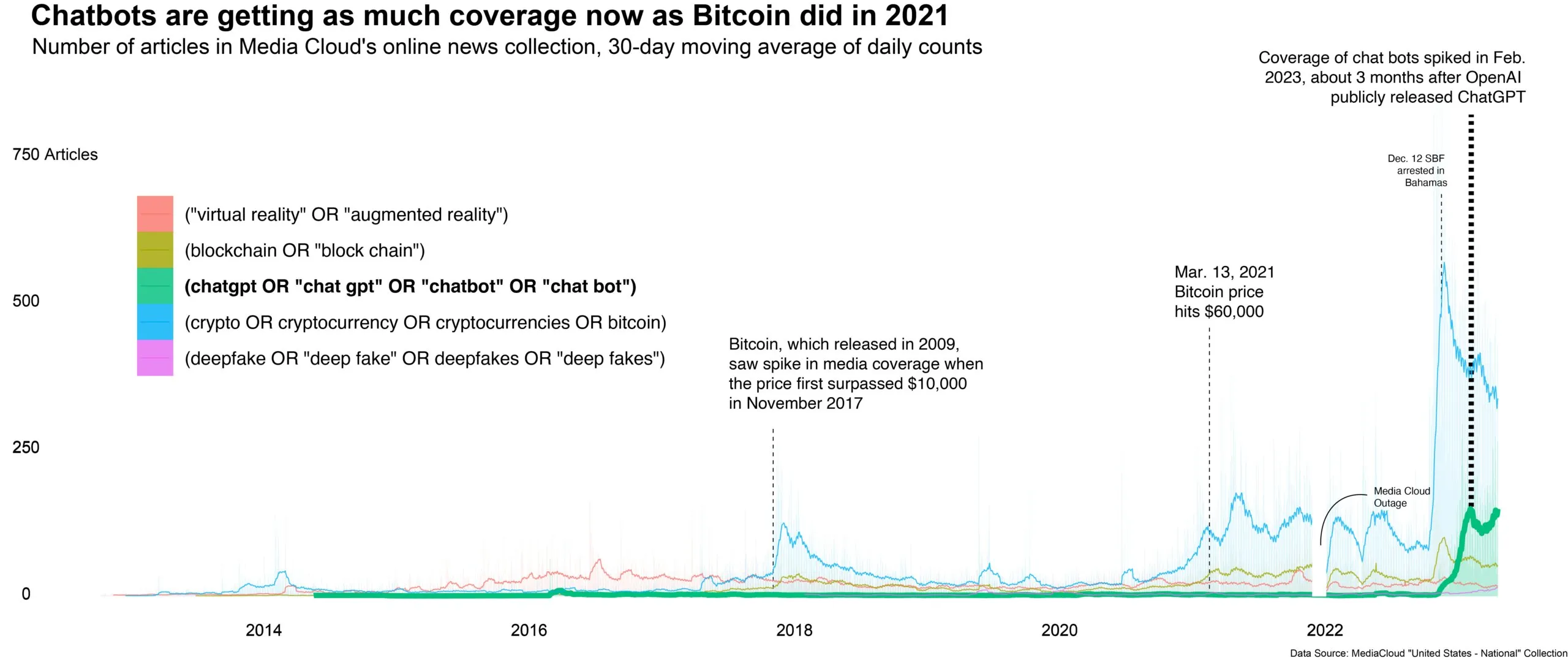

El problema de un posible AI Foom (en el que una IA se vuelve capaz de mejorar sus propios sistemas, aumentando sus capacidades hasta el punto de superar la inteligencia humana) ha sido discutido durante años. Sin embargo, el rápido ritmo de cambio de hoy en día, junto con una amplia cobertura mediática, ha llevado el debate a la atención mundial.

Esto ha generado diversas opiniones sobre cómo la IA impactará (no como simplemente podría impactar) el futuro de las interacciones sociales.

Algunos imaginan una era utópica donde la IA y los humanos interactúan de manera alineada, y el avance tecnológico reina por encima de todo. Otros creen que la humanidad se adaptará a la IA, con nuevos trabajos creados alrededor de la tecnología, similar al crecimiento laboral que siguió a la invención del automóvil. Sin embargo, otros mantienen que la IA tiene una posibilidad significativa de madurar y volverse incontrolable, planteando una amenaza real para la humanidad.

Hasta entonces, todo sigue igual en el mundo de la IA. Asi que mantén tus ojos en tu ChatGPT, tu Bard o tu Siri, ya que podrían estar a solo una actualización de software de gobernar el mundo. Aunque por ahora, parece que la mayor amenaza para la humanidad no son nuestras propias invenciones, sino más bien nuestro talento ilimitado para la exageración.