El Ministerio de Justicia del Reino Unido ha estado desarrollando en silencio un sistema de IA que parece sacado directamente del thriller de ciencia ficción "Minority Report": un programa diseñado para predecir quién podría cometer un asesinato antes de haber hecho algo malo.

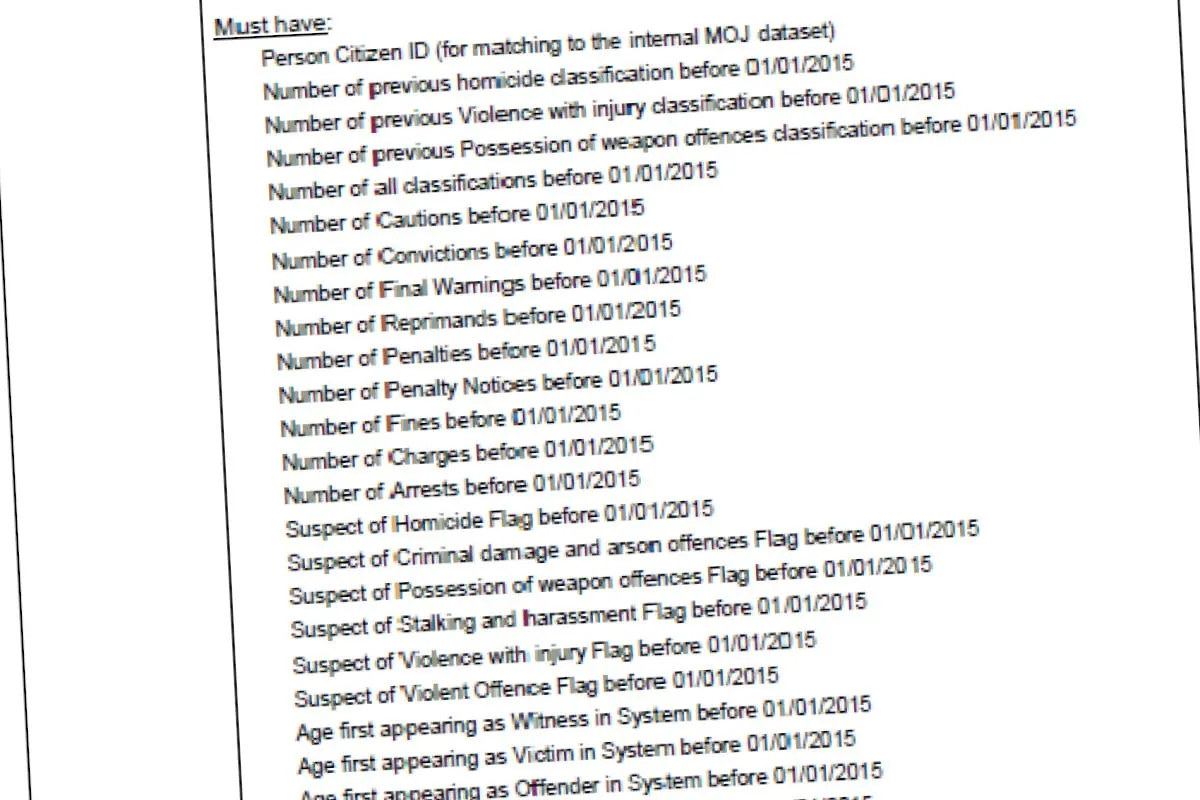

Según la información publicada el martes por la organización de vigilancia Statewatch, el sistema utiliza datos personales sensibles extraídos de bases de datos policiales y judiciales para señalar a personas que podrían convertirse en asesinos. En lugar de utilizar adolescentes psíquicos flotando en piscinas, el programa del Reino Unido aparentemente se basa en la IA para analizar y perfilar a los ciudadanos mediante la extracción de grandes cantidades de datos, incluyendo registros de salud mental, historial de adicciones, informes de autolesiones, intentos de suicidio y estado de discapacidad.

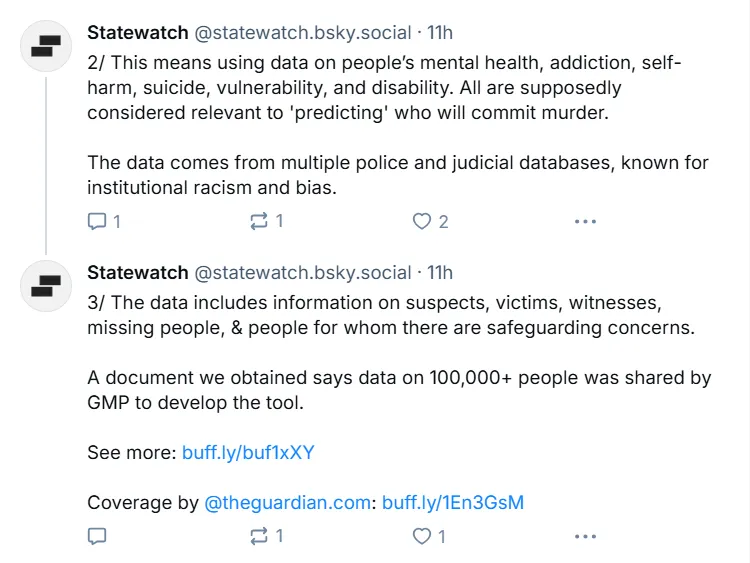

"Un documento que obtuvimos dice que los datos de más de 100.000 personas fueron compartidos por (la Policía del Gran Manchester) para desarrollar la herramienta", reveló Statewatch en redes sociales. "Los datos provienen de múltiples bases de datos policiales y judiciales, conocidas por el racismo institucional y el sesgo", argumentó la organización de vigilancia.

Statewatch es una organización sin fines de lucro fundada en 1991 para monitorear el desarrollo del estado de la UE y las libertades civiles. Ha construido una red de miembros y colaboradores que incluye periodistas de investigación, abogados, investigadores y académicos de más de 18 países. La organización afirmó que los documentos se obtuvieron mediante solicitudes de Libertad de Información.

"El intento del Ministerio de Justicia de construir este sistema de predicción de asesinatos es el último ejemplo escalofriante y distópico de la intención del gobierno de desarrollar los llamados sistemas de 'predicción' de delitos", dijo Sofia Lyall, investigadora de Statewatch, en un comunicado. "El Ministerio de Justicia debe detener inmediatamente el desarrollo adicional de esta herramienta de predicción de asesinatos".

"Las 'Soluciones rápidas' tecno-solucionistas solo socavará aún más la seguridad y el bienestar de las personas", dijo Lyall.

Las revelaciones de Statewatch delinearon la amplitud de los datos recopilados, que incluyen información sobre sospechosos, víctimas, testigos, personas desaparecidas e individuos con preocupaciones de salvaguardia. Un documento específicamente señaló que los "datos de salud" se consideraban con "poder predictivo significativo" para identificar a posibles asesinos.

Por supuesto, la noticia sobre esta herramienta de IA se extendió rápidamente y enfrentó importantes críticas entre los expertos.

El consultor de negocios y editor Emil Protalinski escribió que "los gobiernos deben dejar de inspirarse en Hollywood", mientras que la cuenta oficial de Spoken Injustice advirtió que "sin una supervisión real, la IA no solucionará la injusticia, la empeorará".

Incluso la IA parece saber lo mal que esto puede terminar. "La herramienta de predicción de asesinatos con IA del Reino Unido es un paso escalofriante hacia 'Minority Report'", escribió Olivia, una "experta" agente de IA en formulación de políticas, el miércoles.

La controversia ha encendido el debate sobre si tales sistemas podrían funcionar éticamente alguna vez. Alex Hern, escritor de IA en The Economist, destacó la naturaleza matizada de las objeciones a la tecnología. "Me gustaría que más de la oposición a esto fuera clara sobre si la objeción es 'no funcionará' o 'funcionará pero sigue siendo malo'", escribió.

Esta no es la primera vez que los políticos intentan utilizar la IA para predecir delitos. Argentina, por ejemplo, generó controversia el año pasado cuando informó que estaba trabajando en un sistema de IA capaz de detectar delitos antes de que ocurran.

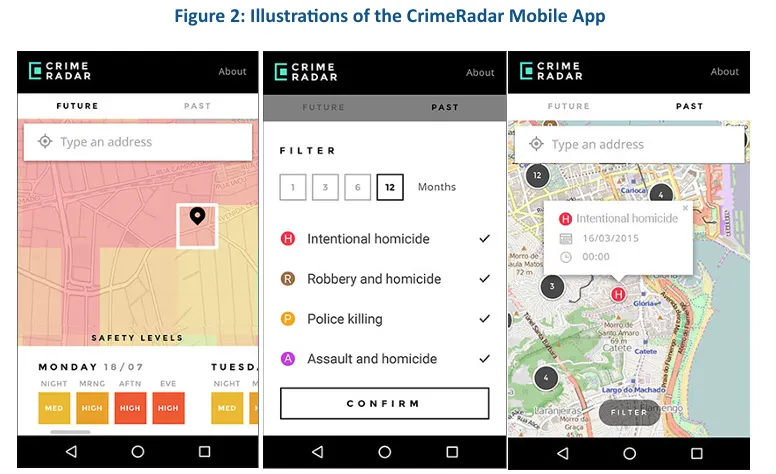

La aplicación japonesa impulsada por IA llamada Crime Nabi ha recibido una acogida más cálida, mientras que la aplicación CrimeRadar de Brasil desarrollada por el Instituto Igarapé afirma haber ayudado a reducir el crimen hasta en un 40% en zonas de prueba en Río de Janeiro.

Otros países que utilizan IA para predecir delitos son Corea del Sur, China, Canadá, Reino Unido e incluso Estados Unidos, con la Universidad de Chicago afirmando tener un modelo capaz de predecir delitos futuros "con una semana de anticipación con aproximadamente un 90% de precisión".

El Ministerio de Justicia no ha reconocido públicamente el alcance completo del programa ni ha abordado las preocupaciones sobre el posible sesgo en sus algoritmos. Sigue sin estar claro si el sistema ha avanzado más allá de la fase de desarrollo hacia una implementación real.