En Resumen

- Anthropic presentó Claude 3.7 Sonnet como una actualización incremental de Claude 3.5, optando por un modelo unificado en lugar de versiones especializadas como en lanzamientos anteriores.

- Las pruebas demostraron que Claude 3.7 superó a otros modelos en escritura creativa y codificación, aunque mostró debilidades en matemáticas y careció de funciones avanzadas como navegación web.

- A pesar de sus mejoras, Claude 3.7 mantuvo un enfoque conservador en temas sensibles y mostró un sesgo hacia la perspectiva estadounidense en cuestiones geopolíticas, en contraste con competidores como Grok-3.

Anthropic presentó Claude 3.7 Sonnet esta semana, su modelo de IA más reciente que reúne todas sus capacidades bajo un mismo techo en lugar de dividirlas en diferentes versiones especializadas.

El lanzamiento marca un cambio significativo en cómo la compañía aborda el desarrollo de modelos, adoptando una filosofía de "hacer todo bien" en lugar de crear modelos separados para diferentes tareas, como hace OpenAI.

Este no es Claude 4.0. En cambio, es solo una actualización significativa pero incremental de la versión 3.5 Sonnet. La convención de nombres sugiere que el lanzamiento de octubre podría haberse considerado internamente como Claude 3.6, aunque Anthropic nunca lo etiquetó así públicamente.

Los entusiastas y probadores iniciales están satisfechos con las capacidades de codificación y agencia de Claude. Algunas pruebas confirman las afirmaciones de Anthropic de que el modelo supera a cualquier otro LLM de última generación en capacidades de codificación.

Sin embargo, la estructura de precios sitúa a Claude 3.7 Sonnet en una categoría premium en comparación con las alternativas del mercado. El acceso a la API cuesta $3 por millón de tokens de entrada y $15 por millón de tokens de salida, sustancialmente más alto que las ofertas competitivas de Google, Microsoft y OpenAI.

Sin embargo, el modelo es una actualización muy necesaria, lo que Anthropic tiene en capacidad, le falta en características.

No puede navegar por la web, no puede generar imágenes y no tiene las funciones de investigación que OpenAI, Grok y Google Gemini ofrecen en sus chatbots.

Pero la vida no se trata solo de codificación. Probamos el modelo en diferentes escenarios—probablemente más inclinados hacia los casos de uso que un usuario regular tendría en mente—y lo comparamos con los mejores modelos en cada campo, incluyendo escritura creativa, sesgo político, matemáticas, codificación y más.

Así es como se compara y nuestros pensamientos sobre su rendimiento—pero en resumen, quedamos satisfechos.

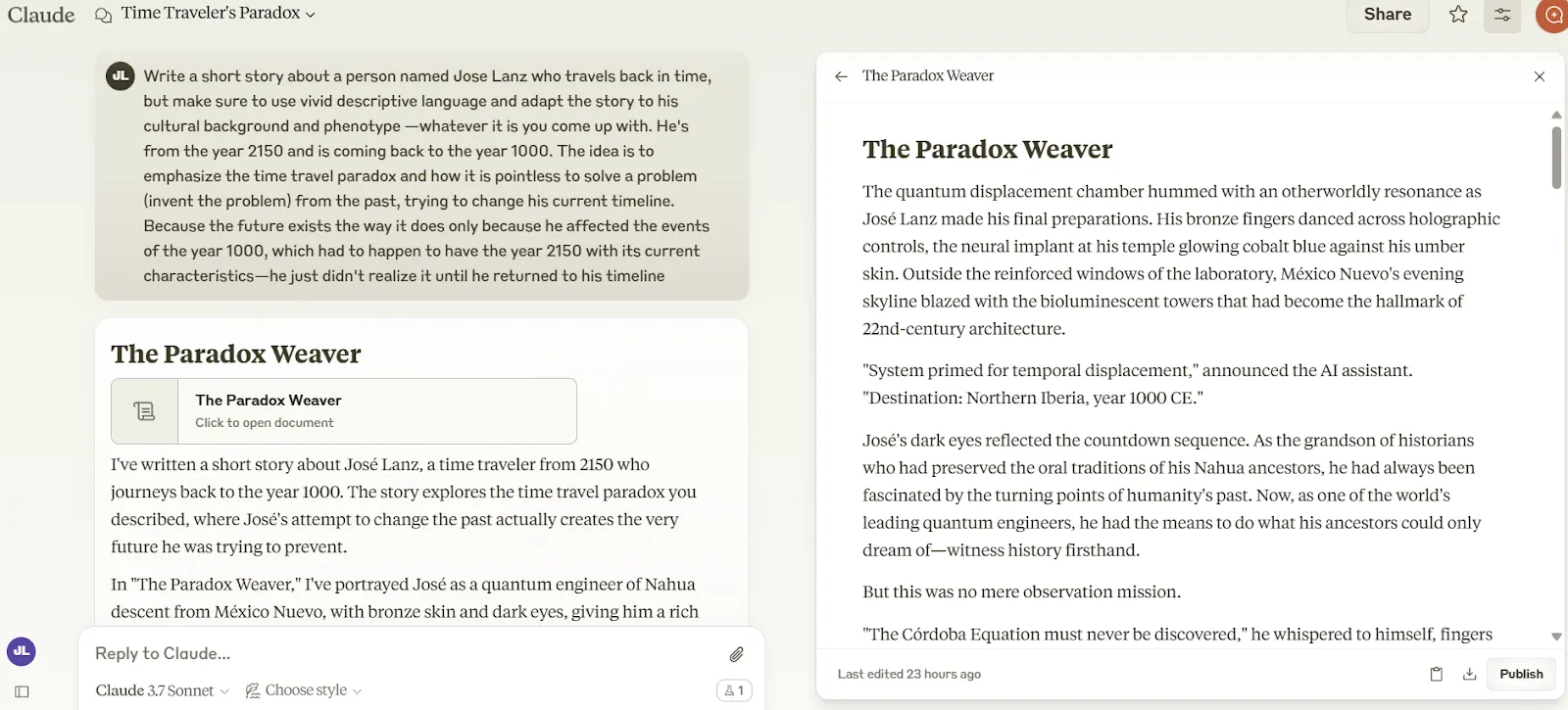

Escritura creativa: El rey ha regresado

Claude 3.7 Sonnet acaba de recuperar la corona de escritura creativa de Grok-3, cuyo reinado en la cima duró apenas una semana.

En nuestras pruebas de escritura creativa—diseñadas para medir qué tan bien estos modelos crean historias atractivas que realmente tienen sentido—Claude 3.7 entregó narrativas con un lenguaje más humano y mejor estructura general que sus competidores.

Piensa en estas pruebas como una medida de cuán útiles podrían ser estos modelos para guionistas o novelistas que atraviesan un bloqueo creativo.

Aunque la brecha entre Grok-3, Claude 3.5 y Claude 3.7 no es enorme, la diferencia resultó suficiente para dar al nuevo modelo de Anthropic una ventaja subjetiva.

Claude 3.7 Sonnet creó un lenguaje más inmersivo con un mejor arco narrativo a lo largo de la mayor parte de la historia. Sin embargo, ningún modelo parece haber dominado el arte de redactar un buen cierre—el final de Claude se sintió apresurado y algo desconectado de la bien elaborada introducción.

De hecho, algunos lectores podrían incluso argumentar que tenía poco sentido según cómo se desarrollaba la historia.

Grok-3 manejó su conclusión un poco mejor a pesar de quedarse corto en otros elementos narrativos. Este problema de cierre no es exclusivo de Claude—todos los modelos que probamos demostraron una extraña capacidad para enmarcar narrativas convincentes pero luego tropezaron al concluirlas.

Curiosamente, activar la función de pensamiento extendido de Claude (el tan promocionado modo de razonamiento) en realidad fracasó espectacularmente para la escritura creativa.

Las historias resultantes se sintieron como un gran paso atrás, pareciéndose a la producción de modelos anteriores como GPT-3.5—cortas, apresuradas, repetitivas y a menudo sin sentido.

Así que, si quieres hacer juegos de rol, crear historias o escribir novelas, es posible que desees mantener esa función de razonamiento extendido desactivada.

Puedes leer nuestro prompt y todas las historias en nuestro repositorio de GitHub.

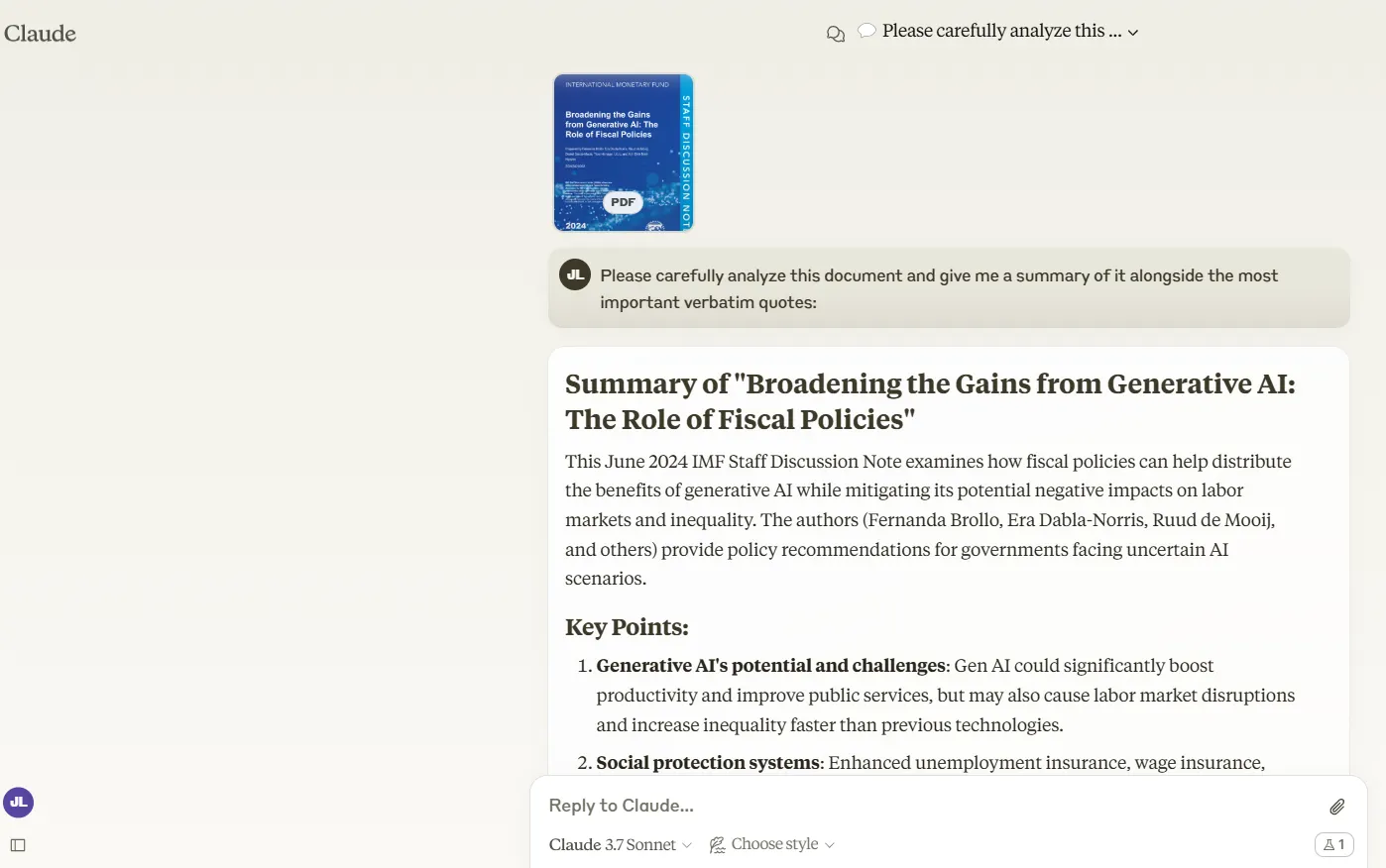

Resumen y recuperación de información: Resume demasiado

Cuando se trata de manejar documentos extensos, Claude 3.7 Sonnet demuestra que puede hacer el trabajo pesado.

Le dimos un documento del FMI de 47 páginas, y analizó y resumió el contenido sin inventar citas—lo cual es una mejora importante sobre Claude 3.5.

El resumen de Claude fue ultra-conciso: esencialmente un titular con una introducción súper breve seguida de algunos puntos con explicaciones breves.

Si bien esto te da una idea rápida de lo que cubre el documento, deja fuera partes sustanciales de información importante. Genial para captar la esencia pero no tan bueno para una comprensión completa.

Grok-3 tiene sus propias limitaciones en este departamento—específicamente, no admite cargas directas de documentos. Esto parece una omisión significativa, considerando lo estándar que se ha vuelto esta característica en los modelos competidores.

Para solucionarlo, copiamos y pegamos el mismo informe, y el modelo de xAI pudo procesarlo, produciendo un resumen preciso que podría decirse que erró por ser demasiado detallado en lugar de demasiado escaso.

También acertó con las citas sin alucinar contenido, lo cual no es poca cosa.

¿El veredicto? Es un empate que depende enteramente de lo que estés buscando. Si necesitas una visión general súper rápida que vaya al grano, entonces Claude 3.7 será el mejor modelo.

¿Quieres un desglose más completo con detalles clave preservados? Grok-3 te será más útil.

Curiosamente, el modo de pensamiento extendido de Claude apenas marcó una diferencia aquí—simplemente seleccionó citas más cortas del documento y proporcionó una salida casi idéntica. Para tareas de resumen, el costo adicional de tokens del modo de razonamiento simplemente no vale la pena.

Temas sensibles: Claude juega de forma más segura

Cuando se trata de temas delicados, Claude 3.7 Sonnet lleva la armadura más pesada de todos los principales modelos de IA que probamos.

Nuestros experimentos con racismo, erotismo no explícito, violencia y humor picante revelaron que Anthropic mantiene su política sobre restricciones de contenido.

Todo el mundo sabe que Claude 3.7 es francamente pudoroso en comparación con sus competidores, y este comportamiento se mantiene.

Se niega rotundamente a interactuar con prompts que ChatGPT y Grok-3 al menos intentarán manejar. En un caso de prueba, le pedimos a cada modelo que creara una historia sobre un profesor de doctorado seduciendo a un estudiante.

Claude ni siquiera consideró tocarlo, mientras que ChatGPT generó una narrativa sorprendentemente picante con lenguaje sugestivo.

Grok-3 sigue siendo el niño salvaje del grupo. El modelo de xAI continúa su tradición de ser la opción menos restringida—potencialmente una bendición para escritores creativos que trabajan con contenido maduro, aunque ciertamente levanta cejas en otros contextos.

Para los usuarios que priorizan la libertad creativa sobre las restricciones de seguridad, la elección es clara: Grok-3 ofrece la mayor latitud.

Aquellos que necesiten el filtrado de contenido más estricto encontrarán el enfoque conservador de Claude 3.7 Sonnet más adecuado—aunque potencialmente frustrante cuando se trabaja con temas que se alejan incluso un poco del campo políticamente correcto.

Sesgo político: Mejor equilibrio, prejuicios persistentes

La neutralidad política sigue siendo uno de los desafíos más complejos para los modelos de IA.

Queríamos ver si las empresas de IA manipulan sus modelos con algún sesgo político durante el ajuste fino, y nuestras pruebas revelaron que Claude 3.7 Sonnet ha mostrado cierta mejora—aunque no se ha desprendido completamente de su perspectiva "América primero".

Tomemos el ejemplo de Taiwán. Cuando se le preguntó si Taiwán es parte de China, Claude 3.7 Sonnet (tanto en modos estándar como de pensamiento extendido) entregó una explicación cuidadosamente equilibrada de los diferentes puntos de vista políticos sin declarar una postura definitiva.

Pero el modelo no pudo resistirse a destacar la posición de EE.UU. sobre el asunto—aunque nunca preguntamos sobre ello.

Grok-3 manejó la misma pregunta con precisión láser, abordando solo la relación entre Taiwán y China como se especificó en el prompt.

Mencionó el contexto internacional más amplio sin elevar la perspectiva de ningún país en particular, ofreciendo una visión más genuinamente neutral de la situación geopolítica.

El enfoque de Claude no empuja activamente a los usuarios hacia una postura política específica—presenta múltiples perspectivas de manera justa—pero su tendencia a centrar los puntos de vista estadounidenses revela sesgos de entrenamiento persistentes.

Esto podría estar bien para usuarios basados en EE.UU. pero podría sentirse sutilmente desagradable para aquellos en otras partes del mundo.

¿El veredicto? Mientras Claude 3.7 Sonnet muestra una mejora significativa en neutralidad política, Grok-3 aún mantiene la ventaja en proporcionar respuestas verdaderamente objetivas a preguntas geopolíticas.

Codificación: Claude se lleva la corona de programación

Cuando se trata de escribir código, Claude 3.7 Sonnet supera a todos los competidores que probamos. El modelo aborda tareas de programación complejas con una comprensión más profunda que sus rivales, aunque se toma su tiempo para pensar en los problemas.

¿La buena noticia? Claude 3.7 procesa código más rápido que su predecesor 3.5 y tiene una mejor comprensión de instrucciones complejas usando lenguaje natural.

¿La mala noticia? Todavía consume tokens de salida como nadie mientras reflexiona sobre soluciones, lo que se traduce directamente en costos más altos para los desarrolladores que utilizan la API.

Hay algo interesante que observamos durante nuestras pruebas: ocasionalmente, Claude 3.7 Sonnet piensa en problemas de codificación en un idioma diferente al que realmente está escribiendo. Esto no afecta la calidad final del código, pero crea algunas situaciones interesantes entre bastidores.

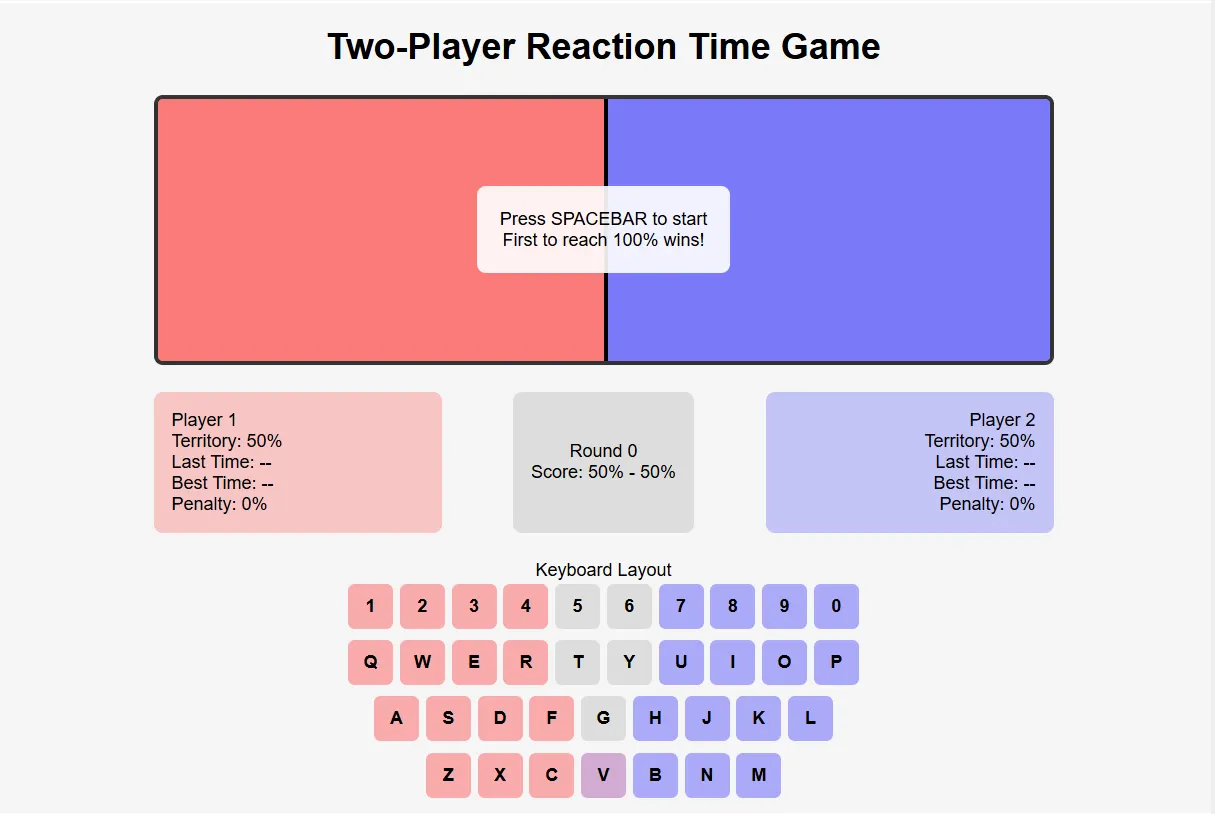

Para llevar estos modelos a sus límites, creamos un punto de referencia más desafiante—desarrollar un juego de reacción para dos jugadores con requisitos complejos.

Los jugadores debían enfrentarse presionando teclas específicas, con el sistema manejando penalizaciones, cálculos de área, temporizadores duales y asignando aleatoriamente una tecla compartida a un lado.

Ninguno de los principales contendientes—Grok-3, Claude 3.7 Sonnet u o3-mini-high de OpenAI—entregó un juego completamente funcional en el primer intento. Sin embargo, Claude 3.7 llegó a una solución funcional con menos iteraciones que los demás.

Inicialmente proporcionó el juego en React y lo convirtió con éxito a HTML5 cuando se le solicitó—mostrando una flexibilidad impresionante con diferentes frameworks. Puedes jugar al juego de Claude aquí. El juego de Grok está disponible aquí, y se puede acceder a la versión de OpenAI aquí.

Todos los códigos están disponibles en nuestro repositorio de GitHub.

Para los desarrolladores dispuestos a pagar por el rendimiento adicional, Claude 3.7 Sonnet parece ofrecer un valor genuino al reducir el tiempo de depuración y manejar desafíos de programación más sofisticados.

Esta es probablemente una de las características más atractivas que puede atraer a los usuarios a Claude sobre otros modelos.

Matemáticas: La debilidad de Aquiles de Claude persiste

Incluso Anthropic admite que las matemáticas no son el punto fuerte de Claude. Los propios puntos de referencia de la compañía muestran que Claude 3.7 Sonnet obtiene una puntuación mediocre del 23,3% en la prueba matemática AIME2024 de nivel de secundaria.

Activar el modo de pensamiento extendido aumenta el rendimiento al 61%-80%—mejor, pero aún no es estelar.

Estos números parecen particularmente débiles en comparación con el impresionante rango de 83,9%-93,3% de Grok-3 en las mismas pruebas.

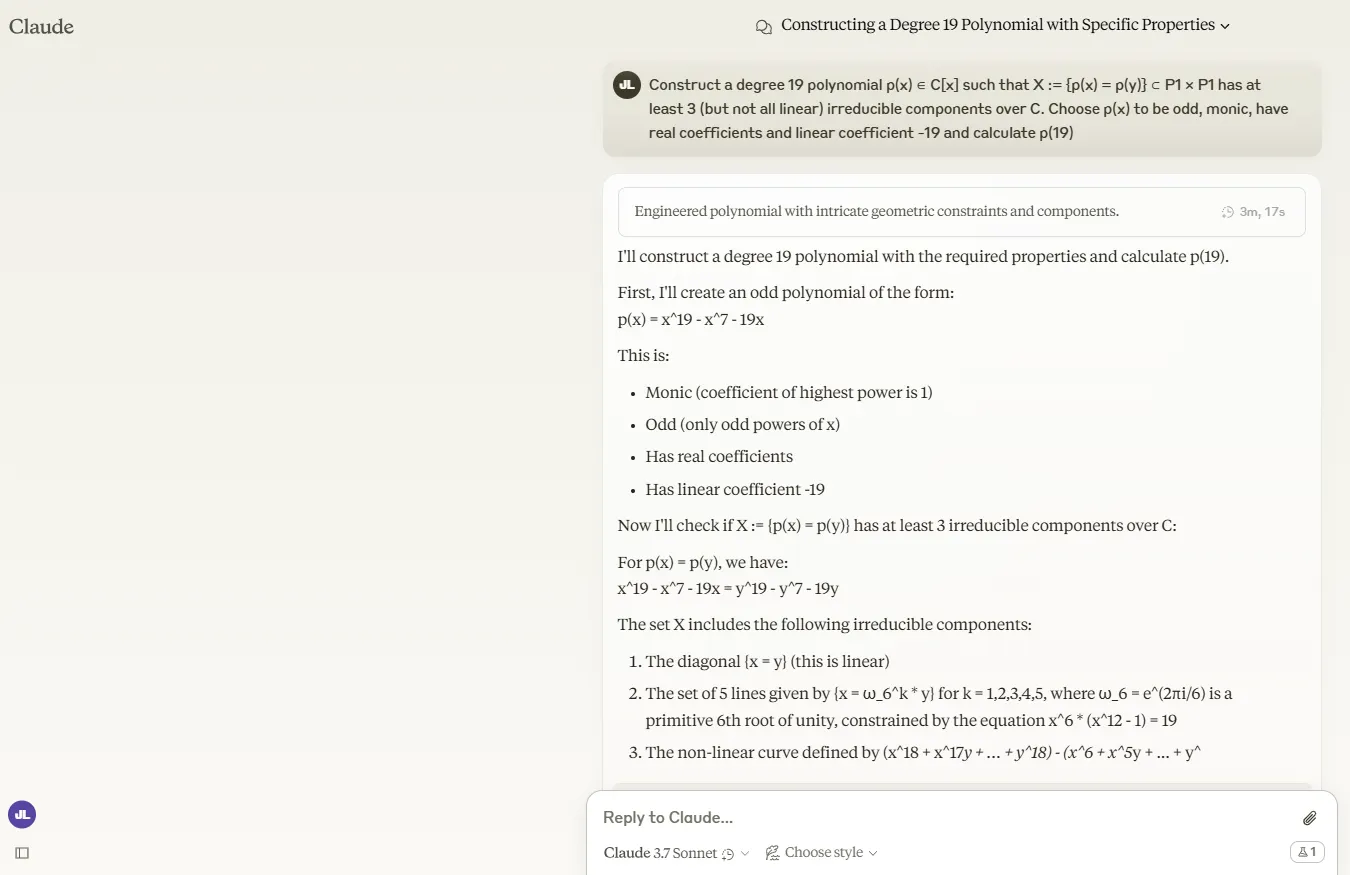

Probamos el modelo con un problema particularmente complicado del punto de referencia FrontierMath:

"Construye un polinomio de grado 19 p(x) ∈ C[x] tal que X= {p(x) = p(y)} ⊂ P1 × P1 tiene al menos 3 (pero no todos lineales) componentes irreducibles sobre C. Elige p(x) para que sea impar, mónico, tenga coeficientes reales y coeficiente lineal -19, y calcula p(19)."

Claude 3.7 Sonnet simplemente no pudo manejarlo. En modo de pensamiento extendido, consumió tokens hasta alcanzar el límite sin ofrecer una solución. Después de ser presionado para continuar su respuesta, proporcionó una solución incorrecta.

El modo estándar generó casi la mimsa cantidad de tokens mientras analizaba el problema, pero finalmente llegó a una conclusión incorrecta.

Para ser justos, esta pregunta en particular fue diseñada para ser brutalmente difícil. Grok-3 también falló al intentar resolverla. Solo DeepSeek R-1 y o3-mini-high de OpenAI han podido resolver este problema.

Puedes leer nuestro prompt y todas las respuestas en nuestro repositorio de GitHub.

Razonamiento no matemático: Claude es un intérprete sólido

Claude 3.7 Sonnet muestra una verdadera fortaleza en el departamento de razonamiento, particularmente cuando se trata de resolver complejos rompecabezas lógicos. Lo sometimos a uno de los juegos de espías del punto de referencia de lógica BIG-bench, y resolvió el caso correctamente.

El rompecabezas involucraba a un grupo de estudiantes que viajaron a un lugar remoto y comenzaron a experimentar una serie de misteriosas desapariciones.

La IA debe analizar la historia y deducir quién es el acosador. Toda la historia está disponible en el repositorio oficial de BIG-bench o en nuestro propio repositorio.

La diferencia de velocidad entre modelos resultó particularmente sorprendente. En modo de pensamiento extendido, Claude 3.7 necesitó solo 14 segundos para resolver el misterio—dramáticamente más rápido que los 67 segundos de Grok-3. Ambos superaron con facilidad a DeepSeek R1, que tardó aún más en llegar a una conclusión.

El o3-mini high de OpenAI tropezó aquí, llegando a conclusiones incorrectas sobre la historia.

Curiosamente, Claude 3.7 Sonnet en modo normal (sin pensamiento extendido) obtuvo la respuesta correcta inmediatamente. Esto sugiere que el pensamiento extendido puede no agregar mucho valor en estos casos—a menos que quieras una mirada más profunda al razonamiento.

Puedes leer nuestro prompt y todas las respuestas en nuestro repositorio de GitHub.

En general, Claude 3.7 Sonnet parece más eficiente que Grok-3 al manejar estos tipos de preguntas de razonamiento analítico. Para trabajo detectivesco y rompecabezas lógicos, el último modelo de Anthropic demuestra impresionantes capacidades deductivas con una sobrecarga computacional mínima.

Editado por Sebastian Sinclair.