En Resumen

- Presearch lanzó PreGPT 2.0, un chatbot de IA descentralizado con modelos de lenguaje mejorados y opciones de código abierto.

- El modelo ofrece dos niveles de suscripción: un plan básico con Mistral 7B por $2/mes y una versión pro con Venice.ai por $5/mes.

- PreGPT 2.0 se ejecuta en una red distribuida en lugar de centros de datos centralizados, priorizando la privacidad del usuario.

- La experiencia de uso es fluida, aunque los modelos de IA no compiten con GPT-4 o DeepSeek en capacidad.

Presearch, un motor de búsqueda descentralizado y orientado a la privacidad, acaba de lanzar PreGPT 2.0, marcando el último intento de la compañía por desafiar el dominio de las grandes empresas tecnológicas en el espacio de los chatbots de IA.

El nuevo lanzamiento trajo modelos de lenguaje mejorados y una selección más amplia de opciones de IA de código abierto, todo funcionando en una red de computadoras distribuidas en lugar de centros de datos centralizados.

“¿Por qué estoy tan emocionado? “Porque PreGPT 2.0 es tan poderoso y sin restricciones, que tiene el potencial de interrumpir fundamentalmente el efecto de cámara de eco que durante mucho tiempo ha estado manipulando la sabiduría convencional, amplificando el instinto de rebaño hacia la conformidad ciega”, dijo Brenden Tacon, líder de innovación y operaciones de Presearch, a Decrypt.

El chatbot actualizado viene con dos niveles de suscripción: un plan básico de $2 mensuales que ejecuta el modelo 7B de Mistral AI y una versión pro de $5 impulsada por los LLM más sofisticados de Venice.ai. Ambas opciones prometen mantener privados los datos del usuario y las conversaciones sin monitorear, con los chats borrados permanentemente al eliminarlos.

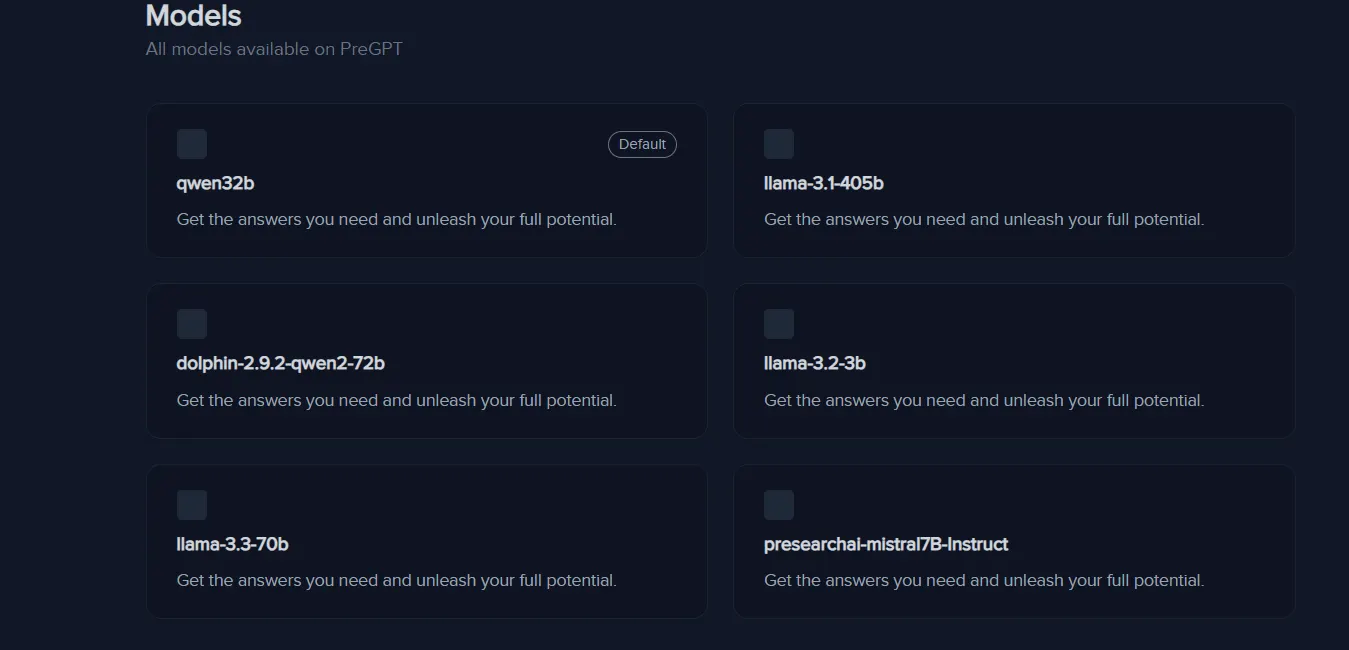

La alineación de modelos de PreGPT 2.0 presenta cinco de los nombres más conocidos en el espacio de IA de código abierto, incluyendo el Llama-3.2-3b de Meta (un modelo muy pequeño construido para la eficiencia) y Llama-3.3-70b (su último LLM), y el Qwen 32b de Alibaba.

Incluso aprovecha el antiguo modelo Dolphin 2.9, previamente conocido en los círculos de IA por estar completamente sin censura y ser poderoso, y bueno en el juego de roles. La compañía también parece haber ajustado el modelo Mistral 7B para ofrecer una versión personalizada.

“Este modelo maneja elegantemente un contexto de 8.000 Tokens, que equivale a aproximadamente 5.000 palabras, y será limitado a 1.000 mensajes por mes”, según el sitio web de la compañía.

Esto significa que el modelo tendrá una memoria de 5.000 palabras y no podrá manejar adecuadamente conversaciones que excedan ese límite, o no procesará prompts que sean tan largos.

¿Qué es Presearch?

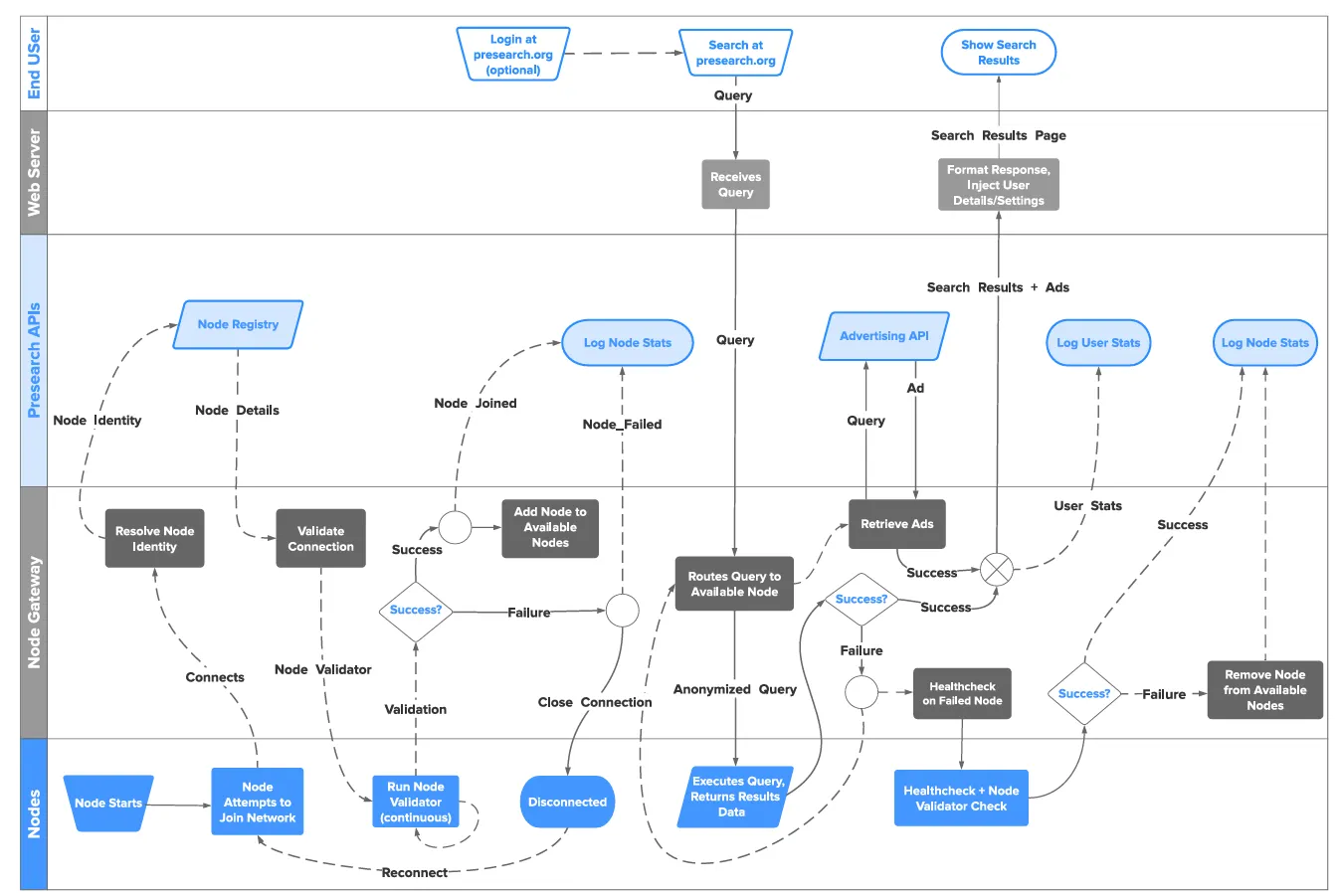

Presearch, que se lanzó en versión beta en 2017 y salió al aire en 2018, es básicamente un proyecto que quiere reimaginar la arquitectura del motor de búsqueda con tecnología descentralizada.

La plataforma procesó más de 12 millones de búsquedas mensuales a través de una red de nodos independientes. Cada operador de nodo hizo staking del token PRE y prestó poder de cómputo a la red, creando un ecosistema autosostenible que se escalaba naturalmente con la demanda.

La idea es que una red descentralizada hace que el perfilado de usuarios (el modelo de negocio de Google) sea más difícil y podría ayudar a generar un modelo de negocio más transparente y orgánico.

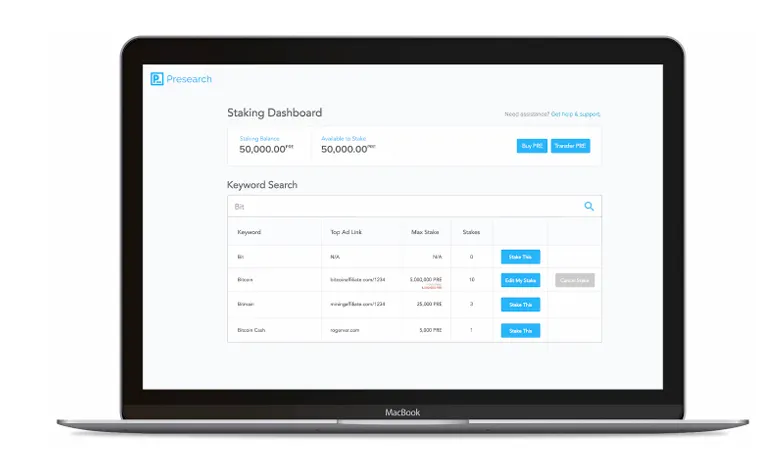

Por ejemplo, el modelo publicitario de la plataforma también es diferente de lo que ves en Google o Bing.

En lugar de guerras de ofertas por palabras clave, los anunciantes hicieron staking de tokens PRE para ganar visibilidad. Cuantos más tokens dejen en staking, mejor será su posición, mediante un sistema que reduce la circulación de tokens mientras crea ingresos predecibles.

PreGPT 2.0 aprovechó esta infraestructura distribuida colaborando con Venice.ai, un proveedor de servicios de IA consciente de la privacidad, y Salad.com, una comunidad que comparte poder GPU descentralizado.

El nivel profesional opera en la red de alto rendimiento de Venice.ai, mientras que el plan básico está respaldado por la red GPU distribuida de Salad.com.

Ambas vías encriptan las interacciones del usuario y se abstienen de almacenar registros de chat, manteniendo el compromiso de Presearch con la privacidad.

El tokenomics de PRE mantiene el sistema funcionando sin problemas. Los usuarios ganan hasta 8 tokens diarios por consultas de búsqueda, mientras que los operadores de nodos reciben recompensas basadas en su tamaño de apuesta y volumen de búsqueda.

Esto, al menos en teoría, parece una situación beneficiosa para todos, en la que tanto usuarios como anunciantes son recompensados adecuadamente mientras ayudan a crecer el ecosistema.

PreGPT 2.0 es una función de IA separada agregada al conjunto de herramientas de Presearch; la compañía permanece enfocada en su misión principal de búsqueda descentralizada y privada.

La integración del chatbot está destinada a complementar la experiencia de búsqueda sin eclipsarla.

El objetivo es hacer que toda la plataforma sea ideal para usuarios conscientes de la privacidad, que quieren un reemplazo para las búsquedas web tradicionales y están curiosos por usar herramientas de IA en su vida cotidiana.

Pruebas con PreGPT 2.0: Promesas y Limitaciones

Probamos PreGPT 2.0 y llegamos a la conclusión de que es un chatbot capaz que prioriza la función sobre el destello. La interfaz se sintió más limpia que competidores como Venice.ai o Hugging Chat, aunque carecía de capacidades de generación de imágenes que se han vuelto estándar en otros lugares.

La experiencia general se sentirá familiar para aquellos acostumbrados a experimentar con diferentes chatbots.

Esto no fue un salto revolucionario en la capacidad de IA, sino más bien una implementación enfocada en la privacidad de modelos de código abierto existentes que a menudo son menos poderosos que las alternativas principales como GPT-4 o Deepseek.

La plataforma solo maneja texto sin formato. Puede crear un cuento para dormir o resumir tendencias, pero carece de soporte para documentos Excel y no puede formatear adecuadamente archivos CSV, PDF o documentos de terceros.

En cambio, los usuarios deben copiar el contenido de una hoja y pegarlo, lo cual está lejos de ser ideal. Aquellos que confunden la descentralización con velocidades lentas no tienen nada de que preocuparse.

Las respuestas fueron rápidas, y el chatbot nunca se colgó. Pero los modelos ofrecieron la calidad que esperarías de un LLM de código abierto que no están realmente encabezando las listas en LLM Arena: LLama 3.1 405b está actualmente en la posición 27 y es el modelo más poderoso en la lista de Presearch.

No es malo, pero tampoco es impresionante según los estándares actuales.

Actualmente, hay algunas implementaciones de código abierto que son mucho más poderosas con tamaños argumentablemente similares.

Por ejemplo, Llama-3.1-Nemotron-70B-Instruct podría sustituir fácilmente cualquier versión del Llama original con mejores resultados y DeepSeek R1, siendo el mejor modelo de código abierto hasta la fecha, también podría ser una buena adición.

En general, la experiencia fue agradable; los modelos funcionaron como se esperaba, y la interfaz era más fácil de usar que Venice AI, su principal competidor.

Si estás buscando una solución de privacidad o quieres probar todas las herramientas de IA disponibles, definitivamente deberías echarle un vistazo. Solo ten en cuenta que el motor de búsqueda no reemplazará a Google, y el chatbot de IA no reemplazará a ChatGPT, al menos no todavía.

Editado por Josh Quittner y Sebastian Sinclair.