En Resumen

- Cerca de 8.000 cuentas en X usan fotos de perfil generadas por IA para amplificar mensajes políticos y esquemas de criptomonedas.

- Un 25,84% de las cuentas con fotos sintéticas sigue un patrón, teniendo exactamente 106 seguidores, lo que indica posible coordinación.

- Las cuentas con imágenes falsas tienden a evitar la interacción directa y se enfocan en temas polémicos, especialmente en inglés.

Las fotos de perfil generadas por IA se están convirtiendo en una herramienta significativa para la manipulación coordinada en X, con investigadores de Alemania identificando cerca de 8.000 cuentas que utilizan rostros sintéticos enfocados principalmente en amplificar mensajes políticos y esquemas de criptomonedas.

"Los avances recientes en el campo de la inteligencia artificial (IA) generativa han difuminado las líneas entre el contenido auténtico y el generado por máquinas, haciendo casi imposible que los humanos distingan entre dichos medios", señala el estudio.

La investigación, realizada por equipos de la Universidad Ruhr de Bochum, el Instituto GESIS Leibniz y el Centro CISPA Helmholtz, encontró que más de la mitad de estas cuentas fueron creadas en 2023, frecuentemente en eventos sospechosos de creación masiva.

"Una porción significativa de las cuentas fue creada en masa poco antes de nuestra recolección de datos, lo cual es un patrón común para cuentas creadas para la amplificación de mensajes, campañas de desinformación o actividades disruptivas similares", explican los investigadores.

Este hallazgo adquiere contexto adicional a partir de un análisis reciente de la plataforma realizado por el Centro para Contrarrestar el Odio Digital que muestra que las publicaciones políticas del propietario de X, Elon Musk, favoreciendo a Donald Trump recibieron 17.100 millones de vistas—más del doble que todos los anuncios de campaña política estadounidenses combinados durante el mismo período.

"Al menos 87 de las publicaciones de Musk este año han promovido afirmaciones sobre las elecciones estadounidenses que los verificadores de datos han calificado como falsas o engañosas, acumulando 2 mil millones de vistas. Ninguna de estas publicaciones incluyó una Nota Comunitaria, el nombre que X da a las verificaciones de datos generadas por usuarios", dice el informe del CCDH.

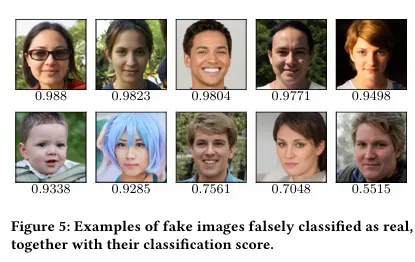

El uso de IA generativa—ya sea para generar imágenes o texto falsos—era fácil de detectar ya que las cuentas con rostros sintéticos exhibían patrones distintivos que las separaban de los usuarios legítimos. "Las cuentas con imágenes falsas tienen menos seguidores (media: 393.35, mediana: 60) comparadas con las cuentas con imágenes reales (media: 5,086.38, mediana: 165)." El estudio también encontró que las cuentas falsas tienden a interactuar menos con su ecosistema de seguidores y en su lugar publican mensajes sin responder o interactuar con otras cuentas.

El estudio también enfatizó patrones específicos que sugieren actividad coordinada: "Notamos que 1.996 cuentas con imágenes falsas (25,84%) tienen exactamente 106 seguidores. Nuestro análisis de contenido revela que estas cuentas pertenecen a un gran grupo de cuentas falsas involucradas en comportamiento inauténtico coordinado."

El equipo de investigación logró una precisión notable en sus métodos de detección, reportando casi 100% de certeza en sus hallazgos.

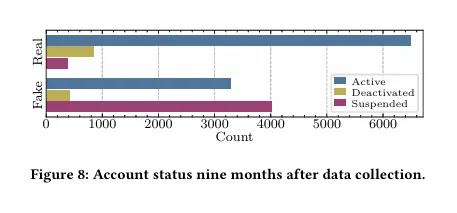

Los investigadores también señalaron que muchas de las cuentas no duran mucho tiempo, con más de la mitad siendo suspendidas en menos de un año.

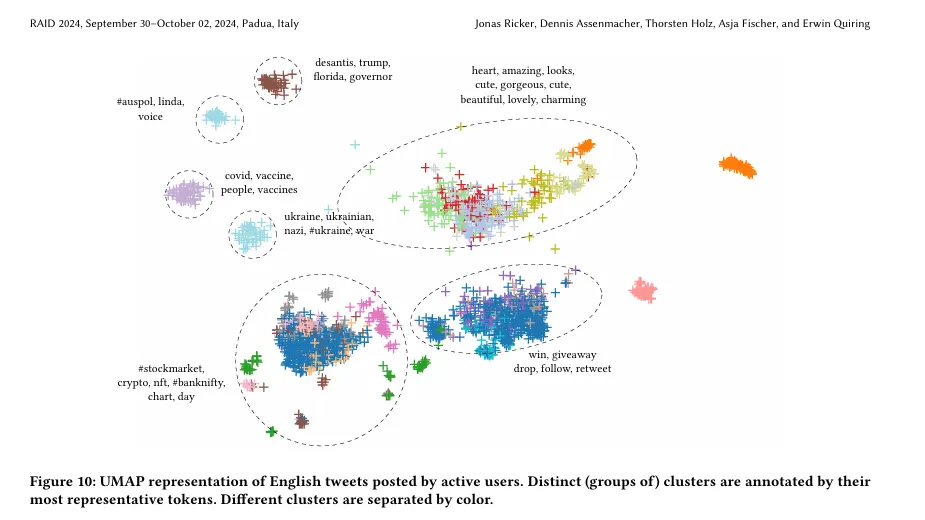

El análisis de contenido también reveló patrones de publicación cuidadosamente orquestados en múltiples idiomas. El estudio identificó "grandes redes de cuentas con imágenes falsas que probablemente fueron creadas automáticamente y que participaron en ataques de spam a gran escala." Las cuentas en inglés se enfocaron fuertemente en temas controversiales, y los investigadores encontraron que las cuentas prefieren abordar temas como la guerra en Ucrania, las elecciones estadounidenses y los debates sobre COVID-19 y políticas de vacunación.

Fuera de la política, muchas de estas cuentas también promovieron estafas de criptomonedas y contenido relacionado con el sexo.

De cara al futuro, los investigadores planean expandir las capacidades de detección para identificar imágenes de IA generadas con otros modelos basados en diferentes tecnologías—como modelos de Difusión en lugar de Redes Generativas Adversarias (GANs). También quieren mejorar su metodología para encontrar más formas de identificar lo que categorizan como "comportamiento inauténtico coordinado a través de plataformas sociales."

Editado por Josh Quittner y Sebastian Sinclair