En Resumen

- Esta ha sido una buena semana para la inteligencia artificial de código abierto.

- Meta anunció una actualización de su modelo de lenguaje grande, Llama 3.2, que puede adaptarse a teléfonos inteligentes sin perder calidad.

- Llama 3.2 viene en cuatro variantes, incluyendo modelos de 11B y 90B parámetros, y dos modelos más pequeños de 1B y 3B parámetros.

Esta ha sido una buena semana para la inteligencia artificial de código abierto.

El miércoles, Meta anunció una actualización de su modelo de lenguaje grande de última generación, Llama 3.2, y no solo habla, sino que también tiene una gran visión.

Más intrigante aún, algunas versiones pueden adaptarse a tu teléfono inteligente sin perder calidad, lo que significa que potencialmente podrías tener interacciones locales de inteligencia artificial privada, aplicaciones y personalizaciones sin enviar tus datos a servidores de terceros.

Presentado el miércoles durante Meta Connect, Llama 3.2 viene en cuatro variantes, cada una con un enfoque diferente. Los contendientes de peso pesado, 11B y 90B, modelos con parámetros, demuestran su potencia con capacidades de procesamiento de texto e imágenes.

Pueden abordar tareas complejas como analizar gráficos, describir imágenes e incluso identificar objetos en fotos basándose en descripciones en lenguaje natural.

Llama 3.2 llegó la misma semana que Molmo del Instituto Allen, que afirma ser el mejor LLM de visión multimodal de código abierto en pruebas sintéticas, con un rendimiento en nuestras pruebas a la par con GPT-4o, Claude 3.5 Sonnet y Reka Core.

La compañía de Zuckerberg también presentó dos nuevos campeones livianos: un par de modelos de parámetros 1B y 3B diseñados para eficiencia, velocidad y tareas limitadas, pero repetitivas que no requieren demasiada computación.

Estos modelos pequeños son maestros multilingües del texto con habilidades para "llamar a herramientas", lo que significa que pueden integrarse mejor con herramientas de programación. A pesar de su tamaño diminuto, presumen de una impresionante ventana de contexto de 128K tokens, igual que GPT4o y otros modelos potentes, lo que los hace ideales para resúmenes en dispositivos, seguimiento de instrucciones y tareas de reescritura.

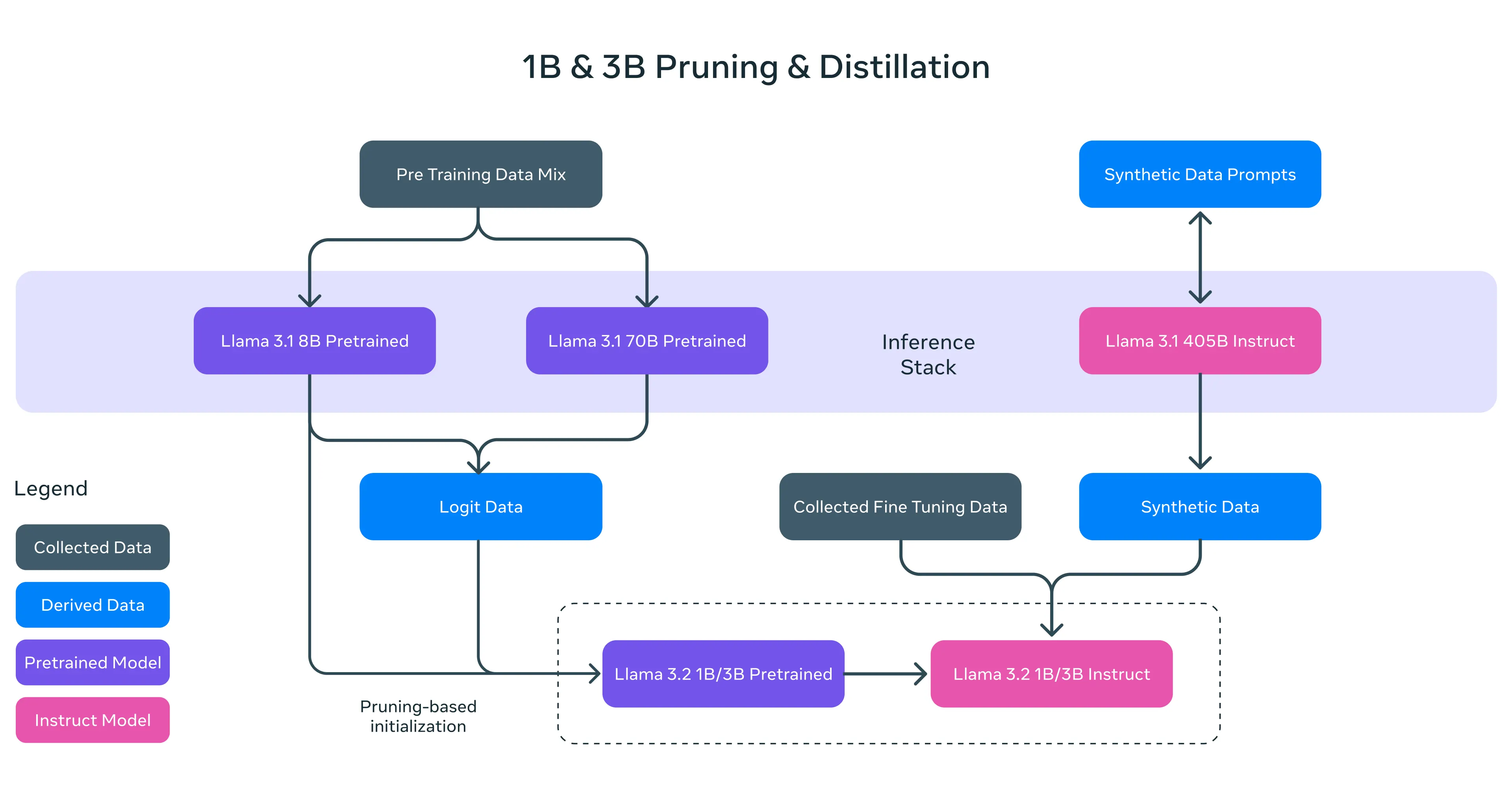

El equipo de ingeniería de Meta realizó algunas acrobacias digitales serias para lograr esto. Primero, utilizaron "structured pruning" para recortar los datos innecesarios de modelos más grandes, luego emplearon "knowledge distillation"—transferir conocimiento de modelos grandes a modelos más pequeños—para incluir inteligencia adicional.

El resultado fue un conjunto de modelos compactos que superaron a competidores rivales en su categoría de peso, como Gemma 2 2.6B de Google y el Phi-2 2.7B de Microsoft en varios benchmarks.

Meta también está trabajando arduamente para potenciar la IA en dispositivos. Han forjado alianzas con titanes del hardware como Qualcomm, MediaTek y Arm para asegurar que Llama 3.2 funcione correctamente con chips móviles desde el primer día. Los gigantes de la computación en la nube tampoco se quedan atrás—AWS, Google Cloud, Microsoft Azure y una serie de otros ofrecen acceso instantáneo a los nuevos modelos en sus plataformas.

Bajo el capó, las capacidades de visión de Llama 3.2 provienen de ajustes arquitectónicos inteligentes. Los ingenieros de Meta incorporaron pesos de adaptador en el modelo de lenguaje existente, creando un puente entre los codificadores de imagen pre-entrenados y el núcleo de procesamiento de texto.

En otras palabras, las capacidades de visión del modelo no se dan a expensas de su competencia en el procesamiento de texto, por lo que los usuarios pueden esperar resultados de texto similares o mejores en comparación con Llama 3.1.

El lanzamiento de Llama 3.2 es de código abierto, al menos según los estándares de Meta. Meta está poniendo los modelos disponibles para su descarga en Llama.com y Hugging Face, así como a través de su extenso ecosistema de socios.

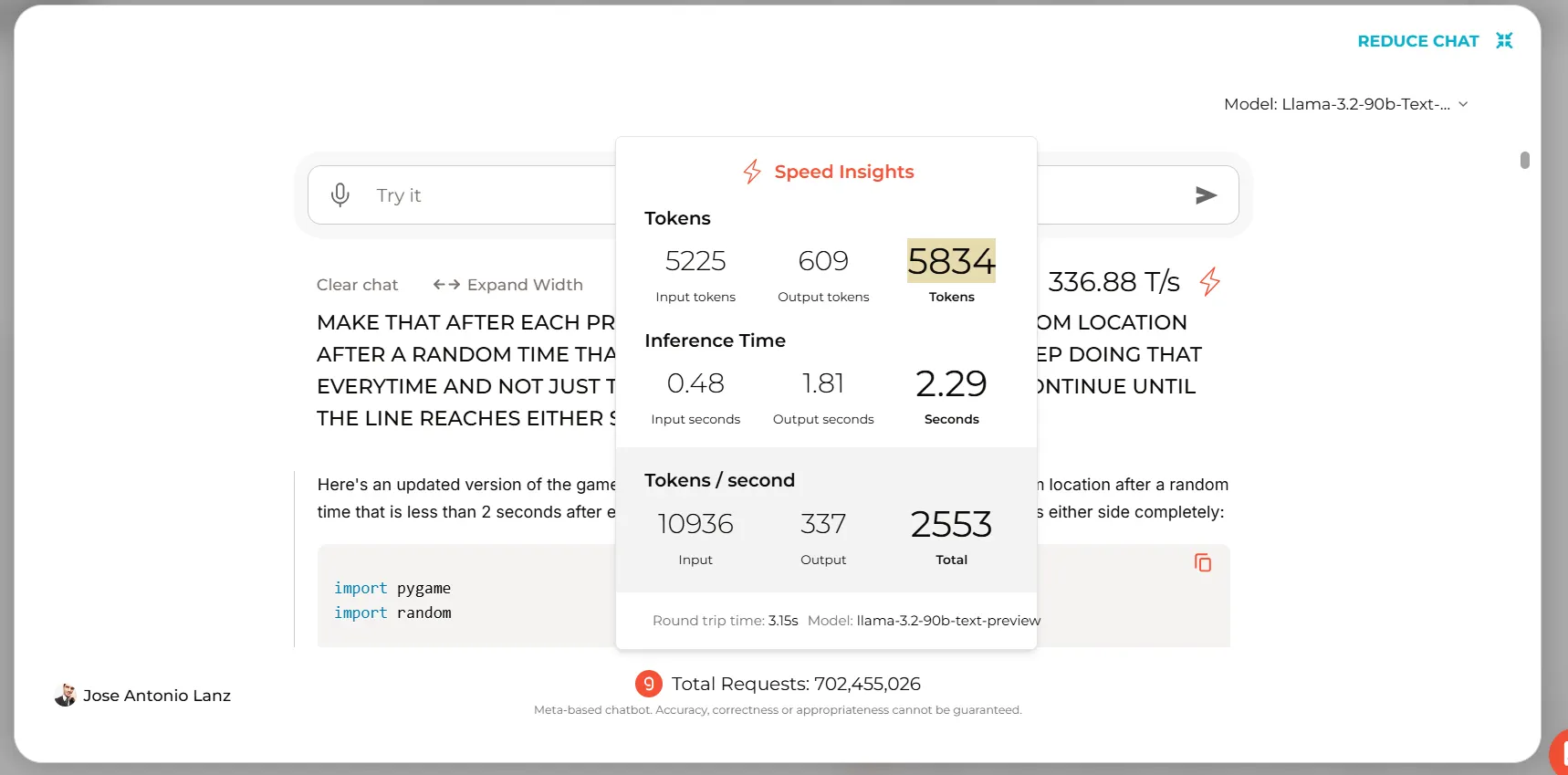

Quienes estén interesados en ejecutarlo en la nube pueden utilizar su propio Colab Notebook de Google o utilizar Groq para interacciones basadas en texto, generando casi 5000 tokens en menos de 3 segundos.

Probando Llama

Pusimos a prueba a Llama 3.2, evaluando rápidamente sus capacidades en diversas tareas.

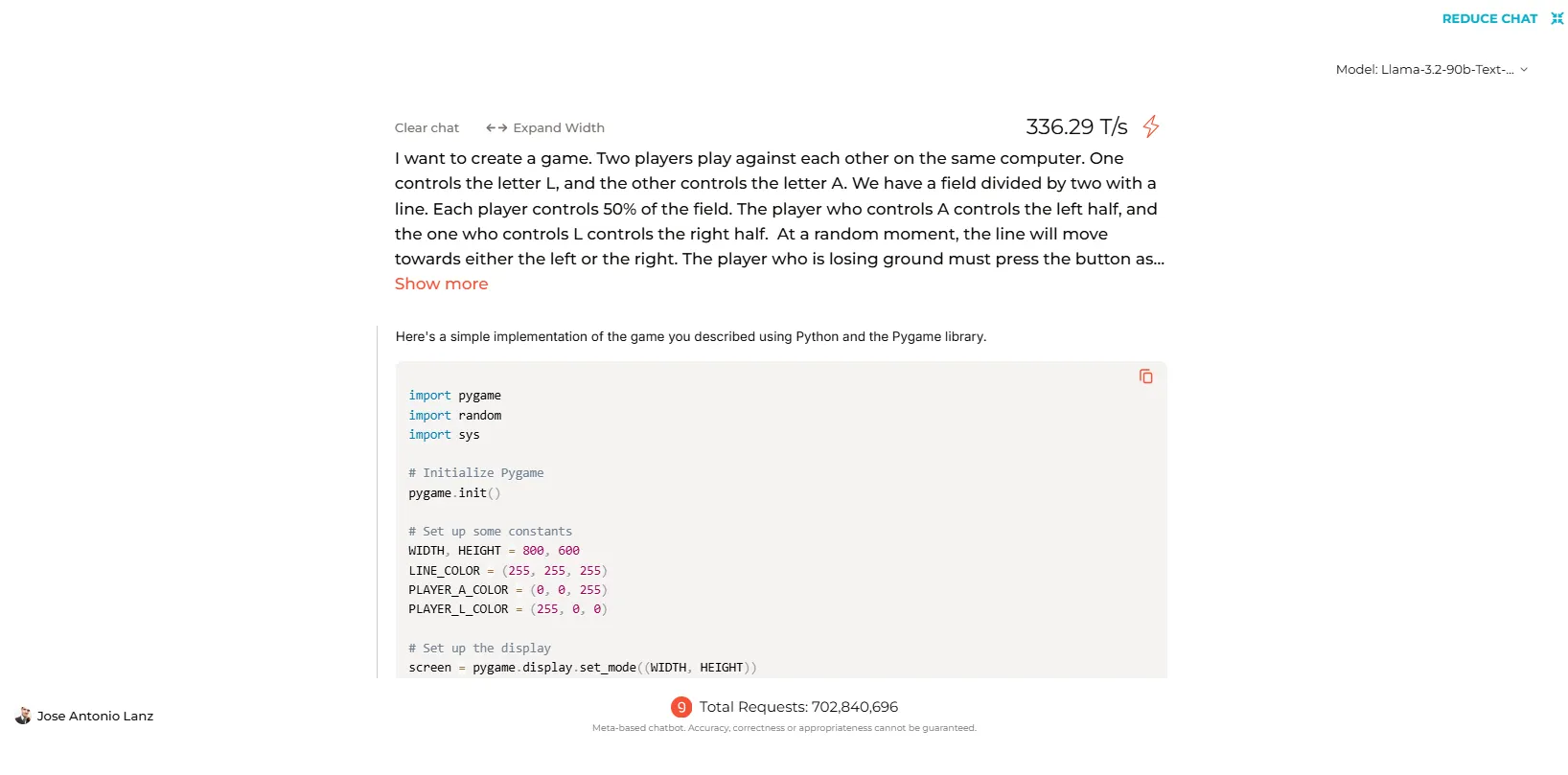

En interacciones basadas en texto, el modelo se desempeña al nivel de sus predecesores. Sin embargo, sus habilidades de codificación arrojaron resultados mixtos.

Cuando se probó en la plataforma de Groq, Llama 3.2 generó con éxito código para juegos populares y programas simples. Sin embargo, el modelo más pequeño de 70B tuvo dificultades al intentar crear código funcional para un juego personalizado que diseñamos. En cambio, el modelo más potente de 90B, fue mucho más eficiente y generó un juego funcional en el primer intento.

Puedes ver el código completo generado por Llama-3.2 y todos los otros modelos que probamos haciendo clic en este enlace.

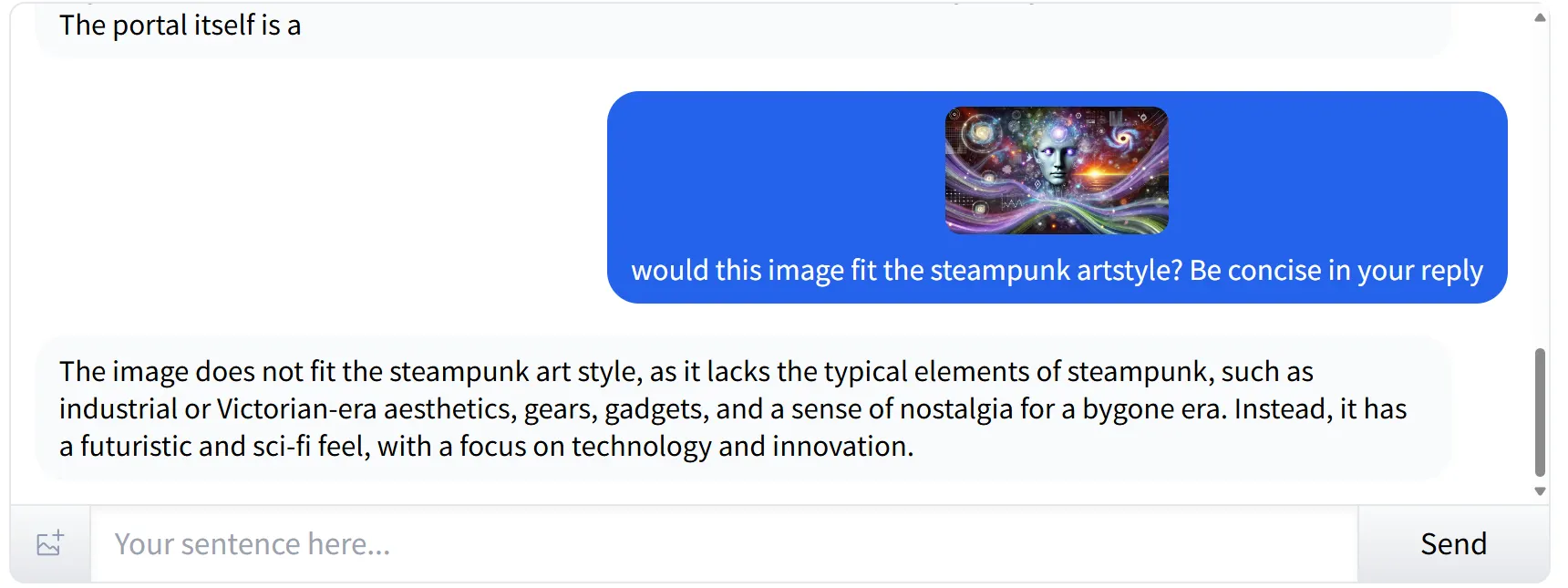

Identificación de estilos y elementos subjetivos en imágenes

Llama 3.2 destaca en la identificación de elementos subjetivos en imágenes. Cuando se le presentó una imagen de estilo futurista y cyberpunk y se le preguntó si encajaba en la estética steampunk, el modelo identificó con precisión el estilo y sus elementos. Proporcionó una explicación satisfactoria, señalando que la imagen no se alineaba con el steampunk debido a la ausencia de elementos clave asociados con ese género.

Análisis de Gráficos (y reconocimiento de imágenes SD)

El análisis de gráficos es otra fortaleza de Llama 3.2, aunque requiere imágenes de alta resolución para un rendimiento óptimo. Cuando ingresamos una captura de pantalla que contenía un gráfico, uno que otros modelos como Molmo o Reka lograron interpretar, mientras las capacidades visuales de Llama fallaron. El modelo se disculpó, explicando que no podía leer correctamente las letras debido a la calidad de la imagen.

Identificación de Texto en Imágenes

Mientras Llama 3.2 tuvo dificultades con el texto pequeño en nuestro gráfico, funcionó perfectamente al leer texto en imágenes más grandes. Le mostramos una diapositiva de presentación que presentaba a una persona, y el modelo entendió con éxito el contexto, distinguiendo entre el nombre y el cargo sin errores.

Veredicto

En general, Llama 3.2 es una gran mejora respecto a su generación anterior y es una excelente adición a la industria de la inteligencia artificial de código abierto. Sus fortalezas están en la interpretación de imágenes y el reconocimiento de texto grande, con algunas áreas para posibles mejoras, especialmente en el procesamiento de imágenes de baja calidad y en la realización de tareas de codificación complejas y personalizadas.

La promesa de compatibilidad en dispositivos es también beneficiosa para el futuro de las tareas de inteligencia artificial privadas y locales, y representa un gran contrapeso a ofertas cerradas como Gemini Nano y los modelos propietarios de Apple.

Editado por Josh Quittner y Sebastian Sinclair