En Resumen

- Flux, un generador de imágenes de código abierto, requería inicialmente una GPU potente con más de 24GB de VRAM para funcionar.

- La comunidad de inteligencia artificial logró reducir el tamaño de Flux a una dimensión más manejable sin sacrificar su inteligencia artística.

- Se lanzaron modelos cuantificados de 4 bits, utilizando cuantización "Normal Point" (NP), que ofrecen un equilibrio perfecto entre calidad y velocidad, permitiendo que Flux funcione en GPUs de gama baja.

Cuando Flux irrumpió en el ecosistema hace unos días, se ganó rápidamente la reputación de ser la joya de la corona de los generadores de imágenes de código abierto. Igualó la destreza estética de Midjourney mientras la superaba con creces en comprensión rápida y generación de texto. ¿El detalle? Necesitabas una GPU potente con más de 24GB de VRAM (o incluso más) solo para hacerlo funcionar. Eso es más potencia que la mayoría de las computadoras para juegos, y mucho más que tu portátil de trabajo promedio.

Pero la comunidad de inteligencia artificial, nunca retrocede ante un desafío, se subió las mangas colectivamente y se puso a trabajar. A través de la magia de la cuantificación, un término elegante para comprimir los datos del modelo, lograron reducir el tamaño de Flux a una dimensión más manejable sin sacrificar demasiado de su inteligencia artística.

Vamos a analizarlo: El modelo original de Flux utilizaba precisión completa de 32 bits (FP32), lo cual es como conducir un coche de Fórmula 1 para ir al supermercado, lo cual es excesivo para la mayoría de los mortales. La primera ronda de optimizaciones nos trajo versiones FP16 y FP8, cada una intercambiando un poco de precisión por un gran impulso en eficiencia. La versión FP8 ya era excelente, permitiendo que personas con GPUs de 6GB (piensa en RTX 2060) se unieran a la fiesta.

The Flux Schnell (FP8) runs smoothly on a 6GB RTX 2060 after disabling the shared memory fallback for ComfyUI.

Prompt executed in 107.47 seconds —4 steps, no OOM.

16.86s/it

512x768 Image.

1024x1024 takes considerably longer.

I would recommend a High-res fix or another upscaling… pic.twitter.com/LKe1rWzyQV— jaldps (@jaldpsd) August 5, 2024

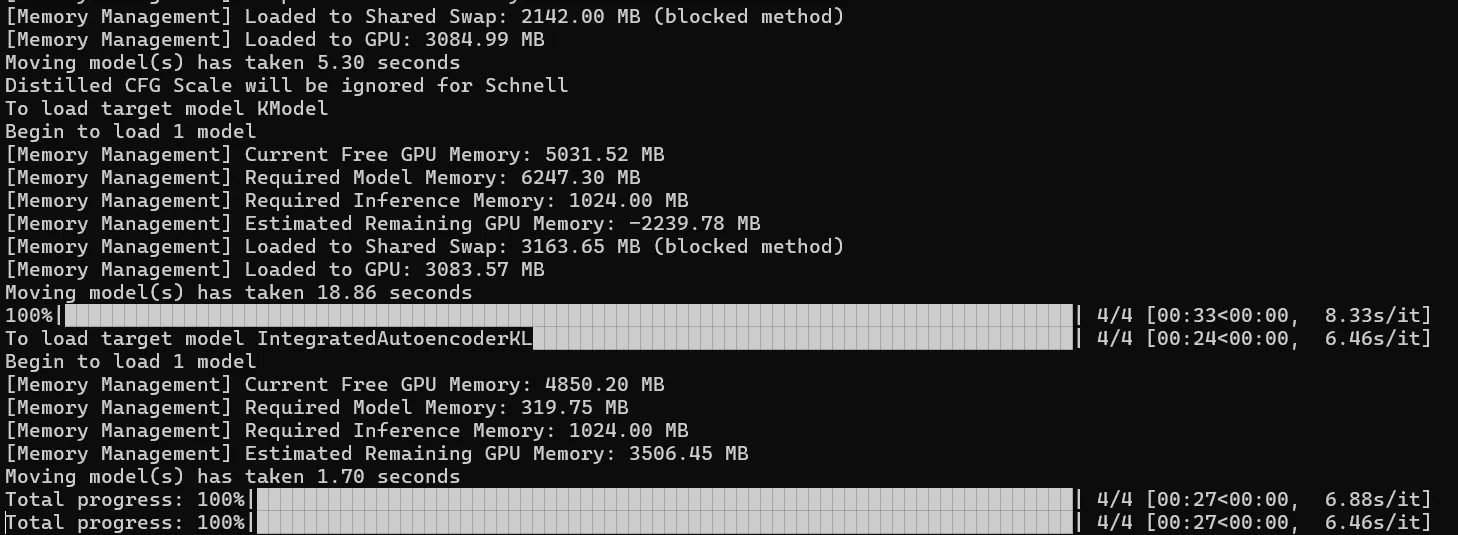

Para hacer esto, necesitas desactivar la Devolución de Memoria del Sistema para Stable Diffusion, para que tu GPU pueda transferir parte de su trabajo desde su VRAM interno a la RAM de tu sistema. Esto evita el infame error de OOM (sin memoria), aunque a costa de que funcione considerablemente más lento. Para desactivar esta opción, sigue este tutorial de Nvidia.

Pero agárrate fuerte, porque se pone aún mejor.

Los verdaderos MVPs (Jugadores Más Valiosos) del mundo de la IA han llevado los límites aún más lejos, lanzando modelos cuantificados de 4 bits. Estos chicos malos utilizan algo llamado cuantización "Normal Point" (NP), que ofrece un equilibrio perfecto entre calidad y velocidad que hará que tu PC con un motor viejo de Escarabajo se sienta como que le instalaras un motor Turbo de New Bettle (sin gastar un centavo). La cuantización NP no degrada la calidad tanto como la cuantización FP, por lo que, en términos generales, ejecutar este modelo brinda excelentes resultados, a altas velocidades, requiriendo pocos recursos.

Es casi demasiado bueno para ser verdad, pero lo es.

Cómo ejecutar Flux en GPUs de gama baja

¿Cómo ejecutas realmente esta versión simplificada de Flux? Primero, necesitarás obtener una interfaz como SwarmUI, ComfyUI o Forge. Nos encanta ComfyUI por su versatilidad, pero en nuestras pruebas, Forge ofreció un aumento de velocidad del 10-20% sobre los demás, así que eso es con lo que estamos trabajando aquí.

Dirígete al repositorio de Forge en GitHub (https://github.com/lllyasviel/stable-diffusion-webui-forge) y descarga el paquete de instalación con un clic. Es de código abierto y validado por la comunidad, así que aquí no hay nada sospechoso.

Para los propios modelos NP4 Flux, Civit AI es tu tienda única. Tienes dos opciones para elegir: Schnell (para velocidad) y Dex (para calidad). Ambos se pueden descargar desde esta página.

Una vez que hayas descargado todo, es hora de instalarlo:

- Descomprime el archivo de Forge y abre la carpeta de Forge.

- Ejecuta update.bat para obtener todas las dependencias.

- Arranca run.bat para completar la configuración.

Ahora, coloca esos relucientes modelos de Flux en la carpeta webuimodelsStable-diffusion dentro de tu instalación de Forge. Actualiza la interfaz web de Forge (o reinicia si te sientes de la vieja escuela), ¡y listo! Estás listo para empezar.

Consejo profesional: Para exprimir al máximo el rendimiento de tu equipo renovado, reduce la resolución. En lugar de optar por resoluciones completas de SDXL (1024x1024), prueba con tamaños más modestos como el de SD1.5 (768x768, 512x768 y similares). Siempre puedes aumentar la resolución más tarde y usar Adetailer para obtener esos detalles nítidos.

Hablemos de números: En una humilde RTX 2060 con 6GB de VRAM, Flux Schnell en modo NP4 puede generar una imagen de 512x768 en unos 30 segundos, en comparación con los 107 segundos requeridos por la versión FP8. ¿Quieres ir a lo grande? Te llevará unos cinco minutos aumentar esa imagen a 1536x1024 con una corrección de alta resolución.

¿Quieres ir más lejos sin explotar tu GPU? Una mejor opción es comenzar con Flux Schnell en resoluciones SD1.5, luego enviar esa creación a través de img2img. Amplía usando un modelo de Stable Diffusion estándar (SD1.5 o SDXL) con baja fuerza de reducción de ruido. Todo el proceso dura alrededor de 50 segundos, compitiendo con la producción de MidJourney en un día lento. Obtendrás resultados impresionantes a gran escala sin derretir tu tarjeta gráfica.

¿Lo más sorprendente? Algunos locos supuestamente han logrado que Flux Schnell NP4 funcione en una GTX 1060 con 3GB de VRAM, con Flux Dev tomando 7.90s por iteración. Estamos hablando de una GPU que prácticamente está jadeando con soporte vital, y aquí está generando arte de IA de vanguardia. No está nada mal para un hardware que prácticamente es elegible para una pensión.