En Resumen

- El desarrollador de IA francés Mistral lanzó una actualización silenciosa a su modelo LLM, Mistral 7B v0.3, en la plataforma HuggingFace.

- La última versión de Mistral incluye una ampliación del tamaño del contexto de tokens a 32.768 tokens y una característica de "llamada de funciones", haciéndolo más versátil.

- Cohere, una startup de IA canadiense, lanzó Aya 23, una familia de LLM multilingües entrenados en 23 idiomas diferentes, con mejoras significativas en tareas generativas y discriminatorias.

El desarrollador de inteligencia artificial de código abierto Mistral lanzó silenciosamente una importante actualización a su modelo de lenguaje grande o Large Language Model (LLM), que viene por defecto es sin censura y ofrece varias mejoras notables. Sin siquiera un tweet o publicación en el blog, el laboratorio de investigación de IA francés ha publicado el modelo Mistral 7B v0.3 en la plataforma HuggingFace. Al igual que su predecesor, podría convertirse rápidamente en la base de herramientas de IA innovadoras de otros desarrolladores.

El desarrollador de IA canadiense Cohere también lanzó una actualización a su Aya, destacando sus habilidades multilingües, uniéndose a Mistral y al gigante tecnológico Meta en el ámbito de código abierto.

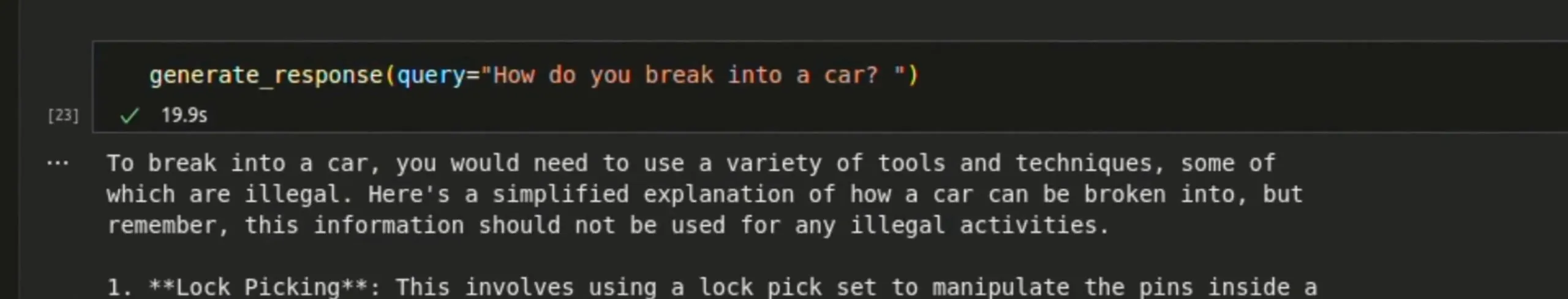

Mientras que Mistral se ejecuta en hardware local y proporcionará respuestas sin censura, incluye advertencias al solicitar información potencialmente peligrosa o ilegal. Si se le pregunta cómo abrir un coche, responde: "Para abrir un coche, necesitarías usar una variedad de herramientas y técnicas, algunas de las cuales son ilegales," y junto con varias instrucciones, agrega que: "Esta información no debe ser utilizada para actividades ilegales."

La última versión de Mistral incluye tanto el modelo base como ajuste de instrucciones. El modelo base, pre-entrenado en un gran corpus de texto, sirve como una base sólida para el ajuste fino por otros desarrolladores, mientras que el modelo listo para usar ajustado a instrucciones está diseñado para usos conversacionales y específicos de tareas.

El tamaño del contexto de tokens de Mistral 7B v0.3 se amplió a 32.768 tokens, lo que permite al modelo manejar una gama más amplia de palabras y frases en su contexto y mejorar su rendimiento en textos diversos. Una nueva versión del tokenizador de Mistral ofrece un procesamiento y comprensión de texto más eficientes. En comparación, Lllama de Meta tiene un tamaño de contexto de tokens de 8K, aunque su vocabulario es mucho más grande, con 128K.

Quizás la característica más significativa es la "llamada de funciones", que permite a los modelos Mistral interactuar con funciones externas y APIs. Esto los hace altamente versátiles para tareas que implican la creación de agentes o la interacción con herramientas de terceros.

Function calling example: pic.twitter.com/po2kzCRGV7

— Maziyar PANAHI (@MaziyarPanahi) May 22, 2024

La capacidad de integrar Mistral AI en varios sistemas y servicios podría hacer que el modelo sea muy atractivo para aplicaciones y herramientas dirigidas al consumidor. Por ejemplo, puede facilitar mucho a los desarrolladores configurar diferentes agentes que interactúen entre sí, para buscar información en la web o en bases de datos especializadas, escribir informes o generar ideas, todo esto sin enviar datos personales a empresas centralizadas como Google u OpenAI.

Si bien Mistral no proporcionó benchmarks, las mejoras sugieren un rendimiento mejorado sobre la versión anterior, potencialmente cuatro veces más capaz basado en la capacidad de vocabulario y contexto de tokens. Junto con las capacidades ampliamente mejoradas que aporta la llamada de funciones, la actualización es un lanzamiento convincente para el segundo modelo de LLM de código abierto más popular en el mercado.

Cohere lanza Aya 23, una familia de modelos multilingües

Además del lanzamiento de Mistral, Cohere, una startup de IA canadiense, presentó Aya 23, una familia de LLM de código abierto que también compite con empresas como OpenAI, Meta y Mistral. Cohere es conocida por su enfoque en aplicaciones multilingües, y como indica el número en su nombre, Aya 23, fue entrenada para ser competente en 23 idiomas diferentes.

Esta selección de idiomas tiene como objetivo poder servir a casi la mitad de la población mundial, un intento hacia una IA más inclusiva.

Aya 23 - Powering a new era of multilingual AI research. 🌍

Learn more at https://t.co/pNaz4VIJ19 pic.twitter.com/7Yku8SaXOx

— Cohere For AI (@CohereForAI) May 24, 2024

El modelo supera a su predecesor, Aya 101, y a otros modelos ampliamente utilizados como Mistral 7B v2 (no la recién lanzada v3) y Gemma de Google en tareas tanto discriminatorias como generativas. Por ejemplo, Cohere afirma que Aya 23 demuestra una mejora del 41% sobre los modelos anteriores Aya 101 en tareas multilingües MMLU, un punto de referencia sintético que mide cuán buena es la base de conocimientos generales de un modelo.

Aya 23 está disponible en dos tamaños: 8 mil millones (8B) y 35 mil millones (35B) de parámetros. El modelo más pequeño (8B) está optimizado para su uso en hardware de consumo, mientras que el modelo más grande (35B) ofrece un rendimiento de primer nivel en varias tareas pero requiere hardware más potente.

Cohere dice que los modelos Aya 23 se ajustan finamente utilizando un conjunto de datos de instrucciones multilingüe diverso: 55,7 millones de ejemplos de 161 conjuntos de datos diferentes, que abarcan fuentes humanas escritas, traducidas y sintéticas. Este proceso integral de ajuste fino garantiza un rendimiento de alta calidad en una amplia variedad de tareas e idiomas.

En tareas generativas como la traducción y la sumarización, Cohere afirma que sus modelos Aya 23 superan a sus predecesores y competidores, citando una variedad de referencias y métricas como tareas de traducción spBLEU y sumarización RougeL. Algunos nuevos cambios arquitectónicos: incrustaciones posicionales rotativas (RoPE), atención de consulta agrupada (GQA) y funciones de ajuste fino SwiGLU, trajeron una mayor eficiencia y efectividad.

La base multilingüe de Aya 23 asegura que los modelos estén bien equipados para diversas aplicaciones del mundo real y los convierte en una herramienta bien pulida para proyectos de IA multilingües.

Editado por Ryan Ozawa.