En Resumen

- Vitalik Buterin expresó su preocupación sobre la IA superinteligente, calificándola como "muy arriesgada" y abogó por un enfoque más cauteloso en su desarrollo.

- Buterin enfatizó la importancia de un ecosistema de IA diverso y abierto para evitar que el valor de la IA se concentre en unas pocas personas y prevenir riesgos asociados con la megalomanía corporativa y los militares.

- Sus comentarios surgen en medio de debates sobre la alineación de la IA y renuncias en el equipo de superalineación de OpenAI, reflejando preocupaciones sobre la dirección del desarrollo de la IA en las principales empresas tecnológicas.

Vitalik Buterin, el cerebro detrás de Ethereum, llamó a un enfoque más cauteloso hacia la investigación de IA, calificando la actual fiebre de avance como "muy arriesgada". En respuesta a una crítica de OpenAI y su liderazgo por Ryan Selkis (CEO de la firma de inteligencia cripto Messari), el creador de la segunda blockchain más influyente del mundo, expuso sus puntos de vista sobre la alineación de la IA—los principios fundamentales que deberían guiar el desarrollo.

"La IA superinteligente es muy arriesgada, y no deberíamos precipitarnos con ella, y deberíamos oponernos a las personas que lo intenten", afirmó Buterin. "No a las granjas de servidores de $7 billones, por favor".

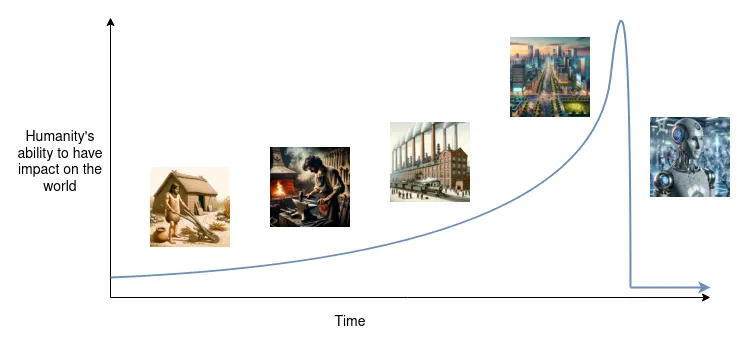

La IA superinteligente es una forma teórica de inteligencia artificial que supera la inteligencia humana en prácticamente todos los ámbitos. Mientras que muchos ven a la inteligencia artificial general (AGI) como la realización final del pleno potencial de la tecnología emergente, los modelos superinteligentes serían lo que viene a continuación. Si bien los sistemas de IA de vanguardia de hoy en día aún no han alcanzado estos umbrales, los avances en el aprendizaje automático, las redes neuronales y otras tecnologías relacionadas con la IA continúan progresando, y la gente está emocionada y preocupada a su vez.

My current views:

1. Superintelligent AI is very risky and we should not rush into it, and we should push against people who try. No $7T server farms plz.

2. A strong ecosystem of open models running on consumer hardware are an important hedge to protect against a future where…— vitalik.eth (@VitalikButerin) May 21, 2024

Después de que Messari tuiteara que "la AGI es demasiado importante como para deificar a otro narcisista elocuente", Buterin enfatizó la importancia de un ecosistema de IA diverso para evitar un mundo donde el inmenso valor de la IA sea propiedad y esté controlado por muy pocas personas.

“Un ecosistema sólido de modelos abiertos que se ejecutan en hardware de consumo [es] una protección importante contra un futuro en el que el valor capturado por la IA esté hiperconcentrado y la mayoría del pensamiento humano sea leído y mediado por unos pocos servidores centrales controlados por unas pocas personas”, dijo. “Tales modelos también tienen mucho menos riesgo de fatalidad que tanto la megalomanía corporativa como los militares."

El creador de Ethereum ha estado siguiendo de cerca la escena de la IA, elogiando recientemente el modelo LLM de código abierto Llama3. También sugirió que el modelo LLM multimodal GPT-4o de OpenAI podría haber pasado la prueba de Turing después de que un estudio argumentara que las respuestas humanas eran indistinguibles de las generadas por la IA.

Además, Buterin abordó la categorización de los modelos de IA en grupos "pequeños" y "grandes", centrándose en la regulación de los modelos "grandes" como una prioridad razonable. Sin embargo, expresó su preocupación de que muchas propuestas actuales podrían resultar en que todo sea clasificado como "grande" con el tiempo.

Pero las observaciones de Buterin llegan en medio de acalorados debates en torno a la alineación de la IA y las renuncias de figuras clave en el equipo de investigación de superalineación de OpenAI. Ilya Sutskever y Jan Leike han dejado la empresa, con Leike acusando al CEO de OpenAI, Sam Altman, de priorizar "productos llamativos" sobre el desarrollo responsable de la IA.

Se reveló por separado que OpenAI tiene acuerdos de confidencialidad estrictos que impiden a sus empleados hablar sobre la empresa después de su partida.

Los debates de alto nivel y a largo plazo sobre la superinteligencia se están volviendo más urgentes, con expertos expresando preocupación mientras hacen recomendaciones muy variadas.

Paul Christiano, quien anteriormente lideró el equipo de alineación de modelos de lenguaje en OpenAI, ha establecido el Centro de Investigación de Alineación, una organización sin fines de lucro dedicada a alinear los sistemas de inteligencia artificial y aprendizaje automático con los "intereses humanos". Según lo informado por Decrypt, Christiano sugirió que podría haber una "probabilidad del 50/50 de una catástrofe poco después de que tengamos sistemas al nivel humano".

Por otro lado, Yann LeCun, investigador jefe de Meta, cree que un escenario catastrófico de este tipo es muy improbable. En abril de 2023, afirmó en un tuit que el escenario de "despegue rápido" es "absolutamente imposible". LeCun afirmó que los desarrollos de IA a corto plazo influyen significativamente en la forma en que evoluciona la IA, dando forma a su trayectoria a largo plazo.

Pero Buterin, en cambio, se considera a sí mismo como un centrista. En un ensayo de 2023 —que ratificó ayer— reconoció que "parece muy difícil tener un mundo dominado por una superinteligencia amigable en el que los humanos sean algo más que mascotas", pero también argumentó que "a menudo, realmente sucede que la versión N de la tecnología de nuestra civilización causa un problema, y la versión N+1 lo soluciona. Sin embargo, esto no sucede automáticamente y requiere un esfuerzo humano intencional". En otras palabras, si la superinteligencia se convierte en un problema, es probable que los humanos encuentren una manera de lidiar con eso.

La salida de los investigadores de alineación más cautelosos de OpenAI y el cambio de enfoque de la empresa en las políticas de seguridad han suscitado preocupaciones más amplias y generalizadas sobre la falta de atención al desarrollo ético de la IA entre las principales startups de IA. De hecho, Google, Meta y Microsoft también han disuelto sus equipos encargados de garantizar que la IA se desarrolle de manera segura.

Editado por Ryan Ozawa.