En Resumen

- Una coalición de gigantes de la inteligencia artificial, incluidos Google, Meta y OpenAI, se comprometió a combatir el CSAM.

- Thorn, junto con All Tech is Human, reunió al grupo para abogar por el principio de "Seguridad por Diseño" en la IA generativa.

- La proliferación de AIG-CSAM plantea graves riesgos para la seguridad infantil, exacerbando los desafíos de las fuerzas del orden.

Para combatir la propagación de material de abuso sexual infantil (CSAM), una coalición de los principales desarrolladores de inteligencia artificial generativa, incluidos Google, Meta y OpenAI, se comprometió a aplicar medidas de protección en torno a la tecnología emergente.

El grupo fue reunido por dos organizaciones sin ánimo de lucro: el grupo tecnológico infantil Thorn y All Tech is Human con sede en Nueva York. Anteriormente conocida como la Fundación DNA, Thorn fue lanzada en 2012 por los actores Demi Moore y Ashton Kutcher.

El compromiso colectivo fue anunciado el martes junto con un nuevo informe de Thorn que aboga por el principio de "Seguridad por Diseño" en el desarrollo de inteligencia artificial generativa que evitaría la creación de material de abuso sexual infantil (CSAM) en todo el ciclo de vida de un modelo de IA.

“Instamos a todas las empresas que desarrollan, implementan, mantienen y utilizan tecnologías y productos de IA generativa a comprometerse a adoptar estos principios de Seguridad por Diseño y demostrar su dedicación para prevenir la creación y difusión de CSAM, AIG-CSAM y otros actos de abuso y explotación sexual infantil,” dijo Thorn en un comunicado.

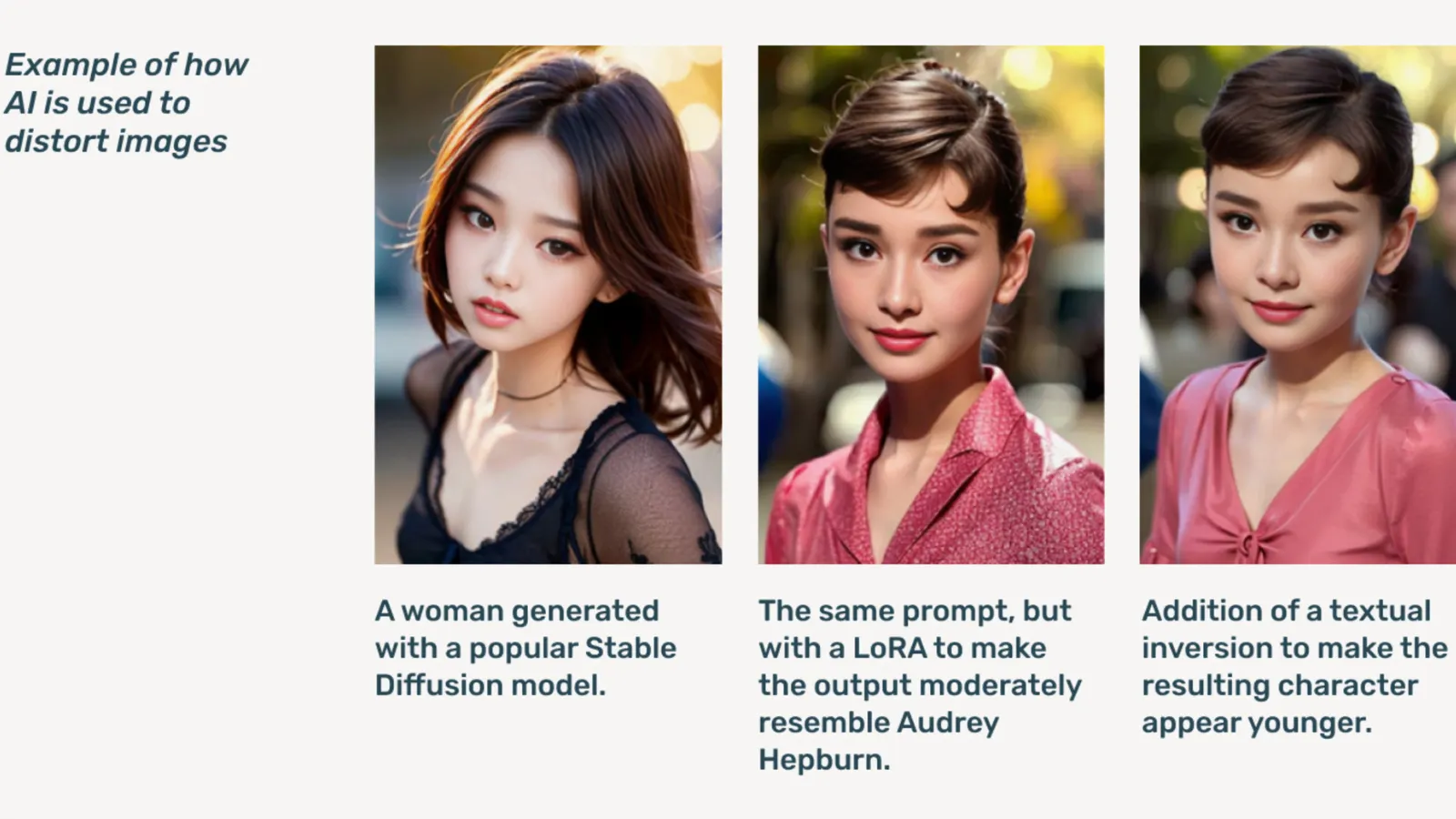

El AIG-CSAM es CSAM generado por IA, que el informe ilustra que puede ser relativamente fácil de crear.

Thorn desarrolla herramientas y recursos centrados en defender a los niños contra el abuso sexual y la explotación. En su informe de impacto de 2022, la organización informó que se encontraron más de 824.466 archivos que contenían material de abuso infantil. El año pasado, Thorn informó que se reportaron más de 104 millones de archivos de presunto CSAM solo en los EE. UU.

Ya siendo un problema en línea, la pornografía infantil deepfake se disparó después de que los modelos de IA generativa estuvieran disponibles públicamente, con modelos de IA independientes que no necesitan servicios en la nube circulando en foros de la dark web.

Thorn dijo que la IA generativa hace que crear volúmenes de contenido sea más fácil que nunca. Un solo depredador infantil podría potencialmente crear grandes volúmenes de material de abuso sexual infantil (CSAM), incluida la adaptación de imágenes y videos originales en nuevo contenido.

“Una afluencia de AIG-CSAM plantea riesgos significativos para un ecosistema de seguridad infantil ya sobrecargado, exacerbando los desafíos que enfrentan las fuerzas del orden para identificar y rescatar a las víctimas existentes de abuso, y escalando la nueva victimización de más niños”, señala Thorn.

El informe de Thorn describe una serie de principios que seguirían los desarrolladores de IA generativa para evitar que su tecnología se utilice para crear pornografía infantil, incluyendo la obtención responsable de conjuntos de datos de entrenamiento, la incorporación de bucles de retroalimentación y estrategias de pruebas de resistencia, el empleo de historial de contenido o "procedencia" con el mal uso adversarial en mente, y el alojamiento responsable de sus respectivos modelos de IA.

Otros actores que se suman al compromiso son Microsoft, Anthropic, Mistral AI, Amazon, Stability AI, Civit AI, y Metaphysic, cada uno publicando declaraciones separadas.

“Parte de nuestro ethos en Metaphysic es el desarrollo responsable en un mundo de IA, ¿verdad?, se trata de empoderar, pero también de responsabilidad”, dijo Alejandro López, director de marketing de Metaphysic, a Decrypt. “Rápidamente, reconocemos que para comenzar y desarrollar eso hay que proteger literalmente a los más vulnerables en nuestra sociedad, que son los niños, y desafortunadamente, el lado más oscuro de esta tecnología, se está utilizando para material de abuso sexual infantil en forma de pornografía falsa profunda.”

Lanzado en 2021, Metaphysic cobró relevancia el año pasado después de que se revelara que varias estrellas de Hollywood, incluidas Tom Hanks, Octavia Spencer y Anne Hathaway, estaban utilizando la tecnología Metaphysic Pro para digitalizar características de su semejanza en un intento de retener la propiedad sobre los rasgos necesarios para entrenar un modelo de IA.

OpenAI declinó hacer más comentarios sobre la iniciativa, en su lugar proporcionó a Decrypt una declaración pública de su líder de seguridad infantil, Chelsea Carlson.

“Nos preocupamos profundamente por la seguridad y el uso responsable de nuestras herramientas, por eso hemos incorporado fuertes medidas de protección y seguridad en ChatGPT y DALL-E”, dijo Carlson en un comunicado. “Estamos comprometidos a trabajar junto a Thorn, All Tech is Human y la amplia comunidad tecnológica para mantener los principios de Seguridad por Diseño y continuar nuestro trabajo en la mitigación de posibles daños a los niños.”

Decrypt se puso en contacto con otros miembros de la Coalición, pero no recibió una respuesta inmediata.

“En Meta, hemos pasado más de una década trabajando para mantener seguras a las personas en línea. En ese tiempo, hemos desarrollado numerosas herramientas y funciones para ayudar a prevenir y combatir posibles daños, y a medida que los depredadores se han adaptado para tratar de evadir nuestras protecciones, nosotros también hemos seguido adaptándonos”, dijo Meta en un comunicado.

“En todos nuestros productos, detectamos y eliminamos proactivamente material de CSAE a través de una combinación de tecnología de coincidencia de hash, clasificadores de inteligencia artificial y revisiones humanas,” escribió Susan Jasper, vicepresidenta de soluciones de confianza y seguridad de Google, en una publicación. “Nuestras políticas y protecciones están diseñadas para detectar todo tipo de CSAE, incluido el CSAM generado por IA. Cuando identificamos contenido explotador, lo eliminamos y tomamos la acción apropiada, que puede incluir reportarlo al NCMEC.”

En octubre, el grupo de vigilancia del Reino Unido, la Internet Watch Foundation, advirtió que el material de abuso infantil generado por IA podría ‘abrumar’ internet.

Editado por Ryan Ozawa.