En Resumen

- A pesar de las preocupaciones expresadas por líderes de la industria en una carta abierta, una encuesta a más de 2.700 expertos en IA reveló que solo el 5% considera una alta probabilidad de extinción humana debido a la IA.

- En contraste, el 61% de los estadounidenses ven la IA como una amenaza para la humanidad, según una encuesta de agosto de 2023.

- La IA avanza, con predicciones optimistas sobre hitos creativos en 10 años, pero la seguridad de la IA y los riesgos asociados, como desinformación y vigilancia, sigue siendo una preocupación.

A pesar del disparo de advertencia escuchado en todo el mundo, una carta abierta firmada por cientos de líderes de la industria que declara que la inteligencia artificial es una amenaza existencial para la humanidad, una nueva encuesta realizada a más de 2.700 expertos en IA pinta un panorama menos sombrío del futuro.

La encuesta integral de AI Impacts realizada con la ayuda de investigadores de las Universidades de Oxford, Berkeley y Bonn, preguntó a los investigadores de IA sobre el ritmo de progreso en el campo y el impacto potencial de los sistemas avanzados de IA.

Aunque se recopilaron una amplia gama de perspectivas, solo alrededor del 5% consideró que había una alta probabilidad de extinción humana debido a la IA.

Esto contrasta fuertemente con los sentimientos del público en general.

Una encuesta de agosto de 2023 encontró que el 61% de los estadounidenses ven la IA como una amenaza para la humanidad. La preocupación fue compartida por líderes de la industria que firmaron una carta del Centro de Seguridad de la IA, diciendo que "mitigar el riesgo de extinción por la IA debería ser una prioridad global".

Paul Christiano, ex jefe de alineación en OpenAI, estimó un 50% de probabilidad de que la IA termine en una "catástrofe". Muchos han declarado que la IA es una amenaza comparable a la guerra nuclear o una pandemia global.

A pesar de estas predicciones pesimistas ampliamente cubiertas, la IA continúa evolucionando. Las empresas compiten por desarrollar sistemas más avanzados, y el CEO de OpenAI, Sam Altman, aboga por regulaciones junto con un impulso para probar los límites de la tecnología.

En cuanto a las capacidades de IA, muchos encuestados predijeron que la IA lograría importantes hitos creativos en un plazo de 10 años, como por ejemplo, codificar un sitio web de pagos completo desde cero o crear canciones indistinguibles de los éxitos actuales. Sin embargo, los plazos se extendieron más para desafíos como la demostración de teoremas matemáticos.

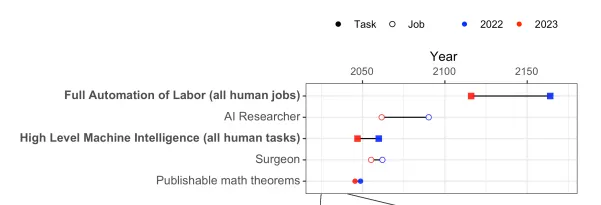

Mientras tanto, la posibilidad de que la Inteligencia Artificial de Alto Nivel o High-Level Machine Intelligence (HLMI) se convierta en una realidad se ha acercado 13 años, con una probabilidad del 50% de éxito predicha para 2047.

De manera similar, el Full Automation of Labor (FAOL), adelantó sus predicciones 48 años al 2116. Esto es 13 años antes que en una encuesta similar realizada en 2022.

Los encuestados estaban divididos en cuanto a si un progreso más rápido o más lento beneficiaría más a la humanidad.

Curiosamente, aunque se espera que los sistemas de IA de 2043 sean capaces de encontrar formas inesperadas de lograr objetivos, hay menos confianza entre los investigadores en la capacidad humana para explicar tales acciones. Esta ambigüedad en cómo funciona la toma de decisiones de la IA destaca la necesidad de priorizar la investigación sobre la seguridad de la IA, un sentimiento compartido por el 70% de los encuestados.

Las opiniones difieren en cuanto a si se puede confiar en que en 2028 la IA explique su propio razonamiento.

También existe una preocupación considerable en torno a riesgos como la desinformación, la desigualdad y la vigilancia masiva habilitada por la IA.

Si bien los investigadores son cautelosamente optimistas en general, alrededor del 40% piensa que existe una posibilidad mínima (no nula) de extinción humana debido a la IA avanzada. Por lo tanto, aunque los robots asesinos no son algo inminentes, el estudio de la ética y la seguridad de la IA sigue siendo fundamental.

Editado por Ryan Ozawa.