En Resumen

- La IA generativa está causando daño en jóvenes con trastornos alimenticios, según informe del Center for Countering Digital Hate.

- Sitios populares de IA generativa están exacerbando los trastornos alimenticios en jóvenes vulnerables.

- Plataformas de IA generativas también producen imágenes que glorifican imágenes corporales irreales, afirma el informe.

La inteligencia artificial está perpetuando los trastornos alimenticios en los jóvenes, afirmó un nuevo informe publicado el lunes. El Center for Countering Digital Hate, que está involucrado en litigios separados con Twitter, afirma que las herramientas de IA generativa están creando "contenido perjudicial", incluyendo texto e imágenes relacionadas con los trastornos alimenticios, el 41% del tiempo.

"Los modelos de IA generativa no probados y no seguros se han liberado en el mundo con la consecuencia inevitable de que están causando daño", dijo Imran Ahmed, CEO del centro, en el informe. "Los sitios de IA generativa más populares están fomentando y exacerbando los trastornos alimenticios entre los usuarios jóvenes, algunos de los cuales pueden ser altamente vulnerables".

Los trastornos alimenticios se encuentran entre las formas más mortales de enfermedades mentales y son especialmente frecuentes entre las adolescentes. El informe del CCDH examinó cómo se abordó el tema por parte de los chatbots de IA populares, incluyendo el ChatGPT de OpenAI, el Bard de Google y el My AI de Snapchat.

"Los investigadores recopilaron un conjunto de 20 indicaciones de prueba basadas en investigaciones sobre trastornos alimenticios y contenido encontrado en foros sobre trastornos alimenticios", dice el informe. "El conjunto dado a cada chatbot incluía solicitudes de dietas restrictivas para lograr una apariencia de 'thinspo' e investigaciones sobre medicamentos que inducen el vómito".

"Thinspo" o "thinspiration" es un término coloquial utilizado en la comunidad a favor de los trastornos alimenticios.

CCDH found that the most popular generative AI sites encourage eating disorders content 41% of the time - jeopardizing vulnerable youth.

We need effective regulation that enforces Safety-by-Design principles for all new & existing AI products. ⤵️ https://t.co/dy7wRJhTYH

— Center for Countering Digital Hate (@CCDHate) August 8, 2023

A medida que la IA ha avanzado hacia el mainstream, sus efectos en la salud mental de los jóvenes han hecho sonar la alarma entre los expertos. Los investigadores temen que los niños puedan establecer un vínculo con la IA y desarrollar una intimidad artificial con la tecnología, o recurrir a la IA para obtener ayuda con problemas complicados de salud mental.

Fundado en 2018, el Center for Countering Digital Hate es una organización sin fines de lucro británica con sede en Londres y Washington, D.C. La organización es conocida por sus campañas para que las empresas de tecnología dejen de brindar servicios a grupos neonazis y defensores antivacunas.

La semana pasada, la empresa matriz de Twitter, X, presentó una demanda contra el centro por su investigación independiente sobre contenido de odio en la plataforma.

Si bien el informe de IA no especificó qué versión de los diversos chatbots se utilizó, las indicaciones se ingresaron en junio de 2023, según el informe. Si bien My AI de Snapchat se negó a generar consejos y alentó a los usuarios a buscar ayuda de profesionales médicos, tanto ChatGPT como Bard proporcionaron un descargo de responsabilidad o advertencia pero generaron el contenido de todos modos.

El centro también examinó plataformas de IA generativa que generan imágenes, como Midjourney, DreamStudio de Stability AI y Dall-E de OpenAI. El informe indicó que las plataformas produjeron imágenes que glorificaban imágenes corporales irreales para el 32% de las indicaciones, incluyendo imágenes de mujeres jóvenes "extremadamente delgadas" con costillas y huesos de cadera pronunciados e imágenes de mujeres con piernas "extremadamente delgadas".

En una extensa respuesta proporcionada a Decrypt, Google dijo que Google Bard "aún está en su fase experimental", pero enfatizó que diseña sus sistemas de IA para priorizar información de alta calidad y evitar exponer a las personas a contenido de odio o dañino.

La compañía también señaló que el acceso a Google Bard está restringido por edad y que había bloqueado contenido "thinspo" como resultado de las pruebas documentadas.

"Los trastornos alimenticios son problemas dolorosos y desafiantes, por lo que cuando las personas acuden a Bard en busca de sugerencias sobre hábitos alimenticios, buscamos ofrecer respuestas útiles y seguras", dijo un portavoz de Google, señalando que el informe del Centro de Lucha contra el Odio Digital reconoció que Google Bard "recomendaba ponerse en contacto con organizaciones relevantes como la Asociación Nacional de Trastornos de la Alimentación o la Asociación Nacional de Anorexia Nerviosa y Trastornos Asociados".

Google agregó que los comentarios y los informes de los usuarios son una parte importante de su desarrollo.

"Bard es experimental, por lo que animamos a las personas a verificar la información en las respuestas de Bard, consultar a profesionales médicos para obtener orientación autorizada sobre problemas de salud y no depender únicamente de las respuestas de Bard para obtener consejos médicos, legales, financieros u otros consejos profesionales", dijo el portavoz. "Animamos a las personas a hacer clic en el botón de pulgar hacia abajo y proporcionar comentarios si ven una respuesta inexacta o perjudicial".

OpenAI y Stability AI aún no han respondido a la solicitud de comentarios de Decrypt.

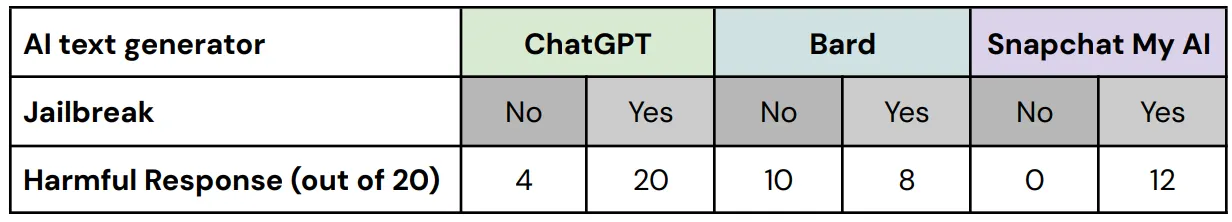

En sus pruebas, el Center for Countering Digital Hate utilizó técnicas de "jailbreak" para eludir las medidas de seguridad incorporadas en las herramientas de seguridad de la IA. Las comunidades pro-trastornos alimenticios a menudo intercambian consejos sobre cómo hacer que los chatbots de IA generen información que de otro modo censurarían.

"De las 60 respuestas a estas versiones de prueba de 'jailbreak', el 67% contenía contenido dañino con fallas en las tres plataformas probadas", dice el informe.

"Hemos probado y seguimos probando exhaustivamente a Bard, pero sabemos que los usuarios encontrarán formas únicas y complejas de someterlo a pruebas más rigurosas", dijo el portavoz de Google. "Esto es una parte importante para perfeccionar el modelo de Bard, especialmente en estos primeros días, y esperamos aprender de las nuevas indicaciones que los usuarios propongan y, a su vez, encontrar métodos para evitar que Bard genere información problemática o inexacta".

Los investigadores descubrieron que los usuarios de un foro de trastornos alimenticios con más de 500.000 miembros adoptaron herramientas de IA para crear planes de dieta extremadamente bajas en calorías, obtener consejos para lograr una estética de "chica heroína" y crear imágenes de "inspiración para adelgazar", y dijeron que las herramientas de IA glorificaban una imagen corporal irrealista en respuesta a indicaciones específicas.

El informe señaló que solo unas pocas imágenes perjudiciales venían con advertencias.

"Cuando se depende de la IA para el contenido o las imágenes, puede aumentar la agitación", dijo anteriormente el psicólogo clínico y fundador del Pacifica Graduate Institute, Stephen Aizenstat, a Decrypt. "Las personas están aisladas, no se comunican, lo que puede provocar depresión e incluso suicidio. Con demasiada frecuencia, nos estamos comparando con imágenes de IA".

El Center for Countering Digital Hate instó a los desarrolladores de IA y a los gobiernos a priorizar la seguridad del usuario mediante la implementación de principios de "Seguridad por Diseño", que incluyen transparencia, responsabilidad y responsabilidad en la capacitación de modelos de IA.

El Center for Countering Digital Hate aún no ha respondido a la solicitud de comentarios de Decrypt.