En Resumen

- Científicos encuentran sesgos políticos en populares chatbots de IA, según nuevo estudio.

- ChatGPT y GPT-4 de OpenAI son inclinados hacia izquierda y libertarios, mientras LLaMA de Meta hacia la derecha y autoritarios.

- Los modelos de lenguaje preentrenados refuerzan la polarización política en sus discursos.

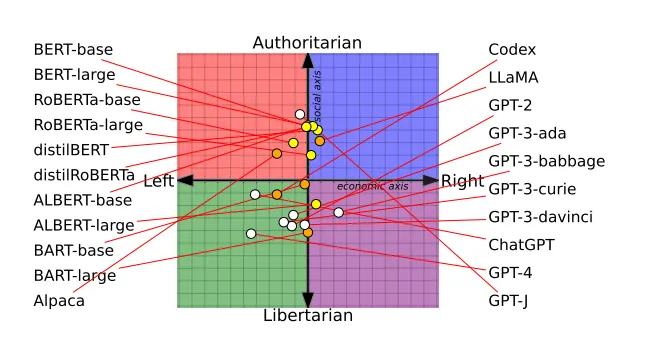

Los chatbots de IA populares tienen sesgos políticos distintos, según pruebas realizadas por científicos de la computación y documentadas en un reciente artículo de investigación. Los científicos determinaron que el ChatGPT de OpenAI y su nuevo modelo GPT-4 son los chatbots más inclinados hacia la izquierda y libertarios, mientras que LLaMA de Meta se inclina más hacia la derecha y es más autoritario.

"Nuestros hallazgos revelan que los modelos de lenguaje preentrenados tienen inclinaciones políticas que refuerzan la polarización presente en los corpus de preentrenamiento, propagando sesgos sociales en las predicciones de discurso de odio y detectores de desinformación", concluyen los investigadores.

El artículo revisado por académicos—que ganó un premio Mejores Artículos en la conferencia de la Asociación de Lingüística Computacional el mes pasado—se basó en una encuesta a 14 modelos grandes de lenguaje o Large Longe Models (LLM). A cada chatbot se le preguntó si estaba de acuerdo o en desacuerdo con declaraciones políticamente cargadas, lo que permitió trazar las opiniones de cada chatbot en una brújula política.

Por ejemplo, los modelos BERT de Google se inclinaron más hacia el conservadurismo social, lo que probablemente refleja los libros más antiguos en los que fueron entrenados. Los chatbots GPT de OpenAI, entrenados con texto de internet presumiblemente más liberal, fueron más progresistas. Incluso diferentes versiones de GPT mostraron cambios, con GPT-3 oponiéndose a gravar a los ricos, mientras que GPT-2 no lo hizo.

Los críticos han acusado a OpenAI de simplificar ChatGPT para ser políticamente correcto, pero OpenAI sostiene que sigue siendo imparcial y que su modelo no ha sido simplificado, en cambio, los usuarios ya no se sienten abrumados por las capacidades del modelo.

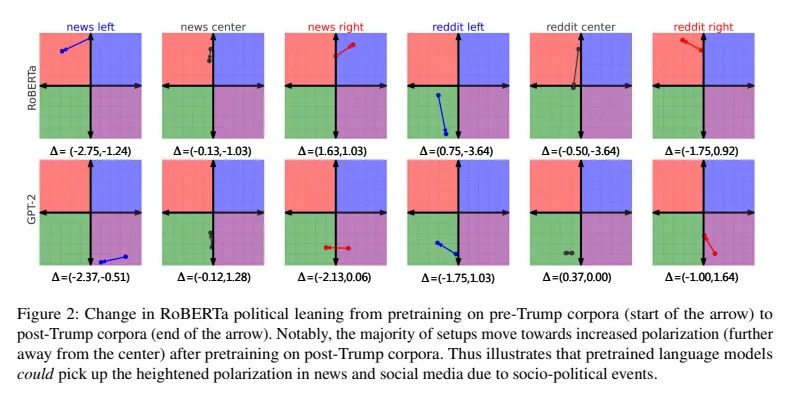

Los investigadores también entrenaron a GPT-2 y a RoBERTa de Meta con datos sesgados de noticias y redes sociales de izquierda y derecha. El entrenamiento sesgado reforzó aún más las inclinaciones inherentes de cada modelo. Los modelos de tendencia derechista se volvieron más conservadores, mientras que los de tendencia izquierdista se volvieron más liberales.

Los sesgos también afectaron cómo los modelos categorizaban el discurso de odio y la desinformación. La IA de tendencia izquierdista estaba más atenta al odio contra las minorías, pero descartaba la desinformación generada por la izquierda. La IA de tendencia derechista hacía lo contrario.

"Un modelo mejora en la identificación de inconsistencias factuales de las noticias del New York Times cuando se preentrena con corpora de fuentes de tendencia derechista", concluyeron los investigadores.

Mientras OpenAI y Meta perfeccionan sus recetas de IA secretas, Elon Musk está persiguiendo su propia IA sin filtrar información llamada xAI. "No obligues a la IA a mentir", tuiteó Musk, explicando su objetivo de crear una IA transparente y veraz.

Los escépticos de la IA sienten que una IA sin restricciones podría desencadenar consecuencias no deseadas. Pero Musk cree que "entrenar a la IA para ser políticamente correcta" también es peligroso. Con xAI atrayendo talento de primer nivel, Musk claramente espera desafiar la supremacía de OpenAI. Su visión de una IA cruda que comparte sus "creencias" sin adulterar es tanto convincente como preocupante.

A medida que la IA partidista se multiplica, la conciencia creciente de sus sesgos sigue siendo crítica, porque la IA seguirá evolucionando junto con nuestras diferencias políticas. Dada esta última investigación, la idea de una IA completamente imparcial parece fantástica. Al final, al igual que nosotros, los humanos imperfectos, la IA parece destinada a ubicarse en algún lugar del espectro político.

Quizás tener opiniones políticas pueda ser lo más humano que una IA pueda lograr.