La start-up parisienne Mistral AI, qui a récemment revendiqué une valorisation de 2 milliards de dollars, a lancé Mixtral, un modèle de langage large (LLM) ouvert qui, selon elle, surpasse le GPT 3.5 d'OpenAI dans plusieurs benchmarks tout en étant beaucoup plus efficace.

Mistral a bénéficié d'un investissement substantiel de la série A de la part d'Andreessen Horowitz (a16z), une société de capital-risque réputée pour ses investissements stratégiques dans les secteurs technologiques transformateurs, en particulier l'IA. D'autres géants de la technologie comme Nvidia et Salesforce ont également participé à la levée de fonds.

«Mistral est au centre d'une petite mais passionnée communauté de développeurs qui se développe autour de l'IA open source», a déclaré Andreessen Horowitz dans son annonce de financement. «Les modèles affinés par la communauté dominent maintenant régulièrement les classements open source (et battent même les modèles à code source fermé sur certaines tâches).»

Mixtral utilise une technique appelée «mélange d'experts» (MoE), que Mistral affirme rendre le modèle plus puissant et plus efficace que son prédécesseur, Mistral 7b - et même ses concurrents plus puissants.

Un mélange d'experts (MoE) est une technique d'apprentissage automatique dans laquelle les développeurs entraînent ou mettent en place plusieurs modèles d'experts virtuels pour résoudre des problèmes complexes. Chaque modèle d'expert est formé sur un sujet ou un domaine spécifique. Lorsqu'il est confronté à un problème, le modèle sélectionne un groupe d'experts parmi un ensemble d'agents, et ces experts utilisent leur formation pour décider quelle sortie correspond le mieux à leur expertise.

Le MoE peut améliorer la capacité, l'efficacité et la précision des modèles d'apprentissage profond - l'ingrédient secret qui distingue Mixtral du reste, capable de rivaliser avec un modèle formé sur 70 milliards de paramètres en utilisant un modèle 10 fois plus petit.

«Mixtral dispose de 46,7 milliards de paramètres au total, mais n'utilise que 12,9 milliards de paramètres par jeton», a déclaré Mistral AI. «Il traite donc les entrées et génère les sorties à la même vitesse et pour le même coût qu'un modèle de 12,9 milliards».

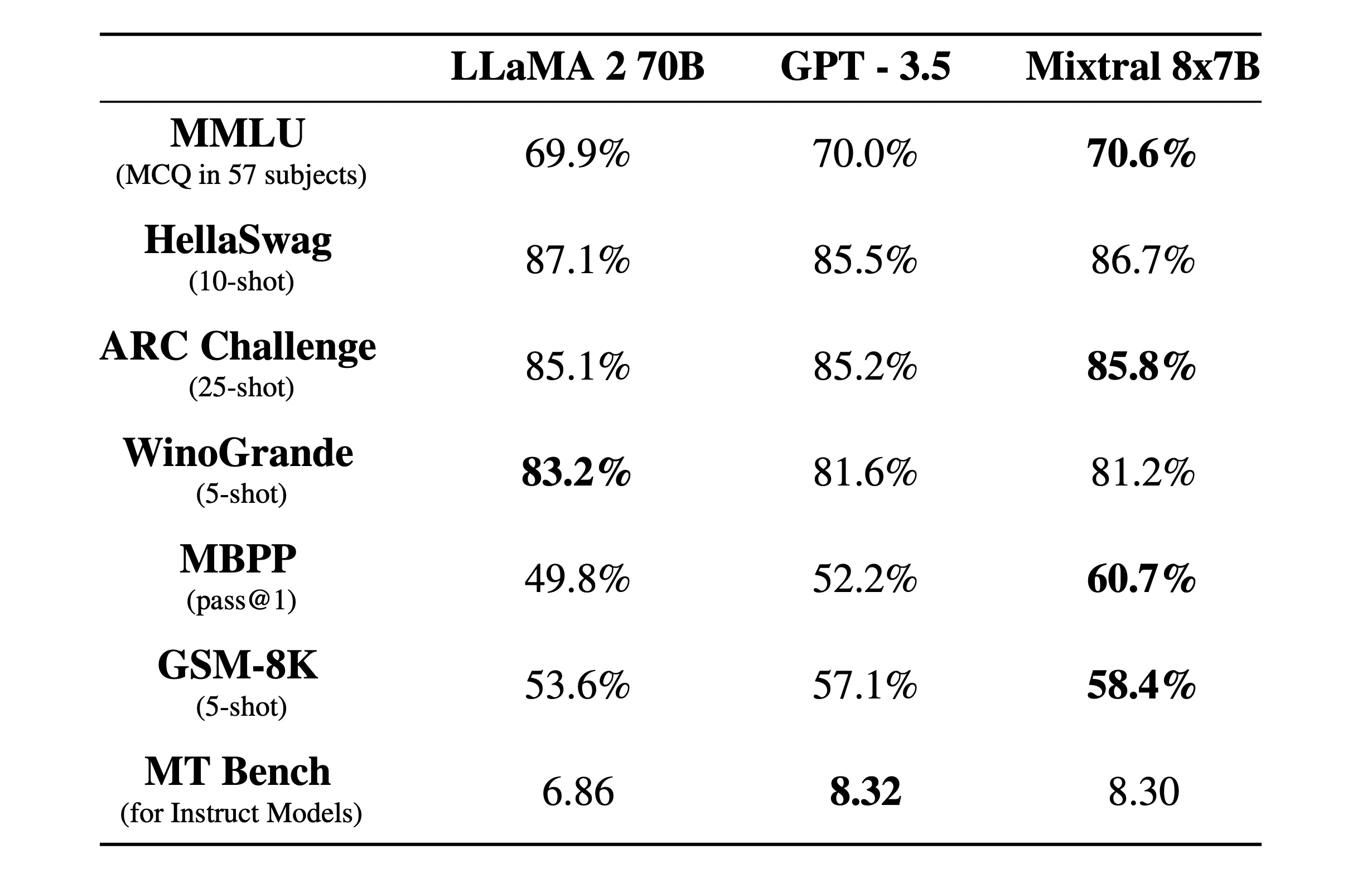

«Mixtral surpasse Llama 2 70B sur la plupart des benchmarks avec une inférence 6 fois plus rapide et égale ou supérieure à GPT 3.5 sur la plupart des benchmarks standard», a déclaré Mistral AI dans un article de blog officiel.

Mixtral est également sous licence Apache 2.0 permissive. Cela permet aux développeurs d'inspecter, d'exécuter, de modifier et même de créer des solutions personnalisées sur la base du modèle.

Il y a cependant un débat sur le fait que Mixtral soit ou non 100% open source, car Mistral affirme n'avoir publié que des «poids ouverts» et que la licence du modèle de base empêche son utilisation pour concurrencer Mistral AI. La start-up n'a pas non plus fourni l'ensemble de données d'entraînement et le code utilisé pour créer le modèle, ce qui serait le cas dans un projet open source.

La société affirme que Mixtral a été optimisé pour fonctionner exceptionnellement bien dans les langues étrangères autres que l'anglais. «Mixtral 8x7B maîtrise le français, l'allemand, l'espagnol, l'italien et l'anglais», obtenant de bons résultats dans les benchmarks multilingues standardisés, a déclaré Mistral AI.

Une version instruite appelée Mixtral 8x7B Instruct a également été publiée pour une instruction minutieuse, obtenant un score élevé de 8,3 sur le benchmark MT-Bench. Cela en fait le meilleur modèle open source actuel sur le benchmark.

Le nouveau modèle de Mistral promet une architecture révolutionnaire de mélange d'experts clairsemés, de bonnes capacités multilingues et un accès ouvert complet. Et compte tenu du fait que cela s'est produit quelques mois seulement après sa création, la communauté open source vit une période passionnante et intéressante.

Mixtral est disponible en téléchargement via Hugging Face, mais les utilisateurs peuvent également utiliser la version instructive en ligne.

Édité par Ryan Ozawa.