Dans le monde en constante évolution de la technologie, les initiatives d'Elon Musk ne manquent jamais de faire sensation. Quelques semaines après son appel retentissant à mettre fin à la formation de LLM plus performants que GPT-4, Musk a joué son coup habituel : faire exactement le contraire de ce qu'il prêchait. Voici xAI, la dernière création de Musk, et Grok, son tout nouveau LLM annoncé samedi.

Announcing Grok!

Grok is an AI modeled after the Hitchhiker’s Guide to the Galaxy, so intended to answer almost anything and, far harder, even suggest what questions to ask!

Grok is designed to answer questions with a bit of wit and has a rebellious streak, so please don’t use…

— xAI (@xai) November 5, 2023

Cette initiative a fait les gros titres, non seulement en raison de l'implication de Musk, mais aussi grâce à l'équipe de chercheurs en IA de premier plan que l'entreprise a réussi à recruter parmi les start-ups et les géants de la technologie les plus réputés. Présentée avec l'alléchante promesse d'une IA capable de «comprendre le monde», xAI est restée mystérieusement discrète sur le «comment» et le «quoi» de ses opérations... du moins jusqu'à la semaine dernière.

Est-ce un autre coup classique de Musk pour défier le statu quo, ou simplement un chatbot surestimé surfant sur la vague de popularité et d'engouement entourant ses prédécesseurs ?

Les points positifs

Un flux constant de connaissances en temps réel

Avoir accès à l'ensemble du flux de contenu de Twitter fait de Grok un potentiel bouleverseur de jeu. Comme l'a souligné xAI, Grok aura une «connaissance en temps réel du monde», présentant ce que les chercheurs en IA appellent l'apprentissage par renforcement à partir des commentaires humains (RLHF), traitant les actualités et les commentaires divers sur les événements actuels.

En apprenant des événements à partir de différents points de vue et en ingérant les notes de la communauté Twitter - qui sont essentiellement des annotations - Grok bénéficiera d'une vision multifacette du monde.

Selon des études récentes, les gens ont déjà modifié leur comportement pour chercher d'abord des informations sur les réseaux sociaux avant de se tourner vers les médias traditionnels. L'intégration de Grok avec Twitter pourrait accélérer davantage ce processus, offrant aux utilisateurs des commentaires immédiats, du contexte et, si bien exécuté, des vérifications de faits sur place. La fonctionnalité de connaissance en temps réel, comme l'a souligné xAI, garantit que Grok reste à jour avec le pouls du monde, lui permettant de fournir des réponses opportunes et pertinentes.

Mode amusant : le rêve d'Elon devenu réalité

La vision d'Elon Musk d'une IA amusante semble avoir été concrétisée avec le soi-disant «Mode Fun» de Grok. Cette fonctionnalité permet à l'LLM de créer des blagues, de fournir des réponses humoristiques mais factuellement précises, et d'offrir aux utilisateurs une expérience conversationnelle fantaisiste et décontractée.

Un des défis avec les LLM existants, comme ChatGPT, est que certains utilisateurs estiment qu'ils ont été trop censurés pour garantir la politiquement correct, ce qui peut rendre les interactions moins organiques et spontanées. De plus, certains LLM localisés ne sont pas doués pour les interactions prolongées. Grok, avec son mode fun, promet de combler cette lacune, en servant potentiellement de passe-temps captivant pour ceux qui cherchent à se détendre.

Grok has real-time access to info via the 𝕏 platform, which is a massive advantage over other models.

It’s also based & loves sarcasm. I have no idea who could have guided it this way 🤷♂️ 🤣 pic.twitter.com/e5OwuGvZ3Z

— Elon Musk (@elonmusk) November 4, 2023

Ce concept n'est pas entièrement nouveau, car Poe de Quora propose un service similaire avec ses chatbots affinés, chacun ayant une personnalité unique. Cependant, l'intégration de cette fonctionnalité dans un LLM avec les capacités de Grok élève l'expérience à un niveau supérieur.

Accès natif à Internet

L'un des autres points forts de Grok est la possibilité d'accéder à Internet sans nécessiter de plug-in ou autre module.

Alors que l'étendue exacte de ses capacités de navigation reste à clarifier, l'idée est tentante. Imaginez un LLM qui peut améliorer la précision factuelle car il peut recouper les données en temps réel. Associé à son accès au contenu de Twitter, Grok pourrait révolutionner la façon dont les utilisateurs interagissent avec l'IA, sachant que les informations qu'ils reçoivent ne sont pas seulement basées sur des données d'entraînement préexistantes, mais sont continuellement mises à jour et vérifiées.

Multi-tâches

On dit que Grok est capable de multitâches, ce qui permet aux utilisateurs de mener plusieurs conversations simultanément. Les utilisateurs peuvent explorer différents sujets, attendre une réponse sur un fil de discussion et continuer avec un autre.

Le chatbot offre également des branches dans les conversations, permettant aux utilisateurs d'approfondir des domaines spécifiques sans perturber la discussion principale, offrant un guide visuel de toutes les branches de conversation, ce qui facilite la navigation entre les sujets.

Grok propose également un éditeur de markdown intégré, qui permet aux utilisateurs de télécharger, de modifier et de formater les réponses de Grok pour une utilisation ultérieure. Cet outil, combiné aux branches, garantit aux utilisateurs de travailler avec des branches de conversation spécifiques et de se réengager de manière transparente.

These are some of the UI features in Grok. First, it allows you to multi-task. You can run several concurrent conversations and switch between them as they progress. pic.twitter.com/aXAG0M2oPF

— Toby Pohlen (@TobyPhln) November 5, 2023

Censure minimale : une IA qui parle librement

La vision d'Elon Musk pour Grok était claire : une IA qui ne se dérobe pas pour exprimer son opinion numérique.

Alors que tous les principaux chatbots IA ont des garde-fous pour éviter les dommages potentiels ou la désinformation, cela peut parfois sembler restrictif. Les utilisateurs ont remarqué des cas où des modèles comme ChatGPT, Llama et Claude pourraient retenir leurs réponses, en privilégiant la prudence pour éviter d'éventuelles offenses. Cependant, cela peut filtrer des réponses qui sont bénignes ou sincèrement recherchées.

Grok se voit accorder plus de liberté dans ses réponses et peut ainsi offrir une expérience conversationnelle plus authentique et sans restriction. Comme le souligne xAI, la conception de Grok lui permet de répondre à des questions épicées que d'autres systèmes d'IA pourraient éviter.

Announcing Grok!

Grok is an AI modeled after the Hitchhiker’s Guide to the Galaxy, so intended to answer almost anything and, far harder, even suggest what questions to ask!

Grok is designed to answer questions with a bit of wit and has a rebellious streak, so please don’t use…

— xAI (@xai) November 5, 2023

Il est évident que cette IA offre un mélange unique d'informations en temps réel, d'humour, de précision et de liberté. Cependant, comme pour toute innovation, il y a aussi des défis et des écueils potentiels à prendre en compte.

Les points négatifs

Développement précipité et formation limitée

Dès le départ, le développement rapide de Grok a suscité des interrogations. Comme l'a déclaré xAI, «Grok est encore un produit bêta très précoce - le meilleur que nous ayons pu faire avec deux mois de formation.» Dans le monde des LLM, deux mois et 33 milliards de paramètres semblent être une goutte d'eau dans l'océan.

Pour mettre les choses en perspective, OpenAI a été transparente sur son processus de développement, mentionnant : «Nous avons passé six mois à aligner de manière itérative GPT-4.» La disparité des délais de développement suggère que le développement de Grok a peut-être été précipité pour profiter de l'engouement autour de l'IA.

De plus, x.AI reste discret sur l'étendue du matériel utilisé lors de la formation de Grok, laissant place à la spéculation.

Tout est une question de paramètres

Pour les non-initiés, les paramètres dans les LLM représentent la quantité d'informations ou de connaissances que le modèle peut contenir. Ils indiquent la capacité cérébrale effective de l'IA, déterminant sa capacité à traiter et à générer des informations. Grok, avec ses 33 milliards de paramètres, peut sembler impressionnant au premier coup d'œil.

Cependant, dans le paysage concurrentiel des LLM, c'est juste un autre acteur. En fait, son nombre de paramètres pourrait être insuffisant pour répondre aux besoins complexes des entreprises et aux sorties de haute qualité que des géants comme ChatGPT, Claude et Bard ont établis comme référence.

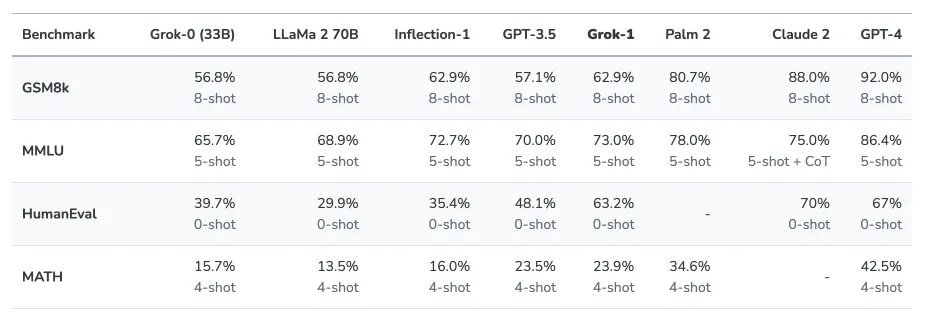

Une partie de ce faible nombre de paramètres est la raison pour laquelle Grok n'arrive pas à battre d'autres modèles populaires dans des benchmarks clés tels que HumanEval ou MMLU:

Outre le nombre de paramètres, il y a aussi la question de la gestion du contexte, c'est-à-dire la quantité d'informations qu'un chatbot IA peut comprendre en une seule entrée. Grok n'est pas particulièrement impressionnant dans ce domaine. Selon xAI, Grok comprend 8 192 jetons de contexte, mais GPT-4 jongle avec un impressionnant 32 000, et Claude va encore plus loin avec jusqu'à 100 000 jetons. Le nouveau GPT-4 Turbo d'OpenAI atteint une fenêtre de contexte de 128 000 jetons.

Le prix de l'innovation

Le coût est un facteur crucial lors de l'évaluation de la valeur de tout produit, et Grok ne fait pas exception. Le chatbot sera disponible pour les utilisateurs prêts à payer 16 $ par mois pour le privilège d'interagir avec lui.

Avec des offres gratuites comme Claude 2 et ChatGPT équipés de GPT-3.5 Turbo, Grok peut être difficile à vendre, d'autant plus que ces modèles gratuits ont été vantés pour leur précision, dépassant déjà Grok dans certains benchmarks.

De plus, même le LLM le plus puissant du marché, GPT-4, promet d'être meilleur que Grok, avec l'avantage supplémentaire d'être largement accessible, multimodal et puissant.

The @xAI Grok AI assistant will be provided as part of 𝕏 Premium+, so I recommend signing up for that.

Just $16/month via web. https://t.co/wEEIZNjEkp

— Elon Musk (@elonmusk) November 4, 2023

L'introduction de Grok pourrait-elle être largement une stratégie visant à stimuler les abonnements à Twitter Blue, amplifiant ainsi les revenus de Twitter ?

Ces préoccupations soulignent les défis auxquels Grok est confronté pour s'imposer comme un acteur majeur dans le domaine du LLM. Et ses inconvénients ne s'arrêtent pas au prix.

Le mauvais

Imitation de la fiction

Basé sur un LLM sur un personnage fictif d'un roman populaire est, sans aucun doute, un choix créatif. Bien que le charme d'une personnalité fictive puisse être séduisant, cela pose des risques inhérents dans un monde qui compte de plus en plus sur des informations précises. Les utilisateurs qui se tournent vers l'IA pour des requêtes sérieuses ou des conseils pourraient se retrouver en désaccord avec un système conçu pour imiter un personnage comique.

De plus, à mesure que la frontière entre la fiction et la réalité s'estompe, il y a une préoccupation concernant les utilisateurs qui confondent les réponses ludiques ou satiriques avec des informations factuelles. À l'ère numérique, où chaque information est disséquée et partagée, les conséquences de telles confusions pourraient être étendues. Surtout lorsque plusieurs langues entrent en jeu.

Bien que l'humour et l'esprit aient leur place, il est essentiel de trouver un équilibre, surtout lorsque les utilisateurs recherchent des informations critiques. Donner la priorité à l'humour plutôt qu'à l'exactitude peut divertir, mais cela mine également l'essence même de ce que devrait offrir un LLM : des informations fiables.

Trop de promesses, pas assez de résultats

Les grandes promesses d'Elon Musk concernant Grok ont créé des attentes très élevées. En creusant davantage, on découvre un écart potentiel entre le battage médiatique et la réalité. Le fait que les méthodes traditionnelles de formation LLM soient contraintes par leurs données d'entraînement souligne une limitation critique : elles ne peuvent pas réellement s'aventurer dans le domaine de l'«IA super».

La formation de Grok, avec ses 33 milliards de paramètres et quelques mois de développement, semble insignifiante comparée à celle des autres géants de l'LLM. Bien que l'idée d'une personnalité ludique et fictive soit séduisante, s'attendre à ce qu'elle produise des résultats révolutionnaires en utilisant des méthodes d'entraînement standard pourrait être exagéré.

La communauté de l'IA n'est pas étrangère à l'exagération, mais avec les avancées rapides dans le domaine, il est crucial pour les utilisateurs de faire le tri dans le battage médiatique. Atteindre le statut d'«IA super» est un défi monumental, et il est peu probable que Grok, avec sa configuration et sa formation actuelles, y parvienne.

En effet, pour prouver la puissance de Grok, Elon Musk a comparé son chatbot conversationnel à un petit LLM formé pour la programmation. Autant dire que ce n'était pas un combat équitable.

Example of Grok vs typical GPT, where Grok has current information, but other doesn’t pic.twitter.com/hBRXmQ8KFi

— Elon Musk (@elonmusk) November 5, 2023

La menace de la désinformation

Les LLM sont puissants, mais ils ne sont pas infaillibles. En l'absence de normes rigoureuses, distinguer le vrai du faux devient une tâche herculéenne. L'histoire récente offre des exemples édifiants, comme des chatbots formés à partir de données de 4chan ou même Tay, un chatbot précédent de Microsoft qui était autorisé à interagir sur Twitter. Ces bots ont non seulement proféré des discours haineux, mais se sont également fait passer de manière convaincante pour une personne réelle, trompant ainsi un vaste public en ligne.

This week an #AI model was released on @huggingface that produces harmful + discriminatory text and has already posted over 30k vile comments online (says it's author).

This experiment would never pass a human research #ethics board. Here are my recommendations.

1/7 https://t.co/tJCegPcFan pic.twitter.com/Mj7WEy2qHl

— Lauren Oakden-Rayner 🏳️⚧️ (@DrLaurenOR) June 6, 2022

Cette flirtation avec la désinformation n'est pas isolée. Avec l'image de Twitter qui en prend un coup depuis la prise de contrôle d'Elon, il peut y avoir des inquiétudes quant à la capacité de Grok à fournir des informations précises de manière cohérente. Les LLM tombent parfois dans des hallucinations, et si ces distorsions sont consommées comme des vérités, les effets en cascade peuvent être alarmants.

Le potentiel de désinformation est une bombe à retardement. À mesure que les utilisateurs s'appuient de plus en plus sur l'IA pour obtenir des informations, la désinformation peut conduire à une prise de décision erronée. Pour que Grok soit un allié de confiance, il doit avancer avec précaution, en veillant à ce que son comportement ludique ne brouille pas la vérité.

Des capacités multimodales manquantes ?

Dans le monde en plein essor de l'IA, l'approche textuelle seule de Grok semble être une relique du passé. Alors que les utilisateurs sont censés payer pour les services de Grok, ils peuvent légitimement se demander pourquoi, surtout lorsque d'autres LLM offrent des expériences multimodales plus riches.

Par exemple, GPT-4-v a déjà fait des avancées dans le domaine multimodal, se vantant de la capacité d'entendre, de voir et de parler. Le Gemini à venir de Google promet une suite similaire de fonctionnalités. Dans ce contexte, les offres de Grok semblent peu convaincantes, soulevant davantage de questions sur sa proposition de valeur.

C'est un marché concurrentiel et les utilisateurs deviennent de plus en plus exigeants. Si Grok souhaite se tailler une place, il doit offrir quelque chose de vraiment exceptionnel. Pour l'instant, avec des concurrents offrant des fonctionnalités améliorées et une meilleure précision - souvent gratuitement - Grok a du pain sur la planche.

Conclusion

Le lancement de Grok a suscité de l'excitation mais a également soulevé un certain scepticisme. Son approche MVP (produit minimum viable) dépouillée permet une itération rapide et une amélioration basée sur les commentaires des utilisateurs. Mais la concurrence des géants de l'IA disposant de ressources beaucoup plus importantes représente un défi de taille.

Pour que Grok réussisse, il a besoin de capacités à la fois nouvelles et utiles. Une simple valeur de divertissement ne suffira pas dans un marché saturé. Les spécialistes de l'IA ne se laissent pas distraire par de mignons mèmes de chiens.

Au final, le destin de Grok dépend de l'équilibre entre l'innovation et la praticité. Bien que le scepticisme soit légitime, le rejeter complètement pourrait être prématuré. Grok pourrait encore ouvrir de nouvelles frontières ou finir par être une note de bas de page dans l'évolution de l'IA. Quoi qu'il en soit, ses origines non conventionnelles garantissent que Grok sera un chapitre intrigant dans l'histoire en cours de l'intelligence artificielle.

Édité par Ryan Ozawa.