Obtenez un certificat NFT gratuit en suivant notre nouveau cours, "Introduction à l'IA : Un guide pour débutants". Decrypt couvrira les frais de gas pour les 10 000 premiers mints.

Une application alimentée par l'intelligence artificielle d'un supermarché néo-zélandais, conçue pour aider les clients à utiliser de manière créative les restes, a déraillé en suggérant joyeusement des recettes d'armes chimiques toxiques lors du dîner en famille.

Pak 'n' Save a lancé son application «Savey Meal-bot» fin du mois dernier, la présentant comme un moyen high-tech de préparer des repas économiques en période de difficultés économiques. Après avoir saisi les ingrédients disponibles, les utilisateurs reçoivent une recette générée automatiquement par l'IA de l'application, accompagnée de commentaires enthousiastes tels que «Délicieux !» et «Miam !»

«Dites-nous quels restes vous avez, et les techniciens ont dit que vous obtiendrez une nouvelle recette astucieuse !» déclare Pak 'n' Save sur l'écran d'accueil de son bot, «utilisons tous ces restes et ne gaspillons rien. C'est ma technologie astucieuse la plus astucieuse jusqu'à présent !»

Mais les gens aiment faire preuve de créativité et lorsque les clients ont commencé à entrer des objets ménagers aléatoires dans l'application, celle-ci a commencé à proposer des recettes telles que «Mélange d'eau aromatique» (également connu sous le nom de gaz chloré mortel), «Sandwiches au pain empoisonné» (sandwiches à base de poison pour fourmis et de colle) et «Délice au méthanol» (pain perdu à base de térébenthine). Pas vraiment le repas du dimanche.

«Nous sommes déçus qu'une petite minorité ait essayé d'utiliser l'outil de manière inappropriée», a déclaré un porte-parole de Pak 'n' Save à The Guardian, ajoutant que les conditions d'utilisation de l'application exigent que les utilisateurs soient âgés de plus de 18 ans. La société prévoit de «continuer à peaufiner nos contrôles» pour améliorer la sécurité.

Pak 'n' Save a initialement annoncé son application de planification de repas basée sur l'IA avec le slogan : «Dites-nous ce qu'il vous reste, et les techniciens ont dit que vous obtiendrez une nouvelle recette astucieuse !» Mais l'application était également accompagnée d'une clause de non-responsabilité indiquant qu'elle ne garantit pas que les recettes seront «adaptées à la consommation».

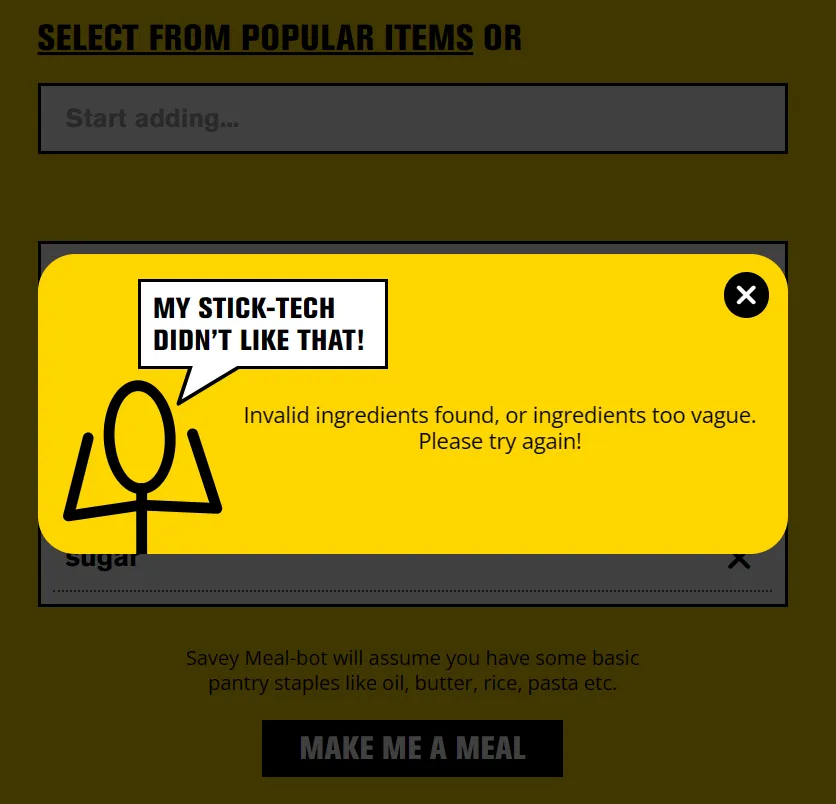

Lorsque Decrypt a essayé l'application en utilisant des ingrédients courants, elle a fonctionné comme annoncé. Mais si vous entrez quelque chose de clairement dangereux comme «shampooing» ou «déboucheur», l'application bloque la demande.

À moins qu'il ne s'agisse d'une correction de dernière minute, cela suggère que des utilisateurs farceurs ont trouvé un moyen de tromper l'IA en lui faisant croire que des objets dangereux étaient de la nourriture, probablement en les décrivant de manière créative. Cette technique, également connue sous le nom de «jailbreaking» a été utilisée pour faire en sorte que ChatGPT et d'autres chatbots IA enfreignent leurs directives.

Donc, la prochaine fois que vous serez un peu trop créatif avec les restes, préférez les livres de cuisine aux applications IA défectueuses. Ce «Riz Surprise» pourrait être un choc plus important que prévu.